| 【程序员必须掌握的算法】【Matlab智能算法】GRNN神经网络 | 您所在的位置:网站首页 › 累积分布函数求优化神经网络 › 【程序员必须掌握的算法】【Matlab智能算法】GRNN神经网络 |

【程序员必须掌握的算法】【Matlab智能算法】GRNN神经网络

|

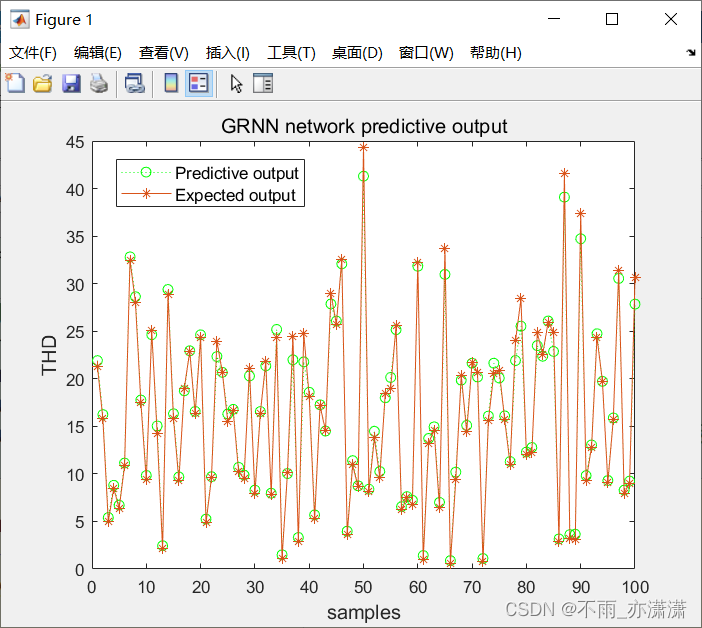

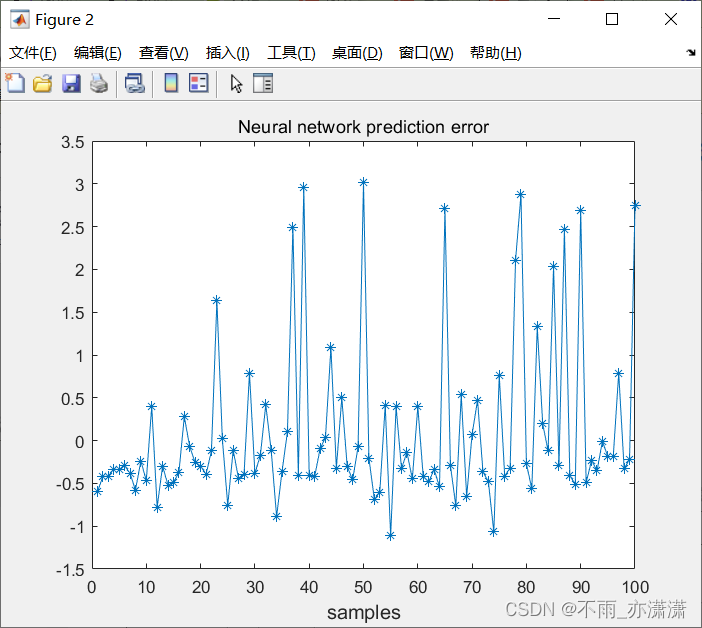

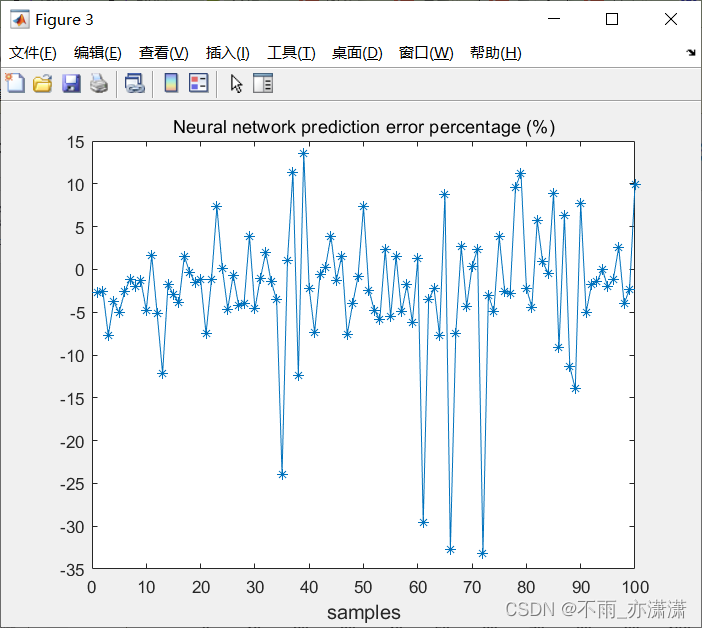

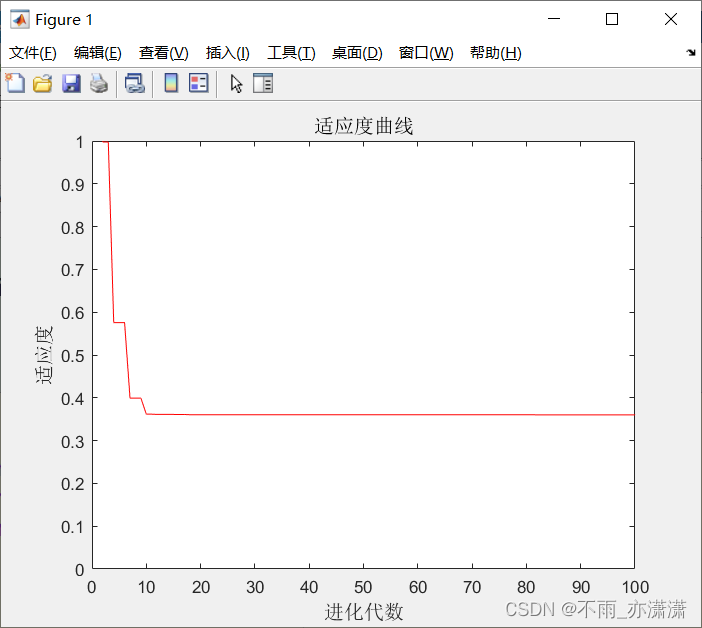

上一篇博客介绍了BP-GA:BP神经网络遗传算法(BP-GA)函数极值寻优——非线性函数求极值,神经网络用的是BP神经网络,本篇博客将BP神经网络替换成GRNN神经网络(广义回归神经网络),希望能帮助大家快速入门GRNN网络。 文章目录 1.背景条件2.GRNN神经网络(广义回归神经网络)函数说明newgrnn 3.最优参数spread的确定4.完整代码data.mGRNN.mCode.mfun.mSelect.mCross.mtest.mMutation.mGenetic.m 5.代码使用说明上述代码运行顺序求最大值的方法 6.代码运行结果GRNN神经网络拟合遗传算法寻优 资源下载参考 1.背景条件要求:对于未知模型(函数表达式未知)求解极值。 条件:已知模型的一些输入输出数据。 程序的示例是根据用神经网络遗传算法寻优非线性函数 y = x 1 2 + x 2 2 y = x_1^2+x_2^2 y=x12+x22 的极值,输入参数有2个,输出参数有1个,易知函数有极小值0,极小值点为(0, 0)。已知的只有一些输入输出数据(用rand函数生成输入,然后代入表达式生成输出): for i=1:4000 input(i,:)=10*rand(1,2)-5; output(i)=input(i,1)^2+input(i,2)^2; end 2.GRNN神经网络(广义回归神经网络)函数说明 newgrnnGRNN神经网络参数设置函数 函数形式: net = newgrnn(P,T,spread)P:输入数据矩阵。 T:输出数据矩阵。 spread:径向基函数的扩展速度。对GRNN网络来说,当确定了学习样本,则相应的网络结构和各神经元之间的连接权值也就确定出来,网络的训练实际上只是确定平滑参数的过程。GRNN网络中的即相当于径向基函数的分布密度SPREAD。一般情况下,SPREAD越大,逼近过程就越平滑,但误差也增大;SPREAD越小,函数逼近越精确,但逼近过程也越不平滑。 例如: net=newgrnn(inputn,outputn,0.1)GRNN神经网络和BP网络都可以用于预测,但对具体的网络训练来说,GRNN需要调整的参数较少,只有一个 spread 参数,因此可以更快地预测网络,具有较大的计算优势。 3.最优参数spread的确定为了找到最优参数,可采用交叉验证的方法。 %% 清空环境变量 clc; clear all close all nntwarn off; %% 载入数据 load data; %从1到4000间随机排序 k=rand(1,4000); [m,n]=sort(k); p_train=input(n(1:3900),:); t_train=output(n(1:3900),:); p_test=input(n(3901:4000),:); t_test=output(n(3901:4000),:); %% 交叉验证 desired_spread=[]; mse_max=10e20; desired_input=[]; desired_output=[]; result_perfp=[]; indices = crossvalind('Kfold',length(p_train),4); h=waitbar(0,'正在寻找最优化参数....') k=1; for i = 1:4 perfp=[]; disp(['以下为第',num2str(i),'次交叉验证结果']) test = (indices == i); train = ~test; p_cv_train=p_train(train,:); t_cv_train=t_train(train,:); p_cv_test=p_train(test,:); t_cv_test=t_train(test,:); p_cv_train=p_cv_train'; t_cv_train=t_cv_train'; p_cv_test= p_cv_test'; t_cv_test= t_cv_test'; [p_cv_train,minp,maxp,t_cv_train,mint,maxt]=premnmx(p_cv_train,t_cv_train); p_cv_test=tramnmx(p_cv_test,minp,maxp); for spread=0.1:0.1:2; net=newgrnn(p_cv_train,t_cv_train,spread); waitbar(k/80,h); disp(['当前spread值为', num2str(spread)]); test_Out=sim(net,p_cv_test); test_Out=postmnmx(test_Out,mint,maxt); error=t_cv_test-test_Out; disp(['当前网络的mse为',num2str(mse(error))]) perfp=[perfp mse(error)]; if mse(error)pmutation continue; end flag=0; while flag==0 % 变异位置 pick=rand; while pick==0 pick=rand; end pos=ceil(pick*sum(lenchrom)); %随机选择了染色体变异的位置,即选择了第pos个变量进行变异 v=chrom(i,pos); v1=v-bound(pos,1); v2=bound(pos,2)-v; pick=rand; %变异开始 if pick>0.5 delta=v2*(1-pick^((1-pop(1)/pop(2))^2)); chrom(i,pos)=v+delta; else delta=v1*(1-pick^((1-pop(1)/pop(2))^2)); chrom(i,pos)=v-delta; end %变异结束 flag=test(lenchrom,bound,chrom(i,:)); %检验染色体的可行性 end end ret=chrom; Genetic.m %% 清空环境变量 clc % clear %% 初始化遗传算法参数 %初始化参数 maxgen=100; %进化代数,即迭代次数 sizepop=20; %种群规模 pcross=[0.4]; %交叉概率选择,0和1之间 pmutation=[0.2]; %变异概率选择,0和1之间 lenchrom=[1 1]; %每个变量的字串长度,如果是浮点变量,则长度都为1 bound=[-5 5;-5 5]; %数据范围 individuals=struct('fitness',zeros(1,sizepop), 'chrom',[]); %将种群信息定义为一个结构体 avgfitness=[]; %每一代种群的平均适应度 bestfitness=[]; %每一代种群的最佳适应度 bestchrom=[]; %适应度最好的染色体 %% 初始化种群计算适应度值 % 初始化种群 for i=1:sizepop %随机产生一个种群 individuals.chrom(i,:)=Code(lenchrom,bound); x=individuals.chrom(i,:); %计算适应度 individuals.fitness(i)=fun(x); %染色体的适应度 end %找最好的染色体 [bestfitness bestindex]=min(individuals.fitness); bestchrom=individuals.chrom(bestindex,:); %最好的染色体 avgfitness=sum(individuals.fitness)/sizepop; %染色体的平均适应度 % 记录每一代进化中最好的适应度和平均适应度 trace=[avgfitness bestfitness]; %% 迭代寻优 % 进化开始 for i=1:maxgen i % 选择 individuals=Select(individuals,sizepop); avgfitness=sum(individuals.fitness)/sizepop; % 交叉 individuals.chrom=Cross(pcross,lenchrom,individuals.chrom,sizepop,bound); % 变异 individuals.chrom=Mutation(pmutation,lenchrom,individuals.chrom,sizepop,[i maxgen],bound); % 计算适应度 for j=1:sizepop x=individuals.chrom(j,:); %解码 individuals.fitness(j)=fun(x); end %找到最小和最大适应度的染色体及它们在种群中的位置 [newbestfitness,newbestindex]=min(individuals.fitness); [worestfitness,worestindex]=max(individuals.fitness); % 代替上一次进化中最好的染色体 if bestfitness>newbestfitness bestfitness=newbestfitness; bestchrom=individuals.chrom(newbestindex,:); end individuals.chrom(worestindex,:)=bestchrom; individuals.fitness(worestindex)=bestfitness; avgfitness=sum(individuals.fitness)/sizepop; trace=[trace;avgfitness bestfitness]; %记录每一代进化中最好的适应度和平均适应度 end %进化结束 %% 结果分析 [r c]=size(trace); plot([1:r]',trace(:,2),'r-'); title('适应度曲线','fontsize',12); xlabel('进化代数','fontsize',12);ylabel('适应度','fontsize',12); disp('适应度 变量'); x=bestchrom; % 窗口显示 disp([bestfitness x]); 5.代码使用说明 上述代码运行顺序data.m 生成数据(如果已有 input output 数据可跳过), GRNN.m 进行GRNN神经网络训练及函数拟合, Genetic.m(主函数)利用遗传算法求极值。 求最大值的方法上述代码用于求解最小值,对于求解最大值的需求,可以在适应度函数里面,对适应度计算结果求反,把求解最大值的问题转化为求解最小值的问题。 例如:对于非线性函数 y = − ( x 1 2 + x 2 2 ) + 4 y = -(x_1^2+x_2^2)+4 y=−(x12+x22)+4 : for i=1:4000 input(i,:)=10*rand(1,2)-5; output(i)=-(input(i,1)^2+input(i,2)^2)+4; end求最大值时,需要在 fun.m 里面,修改最后一行代码: fitness=-mapminmax('reverse',an,outputps);最终运行找到的极值点为(0.4714, -0.0319),适应度为-3.7554,极值需要对适应度取反,为3.7554。 注意:每次运行结果不尽相同。 6.代码运行结果对 y = x 1 2 + x 2 2 y = x_1^2+x_2^2 y=x12+x22 求极小值 GRNN神经网络拟合运行GRNN.m之后:

输出: errorsum = 64.3379 历时 0.511482 秒。注意:每次运行结果不尽相同。 遗传算法寻优运行主函数 Genetic.m之后:

输出: ... i = 100 适应度 变量 0.3600 0.0066 0.0117最终结果最优个体为(0.0066,0.0117),适应度为 0.3600。 注意:每次运行结果不尽相同。 资源下载下载链接 参考《MATLAB神经网络30个案例分析》 |

【本文地址】