| 神经网络如何提高准确率,神经网络收敛速度慢 | 您所在的位置:网站首页 › 怎么提高网络的速度 › 神经网络如何提高准确率,神经网络收敛速度慢 |

神经网络如何提高准确率,神经网络收敛速度慢

|

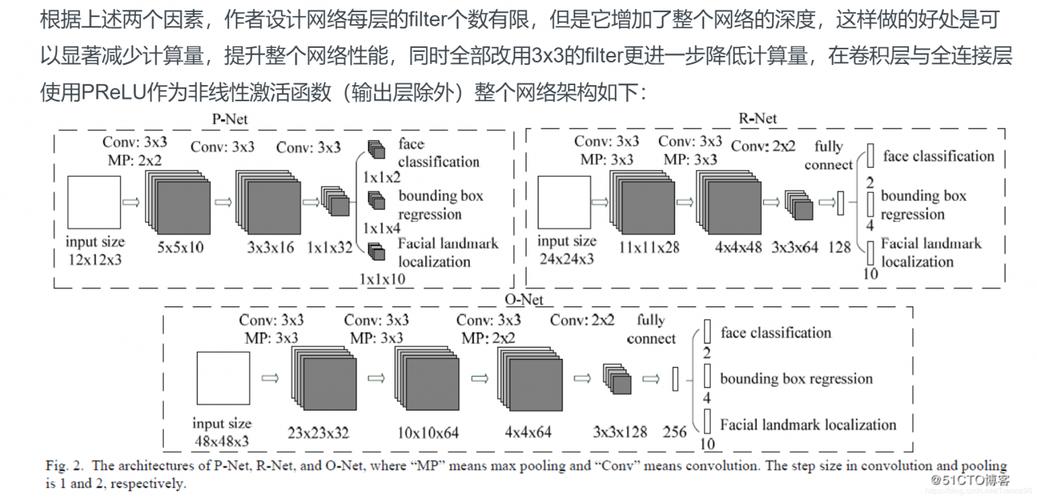

rfid。 神经网络,你先学好高数里的很多级数,如泰勒展开式,傅里叶级数,洛朗级数等这些级数对现实模型都有逼近作用,神经网络最初都是单神经元,如果你对泰勒展开时比较深刻了之后,你就可以很轻松的证明单层感知器的数学动力学原理,之后学习多层感。 神经网络能否较快收敛 神经网络BP算法中,如何选择网络学习效率及阈值调整效率 bp神经网络收敛问题当然是越慢。因为已经接近最低点,训练也进入误差曲面的平坦区,每次搜索的误差下降速度是减慢的。这一点可以在BP神经网络的误差调整公式上看出。 事实上收敛速度逐渐减慢,这是正常的,如果一定要避免这种情况,可以自适应改变学习率。由于传统BP算法的学习速率是固定的,因此网络的收敛速度慢,需要较长的训练时间。 对于一些复杂问题,BP算法需要的训练时间可能非常长,这主要是由于学习速率太小造成的,可采用变化的学习速率或自适应的学习速率加以改进。 BP算法可以使权值收敛到某个值,但并不保证其为误差平面的全局最小值,这是因为采用梯度下降法可能产生一个局部最小值。对于这个问题,可以采用附加动量法来解决。 OPENNN如何加快神经网络训练速度(54个输入,100个隐层,1个输出)?开头注释:针对这些问题,都是在tensorflow框架下,去寻找代码解决问题的。 所以非tensorflow框架下编程的,可以看看出现该类问题的原因,以及解决问题的方向,具体的解决问题的代码需要自行查阅资料。 情况1:训练速度慢针对实体链接任务,搭建了Bi-LSTM+CNN的模型,目前训练速度很慢,半个小时才出一个批次的预测结果。 类比于手写数字识别,无论是使用LSTM,还是CNN,都不会很慢,最慢的至少在10分钟内能出每一个批次的预测结果。 bp神经网络提高泛化能力?有几种方法?常规的几种增强泛化能力的方法,罗列如下:1、较多的输入样本可以提高泛化能力;但不是太多,过多的样本导致过度拟合,泛化能力不佳;样本包括至少一次的转折点数据。 2、隐含层神经元数量的选择,不影响性能的前提下,尽量选择小一点的神经元数量。隐含层节点太多,造成泛化能力下降,造火箭也只要几十个到几百个神经元,拟合几百几千个数据何必要那么多神经元? 3、误差小,则泛化能力好;误差太小,则会过度拟合,泛化能力反而不佳。 4、学习率的选择,特别是权值学习率,对网络性能有很大影响,太小则收敛速度很慢,且容易陷入局部极小化;太大则,收敛速度快,但易出现摆动,误差难以缩小;一般权值学习率比要求误差稍微稍大一点点;另外可以使用变动的学习率,在误差大的时候增大学习率,等误差小了再减小学习率,这样可以收敛更快,学习效果更好,不易陷入局部极小化。 5、训练时可以采用随时终止法,即是误差达到要求即终止训练,以免过度拟合;可以调整局部权值,使局部未收敛的加快收敛。 深度学习中有哪些加快收敛的方法深度学习,按个人的理解主要就是多层神经网络。而多层神经网络目前效果比较好的是卷积神经网络,目前在图像和音频信号上效果比较好,而在自然语言处理上效果没有显示出来。 深度学习从统计学的角度来说,就是在预测数据的分布,从数据中学得一个模型然后再通过这个模型去预测新的数据,这一点就要求测试数据和训练数据必须是同分布。 深度学习,它是在一定的学习量的积累基础之上的质的飞越,就是学习能力的质变和新实现。度学习的前提在于大数据技术的成熟和支撑。同时,深度学习是一种经验的连接和运用。 它是人类的经验和智慧在机器中的再生和活化。

|

【本文地址】