| 目标检测算法国内外研究现状综述 | 您所在的位置:网站首页 › 口罩识别国内外研究现状 › 目标检测算法国内外研究现状综述 |

目标检测算法国内外研究现状综述

|

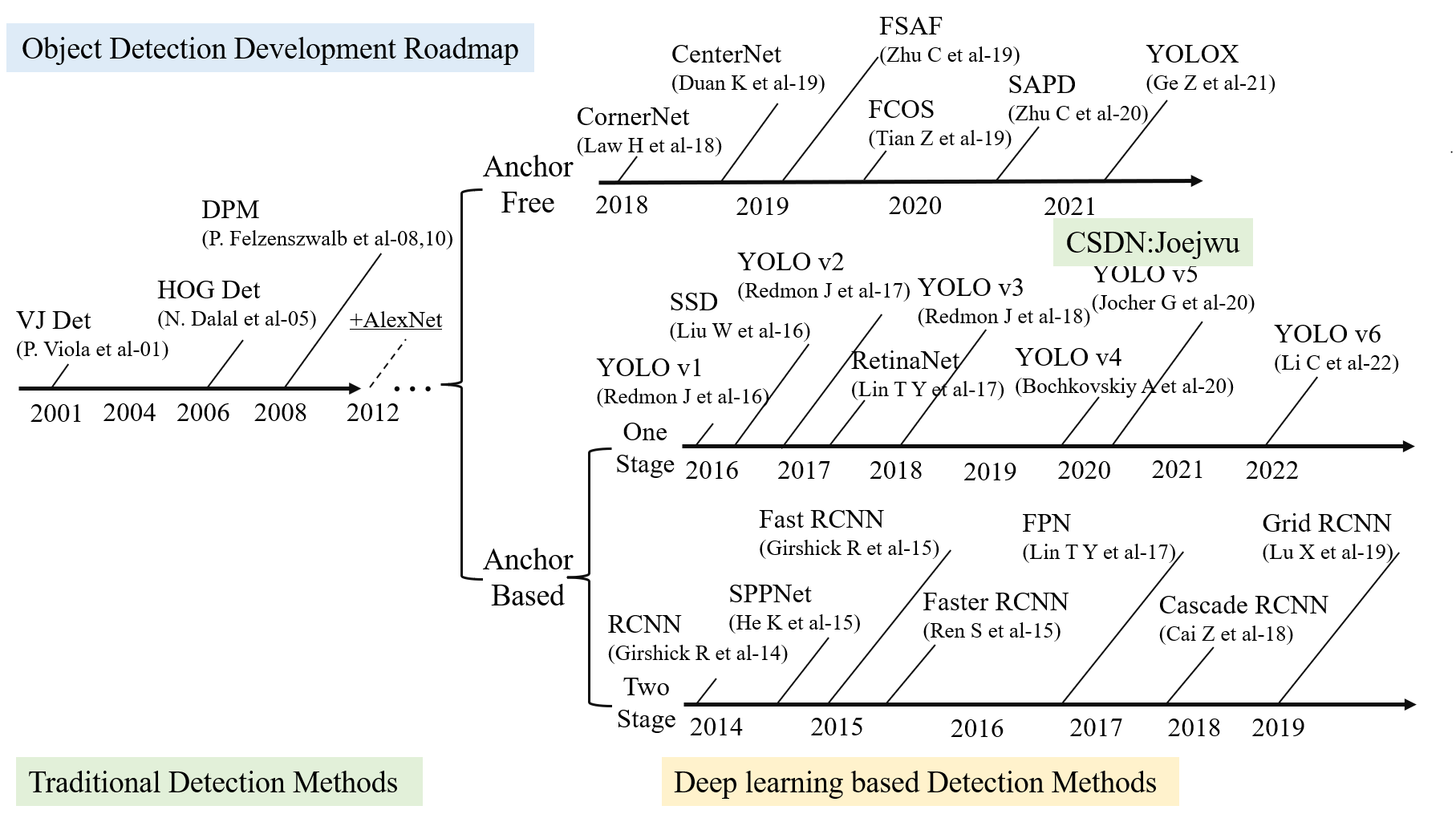

目录 1 传统目标检测算法 2 基于深度学习的Anchor based两阶段目标检测算法 3 基于深度学习的Anchor based单阶段目标检测算法 4 基于深度学习的Anchor Free目标检测算法 结合图1.1可以看到,近20年来目标检测领域的技术路线主要可分为两个阶段,即以传统检测方法为主的第一阶段,以及基于深度学习的第二阶段。为了完整阐述目标检测技术路线的演变过程,下面将按照这两个阶段以及第二阶段中的分类情况顺序介绍相关算法的特点。需要注意的是,在本节中出现的mAP(mean Average Precision),即平均精度,均为mAP50。

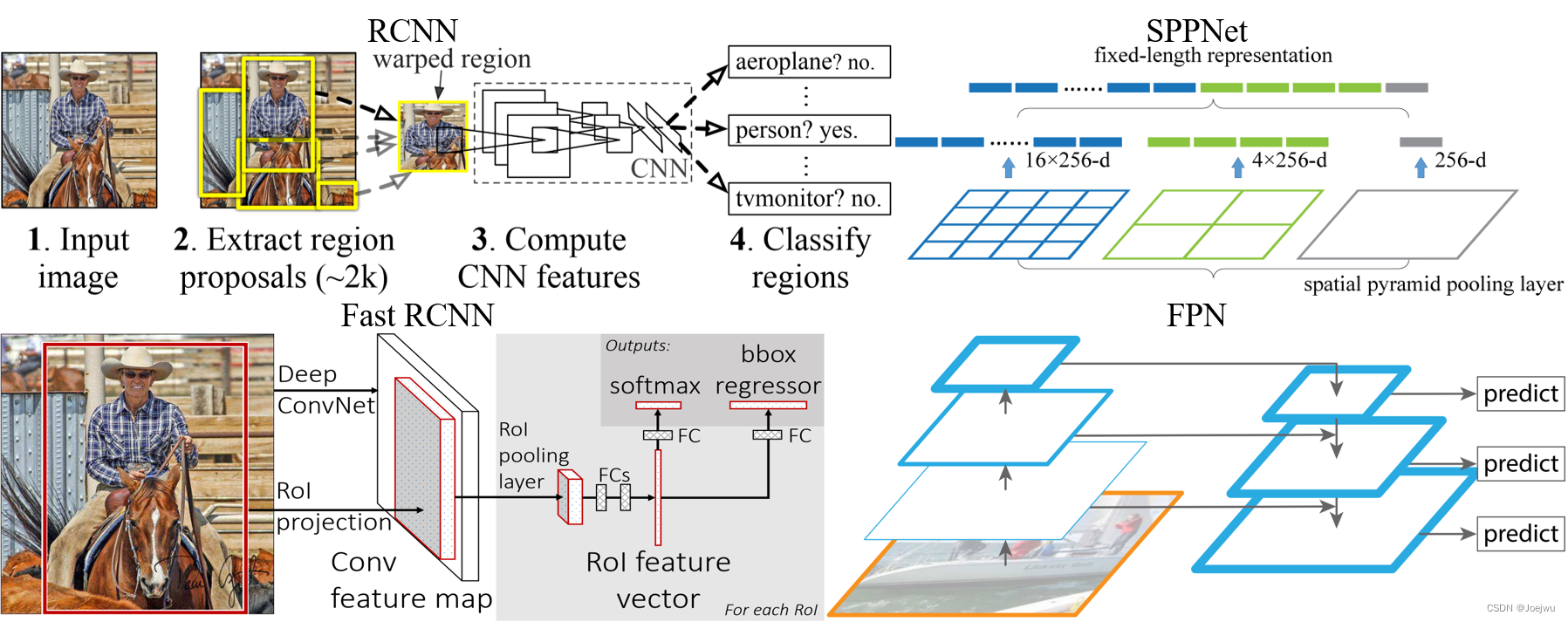

图1.1 目标检测算法近20年来发展路线图 1 传统目标检测算法传统目标检测算法中无法像现在主流的基于CNN的检测模型那样直接提取有效特征,而主要是通过手工提取的方式,概括其检测流程主要即先选取候选区域,或者称为ROI(Region Of Interest),随后对可能包含目标的区域提取特征,最后即对提取的特征进行分类。 Viola P等人提出的Viola Jones(VJ Detector)检测器[19]中通过对滑动窗口的检测来判断是否存在目标,并通过积分图、AdaBoost分类器以及级联结构三大优化措施来降低计算量以加速检测。Dalal N等人提出的HOG检测器[20]基于本地像素块提取特征直方图,并且在待检测目标受光照或变形等影响下仍能获得较好的检测效果。Felzenszwalb P F等人提出的DPM检测器[21]可作为HOG检测器的一种延申,其在HOG检测器的基础上叠加边框回归等技术,在VOC目标检测挑战赛上获得过冠军,成为当时目标检测领域的SOTA(State Of The Art)。尽管这些传统检测算法在当时已取得了不错的结果,但是相较于当前基于深度学习的检测算法,这些传统算法在精度、计算量以及检测速度等方面均要远远落后。 2 基于深度学习的Anchor based两阶段目标检测算法上述基于手工提取特征的传统目标检测算法发展较为缓慢,直到AlexNet出现后,其引发了卷积神经网络在计算机视觉领域的变革,基于CNN的目标检测算法逐渐成为了当前该领域内的主流。其中,又细分出了两条技术路线,即Anchor based方案与Anchor free方案,此处的Anchor即锚框,即分为基于锚框的检测方案与无固定锚框的检测方案。在Anchor based方案中,还包括单阶段与两阶段检测算法,此处将先介绍目前两阶段检测算法的相关研究现状。 两阶段目标检测算法即先从待检测图像中选择候选区域,然后再从候选区域中检测并生成目标边框。最早的基于CNN的两阶段目标检测算法是Girshick R等人提出的RCNN[22],该检测器通过选择搜索从候选框中选择可能包含物体的目标框,然后将这些目标框全部缩放到固定尺寸,随后作为CNN模型的输入来提取特征,最终将提取的特征传输给SVM(Support Vector Machine)分类器,用来判断是否存在目标以及进一步的分类。RCNN最终在PASCAL VOC 2007数据集上实现了58.5%的平均精度,相较于传统检测器中DPM 33.7%的最高平均精度,实现了极大的提升。随后,在2015年,He K等人提出了SPPNet[23],该检测器中采用了一种空间金字塔池化层,其使得模型中全连接层的输入都是固定尺寸的特征图,进而可避免重复计算,最终在PASCAL VOC 2007数据集上实现了59.2%的mAP。Girshick R等人基于RCNN以及SPPNet,提出了Fast RCNN[24],在VOC 2007数据集上实现了70.0%的mAP,但该检测器中仍采用了RCNN中的选择搜索算法,而该算法的使用将导致整个检测过程速度较慢。为此,Ren S等人在此基础上提出了Faster RCNN[25],该检测器中舍弃了选择搜索算法,而创新性地提出了通过区域候选网络生成候选框,可大幅提升检测速度,最终在VOC 2007数据集上实现了73.2%的mAP,MS COCO数据集[26]上实现了42.7%的mAP。Lin T Y等人在Faster RCNN的基础上,提出了FPN(Feature Pyramid Network)技术[27],其具有横向连接的自上而下的结构,极大地促进了检测精度的提升,并最终在COCO数据集上实现了59.1%的mAP。Cai Z等人提出的Cascade RCNN[28]同样是在Faster RCNN的基础上,通过堆叠多个级联模块,进而可采用不同IOU(Intersection Over Union)阈值进行训练,最终也在COCO数据集上实现了SOTA效果。Lu X等人提出的Grid RCNN[29]中则是将Faster RCNN中的位置回归替换为关键点检测,并实现了SOTA。如图1.2中,即展示了部分上述两阶段检测器中的典型结构。

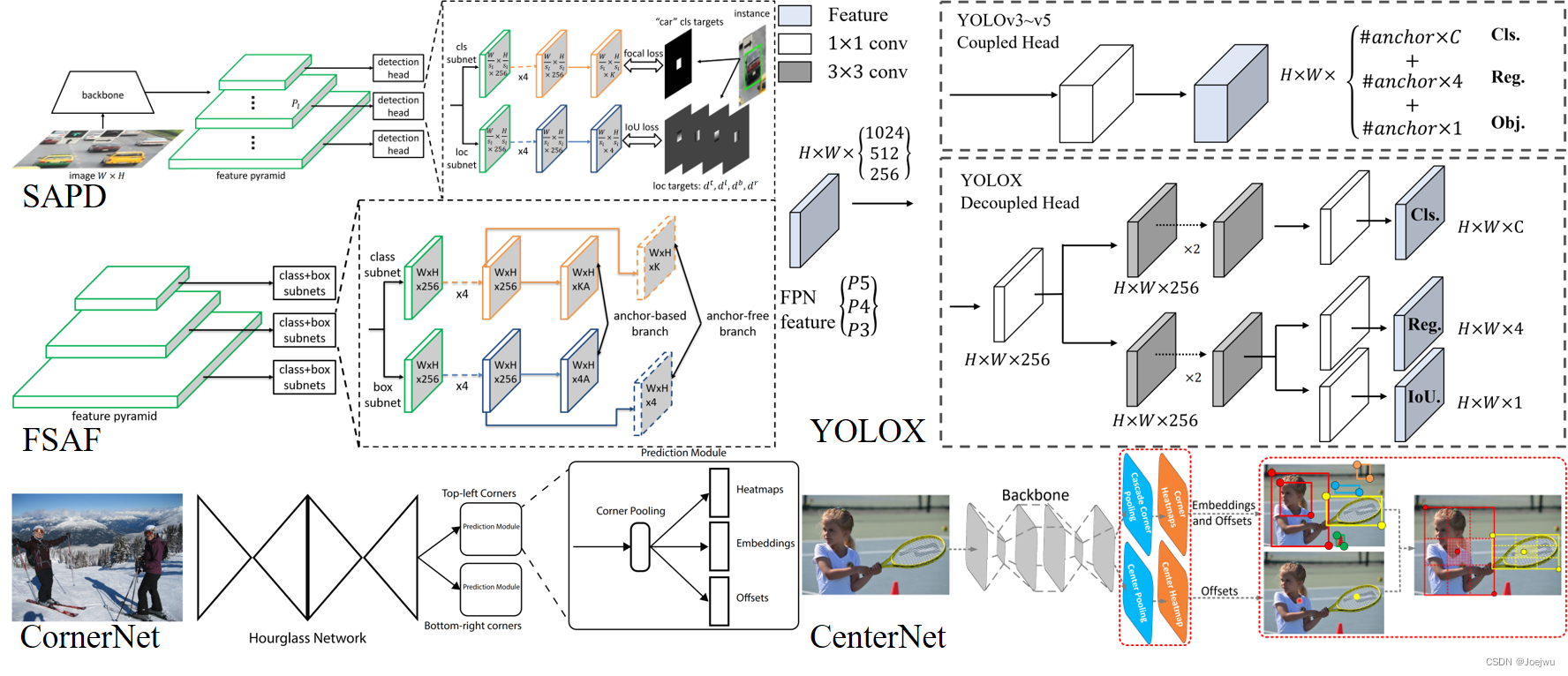

图1.2 Anchor based两阶段目标检测网络结构示意图[22][23][24][27] 3 基于深度学习的Anchor based单阶段目标检测算法不同于两阶段检测器中需要先获得候选区域再进行检测,单阶段目标检测算法中可直接产生检测结果,即类别概率与边界框坐标,仅需一个阶段即可完成检测。最早出现的单阶段检测器是由Redmon J等人提出的YOLO v1[30],其创新性地提出将图像划分为多个网格(Grid Cell),然后对每一个网格均预测边界框与类别概率;作为单阶段检测器的开山之作,YOLO v1虽然在精度上略低于同时期的两阶段检测器,但其检测速度却远远高于后者,因此在问世后,即引发了大量的关注,因为在实际落地场景中所追求的就是极高的检测速度。随后两年中,YOLO v1原团队相继提出了YOLO v2[31]与YOLO v3[32],其中YOLO v2在v1的基础上将骨干网络替换为DarkNet19,实现了更高的检测精度与速度,YOLO v3则是进一步地将骨干网络替换为DarkNet53,并借鉴FPN中的思想采用三条分支去检测不同尺度的目标,其在COCO数据集上达到了57.9%的mAP。在这之间,Liu W等人提出了SSD检测器[33],采用了Multi-reference和Multi-resolution技术,在COCO数据集上实现了46.5%的mAP;Lin T Y等人则是提出了RetinaNet[34],其将原本的交叉熵损失函数替换为根据Loss值来调节权值的Focal Loss,同样借鉴FPN中的思想,最终在COCO数据集上实现59.1%的mAP。 YOLO v3之后的几个版本的YOLO模型,均为该领域其他团队提出。Bochkovskiy A等人提出YOLO v4[16],该模型具备较大的工程实践价值,因为在该检测器中集成了同时期目标检测领域中众多的Tricks,最终在COCO数据集上实现了65.7%的mAP。Glenn Jocher等人提出了YOLO v5[35],该模型在YOLO v3的基础上,同样集成了大量的Tricks,其最新版本在COCO数据集上实现了68.9%的mAP,不仅在精度上超越了YOLO v4,该检测器在速度上同样高于后者的实现;而在与两阶段检测器的比较中,此时单阶段检测器的精度已从略低发展为远远超越,同时还继续保持着检测速度上的优势。鉴于此,本研究中选择了YOLO v5模型作为后续压缩实验的主要目标。最近的YOLO v6[36]由Li C等人于2022年提出,该检测器在YOLO v5的基础上参考RepVGG[37]中的思想,对原检测器中的骨干网络以及Neck部分进行了优化设计,最终在COCO数据集上实现了70.0%的mAP。 4 基于深度学习的Anchor Free目标检测算法Anchor based检测器相较于传统检测器已经在速度、精度上均取得了极大的优势,但由于其基于Anchor进行预测的基本属性,使这一类检测器仍存在不少缺点。例如基于Anchor的检测器往往对其数量、大小以及长宽比等都极为敏感,这些超参的设置不同,最终训练得到的同一结构的模型精度可能存在较大差距。所以这也导致对于不同的任务,不同的数据集,往往都需要通过K-Means聚类方法重新生成一组新的Anchor。此外,无论是在训练过程中还是在仅进行前向推理时,最终都需要计算所有Anchor与Ground Truth(真实框)之间的IOU,而这显然会增加计算量与内存占用等开销。鉴于此,Law H等人提出了Anchor Free检测器CornerNet[38],该检测器中将原本对目标边界框的预测替换为对目标关键点的预测,即通过目标左上角和右下角的坐标来确定目标位置,而无需Anchor作为先验框,其最终在COCO数据集上实现了57.8%的mAP。Duan K等人随后提出了CenterNet检测器[39],其不在预测左上角与右下角关键点,而是直接检测目标的中心点坐标,最终在COCO数据集上实现了64.5%的mAP。Zhu C等人提出的FSAF检测器[40]中提出了一种新的结构FSAF,将其用于特征金字塔网络中Anchor Free分支的训练,最终在COCO数据集上实现了65.2%的mAP。同一时期,Tian Z等人提出的FCOS检测器[41],是一种逐像素的检测算法,除了可作为单阶段检测器外,FCOS还可以作为两阶段检测器中的区域推荐网络,最终在COCO数据集上实现了64.1%的mAP。Zhu C等人在2020年提出的SAPD检测器[42]则是在CornerNet以及FSAF的基础上,提出了软加权锚点与软选择金字塔层级两个策略,最终在COCO数据集上实现了67.4%的mAP。Ge Z等人提出的YOLOX检测器[43],则是综合了YOLO系列检测器的优势,但有别于该系列检测器均为Anchor based检测器,YOLOX实现了Anchor Free,同时提出了双检测头输出的策略,即一个检测头输出类别,另一个则输出边界框信息,最终在COCO数据集上实现了68.0%的mAP。如图1.3中,即展示了部分上述Anchor Free检测器中的典型结构。

图1.3 Anchor Free目标检测网络结构示意图[38][39][40][42][43] 参考文献: 文中参考文献序号减去18即与下列相应文献对应! Viola P, Jones M. Rapid object detection using a boosted cascade of simple features[C]//Proceedings of the 2001 IEEE computer society conference on computer vision and pattern recognition. CVPR 2001. Ieee, 2001, 1: I-I. Dalal N, Triggs B. Histograms of oriented gradients for human detection[C]//2005 IEEE computer society conference on computer vision and pattern recognition (CVPR'05). Ieee, 2005, 1: 886-893. Felzenszwalb P F, Girshick R B, McAllester D, et al. Object detection with discriminatively trained part-based models[J]. IEEE transactions on pattern analysis and machine intelligence, 2010, 32(9): 1627-1645. Girshick R, Donahue J, Darrell T, et al. Rich feature hierarchies for accurate object detection and semantic segmentation[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2014: 580-587. He K, Zhang X, Ren S, et al. Spatial pyramid pooling in deep convolutional networks for visual recognition[J]. IEEE transactions on pattern analysis and machine intelligence, 2015, 37(9): 1904-1916. Girshick R. Fast r-cnn[C]//Proceedings of the IEEE international conference on computer vision. 2015: 1440-1448. Ren S, He K, Girshick R, et al. Faster r-cnn: Towards real-time object detection with region proposal networks[J]. Advances in neural information processing systems, 2015, 28. Lin T Y, Maire M, Belongie S, et al. Microsoft coco: Common objects in context[C]//European conference on computer vision. Springer, Cham, 2014: 740-755. Lin T Y, Dollár P, Girshick R, et al. Feature pyramid networks for object detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2017: 2117-2125. Cai Z, Vasconcelos N. Cascade r-cnn: Delving into high quality object detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2018: 6154-6162. Lu X, Li B, Yue Y, et al. Grid r-cnn[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2019: 7363-7372. Redmon J, Divvala S, Girshick R, et al. You only look once: Unified, real-time object detection[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2016: 779-788. Redmon J, Farhadi A. YOLO9000: better, faster, stronger[C]//Proceedings of the IEEE conference on computer vision and pattern recognition. 2017: 7263-7271. Redmon J, Farhadi A. Yolov3: An incremental improvement[J]. arXiv preprint arXiv:1804.02767, 2018. Liu W, Anguelov D, Erhan D, et al. Ssd: Single shot multibox detector[C]//European conference on computer vision. Springer, Cham, 2016: 21-37. Lin T Y, Goyal P, Girshick R, et al. Focal loss for dense object detection[C]//Proceedings of the IEEE international conference on computer vision. 2017: 2980-2988. Glenn Jocher, Alex Stoken, Ayush Chaurasia, et al., 2021. Ultralytics/yolov5: v6.0 - yolov5n \'nano\' models, roboflow integration, tensorflow export, opencv DNN support[Z]. Zenodo(2021–10–12). Li C, Li L, Jiang H, et al. YOLOv6: A single-stage object detection framework for industrial applications[J]. arXiv preprint arXiv:2209.02976, 2022. Ding X, Zhang X, Ma N, et al. Repvgg: Making vgg-style convnets great again[C]//Proceedings of the IEEE/CVF Conference on Computer Vision and Pattern Recognition. 2021: 13733-13742. Law H, Deng J. Cornernet: Detecting objects as paired keypoints[C]//Proceedings of the European conference on computer vision (ECCV). 2018: 734-750. Duan K, Bai S, Xie L, et al. Centernet: Keypoint triplets for object detection[C]//Proceedings of the IEEE/CVF international conference on computer vision. 2019: 6569-6578. Zhu C, He Y, Savvides M. Feature selective anchor-free module for single-shot object detection[C]//Proceedings of the IEEE/CVF conference on computer vision and pattern recognition. 2019: 840-849. Tian Z, Shen C, Chen H, et al. Fcos: Fully convolutional one-stage object detection[C]//Proceedings of the IEEE/CVF international conference on computer vision. 2019: 9627-9636. Zhu C, Chen F, Shen Z, et al. Soft anchor-point object detection[C]//European conference on computer vision. Springer, Cham, 2020: 91-107. Ge Z, Liu S, Wang F, et al. Yolox: Exceeding yolo series in 2021[J]. arXiv preprint arXiv:2107.08430, 2021. |

【本文地址】