| 经常说的 CPU 上下文切换是什么意思? | 您所在的位置:网站首页 › 上下文切换是什么含义 › 经常说的 CPU 上下文切换是什么意思? |

经常说的 CPU 上下文切换是什么意思?

|

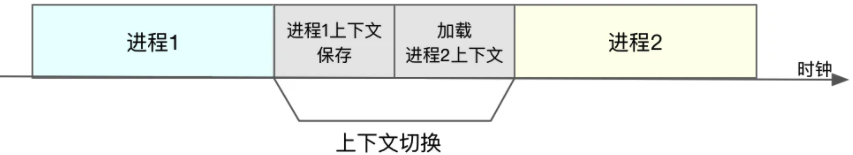

本文是通过学习倪朋飞老师的《Linux性能优化实战》:经常说的 CPU 上下文切换是什么意思 CPU 上下文切换 什么是CPU上下文切换进程上下文切换线程上下文切换中断上下文切换怎么查看系统的上下文切换情况案例分析总结 什么是CPU上下文切换Linux 是一个多任务操作系统,它支持远大于 CPU 数量的任务同时运行。当 然,这些任务实际上并不是真的在同时运行,而是因为系统在很短的时间内,将 CPU 轮流 分配给它们,造成多任务同时运行的错觉。 而在每个任务运行前,CPU 都需要知道任务从哪里加载、又从哪里开始运行,也就是说, 需要系统事先帮它设置好 CPU 寄存器和程序计数器(Program Counter,PC)。 CPU 寄存器,是 CPU 内置的容量小、但速度极快的内存。而程序计数器,则是用来存储 CPU 正在执行的指令位置、或者即将执行的下一条指令位置。它们都是 CPU 在运行任何 任务前,必须的依赖环境,因此也被叫做 CPU 上下文。 知道了什么是 CPU 上下文,就很容易理解 CPU 上下文切换。CPU 上下文切换,就是先把前一个任务的 CPU 上下文(也就是 CPU 寄存器和程序计数器)保存起来,然后加载新任务的上下文到这些寄存器和程序计数器,最后再跳转到程序计数器所指的新位置, 运行新任务。 而这些保存下来的上下文,会存储在系统内核中,并在任务重新调度执行时再次加载进来。这样就能保证任务原来的状态不受影响,让任务看起来还是连续运行。 也许我们会认为,CPU 上下文切换无非就是更新了 CPU 寄存器的值嘛,但这些寄存器,本身就是为了快速运行任务而设计的,为什么会影响系统的 CPU 性能呢? 那么我们是否想过,操作系统管理的这些“任务”到底是什么呢? 也许我们认为,任务就是进程,或者说任务就是线程。是的,进程和线程正是最常见的任务。但是除此之外,还有没有其他的任务呢? 但是不要忘了,硬件通过触发信号,会导致中断处理程序的调用,也是一种常见的任务。 所以,根据任务的不同,CPU 的上下文切换就可以分为几个不同的场景,也就是进程上下文切换、线程上下文切换以及中断上下文切换。 进程上下文切换Linux 按照特权等级,把进程的运行空间分为内核空间和用户空间,分别对应着下图中, CPU 特权等级的 Ring 0 和 Ring 3。 内核空间(Ring 0)具有最高权限,可以直接访问所有资源;用户空间(Ring 3)只能访问受限资源,不能直接访问内存等硬件设备,必须通过系统 调用陷入到内核中,才能访问这些特权资源。

换个角度看,也就是说,进程既可以在用户空间运行,又可以在内核空间中运行。进程在用户空间运行时,被称为进程的用户态,而陷入内核空间的时候,被称为进程的内核态。 从用户态到内核态的转变,需要通过系统调用来完成。比如,当我们查看文件内容时,就需要多次系统调用来完成:首先调用 open() 打开文件,然后调用 read() 读取文件内容, 并调用 write() 将内容写到标准输出,最后再调用 close() 关闭文件。 那么,系统调用的过程有没有发生 CPU 上下文的切换呢?答案自然是肯定的。 CPU 寄存器里原来用户态的指令位置,需要先保存起来。接着,为了执行内核态代码, CPU 寄存器需要更新为内核态指令的新位置。最后才是跳转到内核态运行内核任务。 而系统调用结束后,CPU 寄存器需要恢复原来保存的用户态,然后再切换到用户空间,继 续运行进程。所以,一次系统调用的过程,其实是发生了两次 CPU 上下文切换。 不过,需要注意的是,系统调用过程中,并不会涉及到虚拟内存等进程用户态的资源,也不会切换进程。这跟我们通常所说的进程上下文切换是不一样的: 进程上下文切换,是指从一个进程切换到另一个进程运行。而系统调用过程中一直是同一个进程在运行。所以,系统调用过程通常称为特权模式切换,而不是上下文切换。但实际上,系统调用过程中,CPU 的上下文切换还是无法避免的。 那么,进程上下文切换跟系统调用又有什么区别呢? 首先,我们需要知道,进程是由内核来管理和调度的,进程的切换只能发生在内核态。所以,进程的上下文不仅包括了虚拟内存、栈、全局变量等用户空间的资源,还包括了内核堆栈、寄存器等内核空间的状态。 因此,进程的上下文切换就比系统调用时多了一步:在保存当前进程的内核状态和 CPU 寄存器之前,需要先把该进程的虚拟内存、栈等保存下来;而加载了下一进程的内核态后,还需要刷新进程的虚拟内存和用户栈。 如下图所示,保存上下文和恢复上下文的过程并不是“免费”的,需要内核在 CPU 上运行 才能完成。 根据 Tsuna 的测试报告,每次上下文切换都需要几十纳秒到数微秒的 CPU 时间。这个时间还是相当可观的,特别是在进程上下文切换次数较多的情况下,很容易导致 CPU 将大量时间耗费在寄存器、内核栈以及虚拟内存等资源的保存和恢复上,进而大大缩短了真正运行进程的时间。这也正是导致平均负载升高的一个重要因素。 另外, Linux 通过 TLB(Translation Lookaside Buffer)来管理虚拟内存到物理内存的映射关系。当虚拟内存更新后,TLB 也需要刷新,内存的访问也会随之变慢。 特别是在多处理器系统上,缓存是被多个处理器共享的,刷新缓存不仅会影响当前处理器的进程,还会影响共享缓存的其他处理器的进程。 显然,进程切换时才需要切换上下文,换句话说,只有在进程调度的时候,才需要切换上 下文。Linux 为每个 CPU 都维护了一个就绪队列,将活跃进程(即正在运行和正在等待 CPU 的进程)按照优先级和等待 CPU 的时间排序,然后选择最需要 CPU 的进程,也就是优先级最高和等待 CPU 时间最长的进程来运行。 那么,进程在什么时候才会被调度到 CPU 上运行呢? 最容易想到的一个时机,就是进程执行完终止了,它之前使用的 CPU 会释放出来,这个时 候再从就绪队列里,拿一个新的进程过来运行。其实还有很多其他场景,也会触发进程调度,在这里我们逐个梳理下。 为了保证所有进程可以得到公平调度,CPU 时间被划分为一段段的时间片,这些时间片再被轮流分配给各个进程。这样,当某个进程的时间片耗尽了,就会被系统挂起,切换到其它正在等待 CPU 的进程运行。进程在系统资源不足(比如内存不足)时,要等到资源满足后才可以运行,这个时候进程也会被挂起,并由系统调度其他进程运行。当进程通过睡眠函数 sleep 这样的方法将自己主动挂起时,自然也会重新调度。当有优先级更高的进程运行时,为了保证高优先级进程的运行,当前进程会被挂起,由高优先级进程来运行。发生硬件中断时,CPU 上的进程会被中断挂起,转而执行内核中的中断服务程序。了解这几个场景是非常有必要的,因为一旦出现上下文切换的性能问题,它们就是幕后凶手。 线程上下文切换线程与进程最大的区别在于,线程是调度的基本单位,而进程则是资源拥有的基本单位。 说白了,所谓内核中的任务调度,实际上的调度对象是线程;而进程只是给线程提供了虚 拟内存、全局变量等资源。所以,对于线程和进程,我们可以这么理解: 当进程只有一个线程时,可以认为进程就等于线程当进程拥有多个线程时,这些线程会共享相同的虚拟内存和全局变量等资源。这些资源在上下文切换时是不需要修改的。另外,线程也有自己的私有数据,比如栈和寄存器等,这些在上下文切换时也是需要保存的。这样的话,线程的上下文切换其实就可以分为两种情况: 前后两个线程属于不同进程。此时,因为资源不共享,所以切换过程就跟进程上下文切换是一样。前后两个线程属于同一个进程。此时,因为虚拟内存是共享的,所以在切换时,虚拟内存这些资源就保持不动,只需要切换线程的私有数据、寄存器等不共享的数据。到此我们就发现了,虽然同为上下文切换,但同进程内的线程切换,要比多进程间的切换消耗更少的资源,而这,也正是多线程代替多进程的一个优势。 中断上下文切换为了快速响应硬件的事件,中断处理会打断进程的正常调度和执行,转而调用中断处理程序,响应设备事件。而在打断其他进程时,就需要将进程当前的状态保存下来,这样在中断结束后,进程仍然可以从原来的状态恢复运行。 跟进程上下文不同,中断上下文切换并不涉及到进程的用户态。所以,即便中断过程打断了一个正处在用户态的进程,也不需要保存和恢复这个进程的虚拟内存、全局变量等用户态资源。中断上下文,其实只包括内核态中断服务程序执行所必需的状态,包括 CPU 寄存器、内核堆栈、硬件中断参数等。 对同一个 CPU 来说,中断处理比进程拥有更高的优先级,所以中断上下文切换并不会与进程上下文切换同时发生。同样道理,由于中断会打断正常进程的调度和执行,所以大部分中断处理程序都短小精悍,以便尽可能快的执行结束。 另外,跟进程上下文切换一样,中断上下文切换也需要消耗 CPU,切换次数过多也会耗费大量的CPU,甚至严重降低系统的整体性能。所以,当发现中断次数过多时,就需要注意去排查它是否会给你的系统带来严重的性能问题。 怎么查看系统的上下文切换情况通过上面我们知道,过多的上下文切换,会把 CPU 时间消耗在寄存器、内核栈以及虚拟内存等数据的保存和恢复上,缩短进程真正运行的时间,成了系统性能大幅下降的一个元凶。 既然上下文切换对系统性能影响那么大,那到底要怎么查看上下文切换呢?我们可以使用vmstat 这个工具,来查询系统的上下文切换情况。 vmstat 是一个常用的系统性能分析工具,主要用来分析系统的内存使用情况,也常用来分 析 CPU 上下文切换和中断的次数。 例如,下面就是一个 vmstat 的使用示例: [root@ ~]# vmstat 5 procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu----- r b swpd free buff cache si so bi bo in cs us sy id wa st 2 0 101120 2083104 1044 692872 0 0 0 0 37327 57872 3 8 89 0 0需要特别关注的四列内容: cs(context switch)是每秒上下文切换的次数in(interrupt)则是每秒中断的次数r(Running or Runnable)是就绪队列的长度,也就是正在运行和等待 CPU 的进程 数b(Blocked)则是处于不可中断睡眠状态的进程数 可以看到,这个例子中的上下文切换次数 cs 是 57872 次,系统中断次数 in 则是 37327 次,而就绪队列长度 r是2此, 不可中断状态进程数 b 是0。vmstat 只给出了系统总体的上下文切换情况,要想查看每个进程的详细情况,就需要使用 pidstat 了。给它加上 -w 选项,你就可以查看每个进程上下文切换的情况了。 pidstat -w 5 19时40分33秒 UID PID cswch/s nvcswch/s Command 19时40分38秒 0 9 1.00 0.00 ksoftirqd/0 19时40分38秒 0 10 30.94 0.00 rcu_sched这个结果中有两列内容是我们的重点关注对象。一个是 cswch ,表示每秒自愿上下文切换 (voluntary context switches)的次数,另一个则是 nvcswch ,表示每秒非自愿上下文 切换(non voluntary context switches)的次数。 这两个概念一定要牢牢记住,因为它们意味着不同的性能问题: 所谓自愿上下文切换,是指进程无法获取所需资源,导致的上下文切换。比如说, I/O、内存等系统资源不足时,就会发生自愿上下文切换。而非自愿上下文切换,则是指进程由于时间片已到等原因,被系统强制调度,进而发生的上下文切换。比如说,大量进程都在争抢 CPU 时,就容易发生非自愿上下文切换。 案例分析我们使用 sysbench 来模拟系统多线程调度切换的情况 sysbench 是一个多线程的基准测试工具,一般用来评估不同系统参数下的数据库负载情 况。当然,在这次案例中,我们只把它当成一个异常进程来看,作用是模拟上下文切换过 多的问题。 预先安装 sysbench 和 sysstat 包,如:yum install sysbench sysstat 正式操作开始前,你需要打开三个终端,登录到同一台 Linux 机器中,并安装好上面提到的两个软件包 首先,在第一个终端里运行 sysbench ,模拟系统多线程调度的瓶颈: 以 100 个线程运行 5 分钟的基准测试,模拟多线程切换的问题 sysbench --threads=100 --max-time=300 threads run接着,在第二个终端运行 vmstat ,观察上下文切换情况: # 每隔 1 秒输出 1 组数据 vmstat 1 procs -----------memory---------- ---swap-- -----io---- -system-- ------cpu----- r b swpd free buff cache si so bi bo in cs us sy id wa st 15 0 100608 1993144 1044 767932 0 0 0 0 16254 1700980 27 72 1 0 0 15 0 100608 1994972 1044 767932 0 0 0 0 16046 1689235 26 72 1 0 0应该可以发现,cs 列的上下文切换次数从之前的 1 骤然上升到了 160 万。同时,注意 观察其他几个指标: r 列:就绪队列的长度已经到了 15,远远超过了系统 CPU 的个数 4,所以肯定会有大量 的 CPU 竞争。us(user)和 sy(system)列:这两列的 CPU 使用率加起来上升到了 98%,其中系统 CPU 使用率,也就是 sy 列高达 72%,说明 CPU 主要是被内核占用了。in 列:中断次数也上升到了 1.6万左右,说明中断处理也是个潜在的问题。综合这几个指标,我们可以知道,系统的就绪队列过长,也就是正在运行和等待 CPU 的进 程数过多,导致了大量的上下文切换,而上下文切换又导致了系统 CPU 的占用率升高。 那么到底是什么进程导致了这些问题呢? 继续分析,在第三个终端再用 pidstat 来看一下, CPU 和进程上下文切换的情况: # 每隔 1 秒输出 1 组数据 # -w 参数表示输出进程切换指标,而 -u 参数则表示输出 CPU 使用指标 pidstat -w -u 1 11时10分37秒 UID PID %usr %system %guest %wait %CPU CPU Command 11时10分38秒 0 4308 0.00 14.85 0.00 0.00 14.85 3 imsocket 11时10分38秒 0 22479 98.02 258.42 0.00 0.00 356.44 1 sysbench 11时10分38秒 0 22597 0.00 0.99 0.00 0.00 0.99 0 pidstat 11时10分38秒 1000 22598 13.86 0.99 0.00 2.97 14.85 3 php 11时10分38秒 0 27695 0.99 0.00 0.00 0.00 0.99 3 nsqd 11时10分38秒 0 31162 0.99 0.00 0.00 0.00 0.99 0 AliYunDun 11时10分37秒 UID PID cswch/s nvcswch/s Command 11时10分38秒 0 1 0.99 0.00 systemd 11时10分38秒 0 9 5.94 0.00 ksoftirqd/0 11时10分38秒 0 10 73.27 0.00 rcu_sched 11时10分38秒 0 12 0.99 0.00 watchdog/0 11时10分38秒 0 15 0.99 0.00 watchdog/1 11时10分38秒 0 21 0.99 0.00 watchdog/2 11时10分38秒 0 23 0.99 0.00 ksoftirqd/2 11时10分38秒 0 27 0.99 0.00 watchdog/3 11时10分38秒 0 29 0.99 0.00 ksoftirqd/3 11时10分38秒 0 510 19.80 0.00 xfsaild/vda1 11时10分38秒 0 860 80.20 0.00 rngd 11时10分38秒 1000 22598 12.87 95.05 php从 pidstat 的输出你可以发现,CPU 使用率的升高果然是 sysbench 导致的,它的 CPU 使用率已经达到了 356.44%。但上下文切换则是来自其他进程,包括非自愿上下文切换频率 最高的 php ,以及自愿上下文切换频率最高的内核线程 rngd和rcu_sched。 仔细观察发现一件怪异的事情:pidstat 输出的上下文切换次数,加起来也就几百,比 vmstat 的 160 万明显小了太多。这是怎么回事呢?难度是工具有问题吗? 是这样的,Linux调度的基本单位实际上是线程,而我们的场景sysbench模拟的也是线程调度的问题,但是pidstat默认显示进程的指标数据,需要加上-t参数后才会输入线程的指标 # 每隔 1 秒输出一组数据 # -wt 参数表示输出线程的上下文切换指标 pidstat -wt -u 1 11时27分25秒 UID TGID TID cswch/s nvcswch/s Command 11时27分27秒 0 - 22810 9.62 0.00 sysbench 11时27分27秒 0 - 22810 5133.01 13385.44 |__sysbench 11时27分27秒 0 - 22811 5765.05 14159.22 |__sysbench 11时27分27秒 0 - 22812 3322.33 9100.97 |__sysbench 11时27分27秒 0 - 22813 3638.83 5745.63 |__sysbench 11时27分27秒 0 - 22814 4267.96 6135.92 |__sysbench 11时27分27秒 0 - 22815 3761.17 13850.49 |__sysbench 11时27分27秒 0 - 22816 3739.81 24042.72 |__sysbench 11时27分27秒 0 - 22817 6231.07 6082.52 |__sysbench 11时27分27秒 0 - 22818 4959.22 4877.67 |__sysbench 11时27分27秒 0 - 22819 4732.04 9677.67 |__sysbench 11时27分27秒 0 - 22820 4394.17 13942.72 |__sysbench 11时27分27秒 0 - 22821 5336.89 18359.22 |__sysbench 11时27分27秒 0 - 22822 4558.25 16187.38 |__sysbench 11时27分27秒 0 - 22823 4630.10 10612.62 |__sysbench 11时27分27秒 0 - 22824 4602.91 12770.87 |__sysbench 11时27分27秒 0 - 22825 3674.76 11250.49 |__sysbench 11时27分27秒 0 - 22826 5240.78 10682.52 |__sysbench现在我们就看到了,虽然sysbench 进程(也就是主线程)的上下文切换次数看起来并不 多,但它的子线程的上下文切换次数却有很多。看来,上下文切换罪魁祸首,还是过多的 sysbench 线程。 我们已经找到了上下文切换次数增多的根源,那是不是到这儿就可以结束了呢?当然不是,除了上下文切换频临骤然升高,还有一个指标也有很大的变化。那就是中断次数,从vmstat中看到in(中断次数)也上升到了1.6万,但到底是什么类型的中断上升了,目前还不清楚。 既然是中断,那么它只发生在内核态,而pidstat只是一个进程的性能分析工具,并不提供任何关于中断的详细,怎样才能知道中断发生的类型呢?那就是从**/proc/interrupts文件中读取**。/proc 实际上是 Linux 的一个虚拟文件系统,用于内核空间与用户空间之间的通信。/proc/interrupts 就是这种通信机制的一部分,提供了一个只读的中断使用情况。 运行以下命令,观察中断的变化情况: # -d 参数表示高亮显示变化的区域 watch -d cat /proc/interrupts CPU0 CPU1 CPU2 CPU3 ... LOC: 3051939632 3326136817 3001574423 3585112863 Local timer interrupts .... RES: 4236013623 2331541043 2033964430 848722876 Rescheduling interrupts ...观察一段时间,可以发现,变化速度最快的是重调度中断(RES)和(LOC),这个中断类型表示,唤醒空闲状态的 CPU 来调度新的任务运行。这是多处理器系统(SMP)中,调度器 用来分散任务到不同 CPU 的机制,通常也被称为处理器间中断(Inter-Processor Interrupts,IPI)。 那么,每秒上下文切换多少次才算正常呢? 这个数值其实取决于系统本身的 CPU 性能。在我看来,如果系统的上下文切换次数比较稳定,那么从数百到一万以内,都应该算是正常的。但当上下文切换次数超过一万次,或者切换次数出现数量级的增长时,就很可能已经出现了性能问题。 这时,就需要根据上下文切换的类型,再做具体分析。比方说: 自愿上下文切换变多了,说明进程都在等待资源,有可能发生了 I/O 等其他问题;非自愿上下文切换变多了,说明进程都在被强制调度,也就是都在争抢 CPU,说明 CPU 的确成了瓶颈;中断次数变多了,说明 CPU 被中断处理程序占用,还需要通过查看 /proc/interrupts 文件来分析具体的中断类型。 总结不管是哪种场景导致的上下文切换,我们都应该知道: CPU 上下文切换,是保证 Linux 系统正常工作的核心功能之一,一般情况下不需要我们特别关注。但过多的上下文切换,会把 CPU 时间消耗在寄存器、内核栈以及虚拟内存等数据的保存和恢复上,从而缩短进程真正运行的时间,导致系统的整体性能大幅下降。多任务竞争CPU,CPU变换任务的时候进行CPU上下文切换(context switch)。CPU执行任务有4种方式:进程、线程、或者硬件通过触发信号导致中断的调用。当切换任务的时候,需要记录任务当前的状态和获取下一任务的信息和地址(指针),这就是上下文的内容。因此,上下文是指某一时间点CPU寄存器(CPU register)和程序计数器(PC)的内容, 广义上还包括内存中进程的虚拟地址映射信息.上下文切换的过程: 记录当前任务的上下文(即寄存器和计算器等所有的状态); 找到新任务的上下文并加载; 切换到新任务的程序计算器位置,恢复其任务。 根据任务的执行形式,相应的下上文切换,有进程上下文切换、线程上下文切换、以及中断上下文切换三类。进程和线程的区别: 进程是资源分配和执行的基本单位;线程是任务调度和运行的基本单位。线程没有资源,进程给指针提供虚拟内存、栈、变量等共享资源,而线程可以共享进程的资源。进程上下文切换:是指从一个进程切换到另一个进程进程运行态为内核运行态和进程运行态。内核空间态资源包括内核的堆栈、寄存器等;用户空间态资源包括虚拟内存、栈、变量、正文、数据等 系统调用(软中断)在内核态完成的,需要进行2次CPU上下文切换(用户空间–>内核空间–>用户空间),不涉及用户态资源,也不会切换进程。 进程是由内核来管理和调度的,进程的切换只能发生在内核态。所以,进程的上下文不仅包括了用户空间的资源,也包括内核空间资源。 进程的上下文切换过程: 接收到切换信号,挂起进程,记录当前进程的虚拟内存、栈等资源存储; 将这个进程在 CPU 中的上下文状态存储于起来; 然后在内存中检索下一个进程的上下文; 并将其加载到 CPU的寄存器中恢复; 还需要刷新进程的虚拟内存和用户栈; 最后跳转到程序计数器所指向的位置(即跳转到进程被中断时的代码行),以恢复该进程以下将会触发进程上下文切换的场景: 根据调度策略,将CPU时间划片为对应的时间片,当时间片耗尽,当前进程必须挂起 资源不足的,在获取到足够资源之前进程挂起。 进程sleep挂起进程。 高优先级进程导致当前进度挂起 硬件中断,导致当前进程挂起 线程上下文切换: 不是同一进程之间的线程上下文切换,其过程和进程上下文切换大致相同。进程内部的线程进上下文切换。不需要切换进程的用户资源,只需要切换线程私有的数据和寄存器等。这会比进程上下文进程切换消耗的资源少,所以多线程相比多进程的优势。 中断上下文切换 快速响应硬件的事件,中断处理会打断进程的正常调度和执行。同一CPU内,硬件中断优先级高于进程。切换过程类似于系统调用的时候,不涉及到用户运行态资源。但大量的中断上下文切换同样可能引发性能问题。过多上下文切换会缩短进程运行时间 vmstat:分析内存使用情况、cpu上下文切换和中断的次数。cs每秒上下文切换的次数,in每秒中断的次数,r运行或等待cpu的进程数,b中断睡眠状态的进程数。pidstat -w 5:查看每个进程详细情况。cswch(每秒自愿)上下文切换次数,如系统资源不足导致,nvcswch每秒非自愿上下文切换次数,如cpu时间片用完或高优先级线程案例分析: sysbench:多线程的基准测试工具,模拟context switchwatch -d cat /proc/interupts :查看另一个指标中断次数,在/proc/interupts中读取,发现重调度中断res变化速度最快 总结:cswch过多说明资源IO问题,nvcswch过多说明调度争抢cpu过多,中断次数变多说明cpu被中断程序调用登录到服务器,现在系统负载怎么样 。 高的话有三种情况,首先是cpu使用率 ,其次是io使用率 ,之后就是两者都高 。 cpu 使用率高,可能确实是使用率高, 也的可能实际处理不高而是进程太多切换上下文频繁 , 也可能是进程内线程的上下文切换频繁io 使用率高 , 说明 io 请求比较大, 可能是 文件io 、 网络io 。 工具 :系统负载 : uptime ( watch -d uptime)看三个阶段平均负载系统整体情况 : mpstat (mpstat -p ALL 3) 查看每个cpu当前的整体状况,可以重点看用户态、内核态、以及io等待三个参数系统整体的平均上下文切换情况 : vmstat (vmstat 3) 可以重点看 r (进行或等待进行的进程)、b (不可中断进程/io进程) 、in (中断次数) 、cs(上下文切换次数)查看详细的上下文切换情况 : pidstat (pidstat -w(进程切换指标)/-u(cpu使用指标)/-wt(线程上下文切换指标)) 注意看是自愿上下文切换、还是被动上下文切换io使用情况 : iostat 模拟场景工具 :stress : 模拟进程 、 iosysbench : 模拟线程数 |

【本文地址】