| Spark在Windows环境下的搭建 | 您所在的位置:网站首页 › spark安装教程csdn › Spark在Windows环境下的搭建 |

Spark在Windows环境下的搭建

|

一、安装JDK

本文写于2022年3月,此时最新版的JDK已经更新到了JDK17——下载地址。为了满足开发人员的需要,Oracle仍然提供了JDK8和JDK11可供下载,下载链接也在上面的网站上,只需要把页面下滑即可。 注:由于需要配置Spark,但Spark与较新的JDK兼容性不好,如果使用最新的JDK,后序运行Spark过程中会出现错误。因此,建议初学者安装JDK8即可。 下载完成后即可安装。但需要注意的是,需要为JDK设置三个环境变量PATH、JAVA_HOME、CLASSPATH,网上已经有很多设置环境变量的教程,这里就不再赘述。贴一个参考链接:https://blog.csdn.net/u011513853/article/details/52865076?spm=1001.2014.3001.5506 二、安装Scala、Hadoop、Sparkscala和Hadoop下载需要注意一下和Spark的对应版本,通过Spark下载网站,如下图,可以得知对应关系。 Pre-built for Apache Hadoop 3.2 and later是指选择的安装包是已经为Hadoop3.2和3.2之后的版本预编译好的,即Hadoop需要下载3.2之后的版本。最下面写明了Spark3是用Scala 2.12预编译好的,因此我需要下载Scala 2.12.x 版本。 下载好之后同样需要设置环境变量。

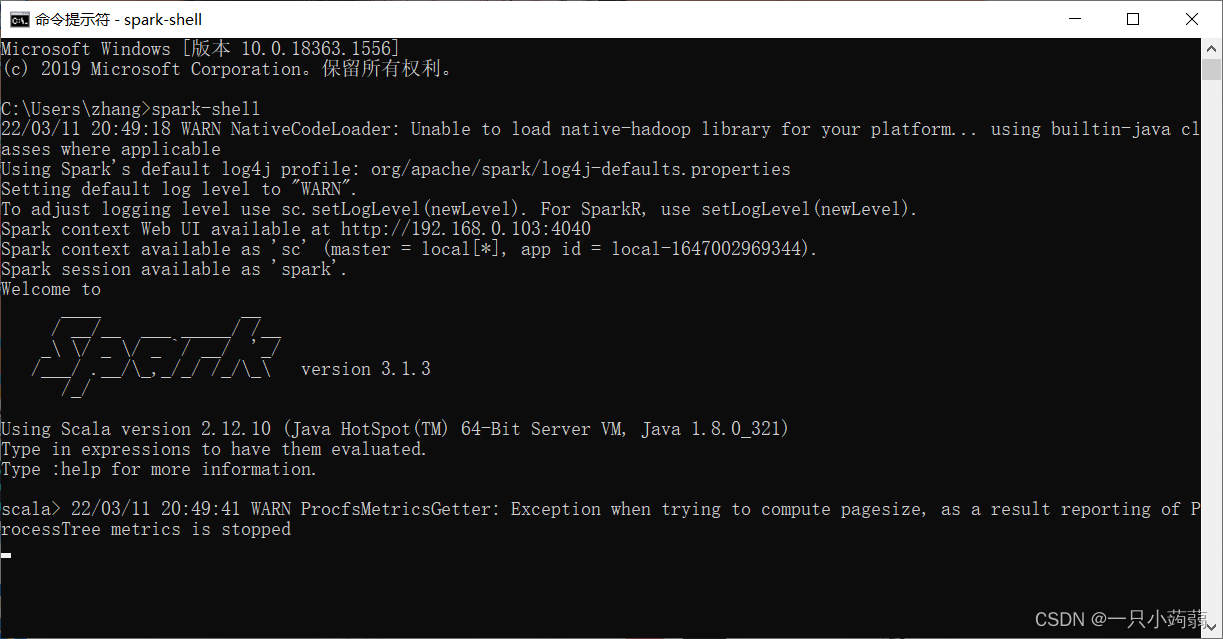

全部安装好之后命令行输入spark-shell,如果没有提示ERROR信息,只是一些警告WARN可以不管。这里解读一下命令行的提示: (1)有一个和Hadoop配置相关的警告,查阅资料也没找到简单的方法,索性不管了,反正不影响运行。 (2)Using Spark’s default log4j profile: org/apache/spark/log4j-defaults.properties这句话是指使用Spark默认的配置文件,路径在:%SPARK_HOME%\conf\log4j.properties.template.暂时不用管。

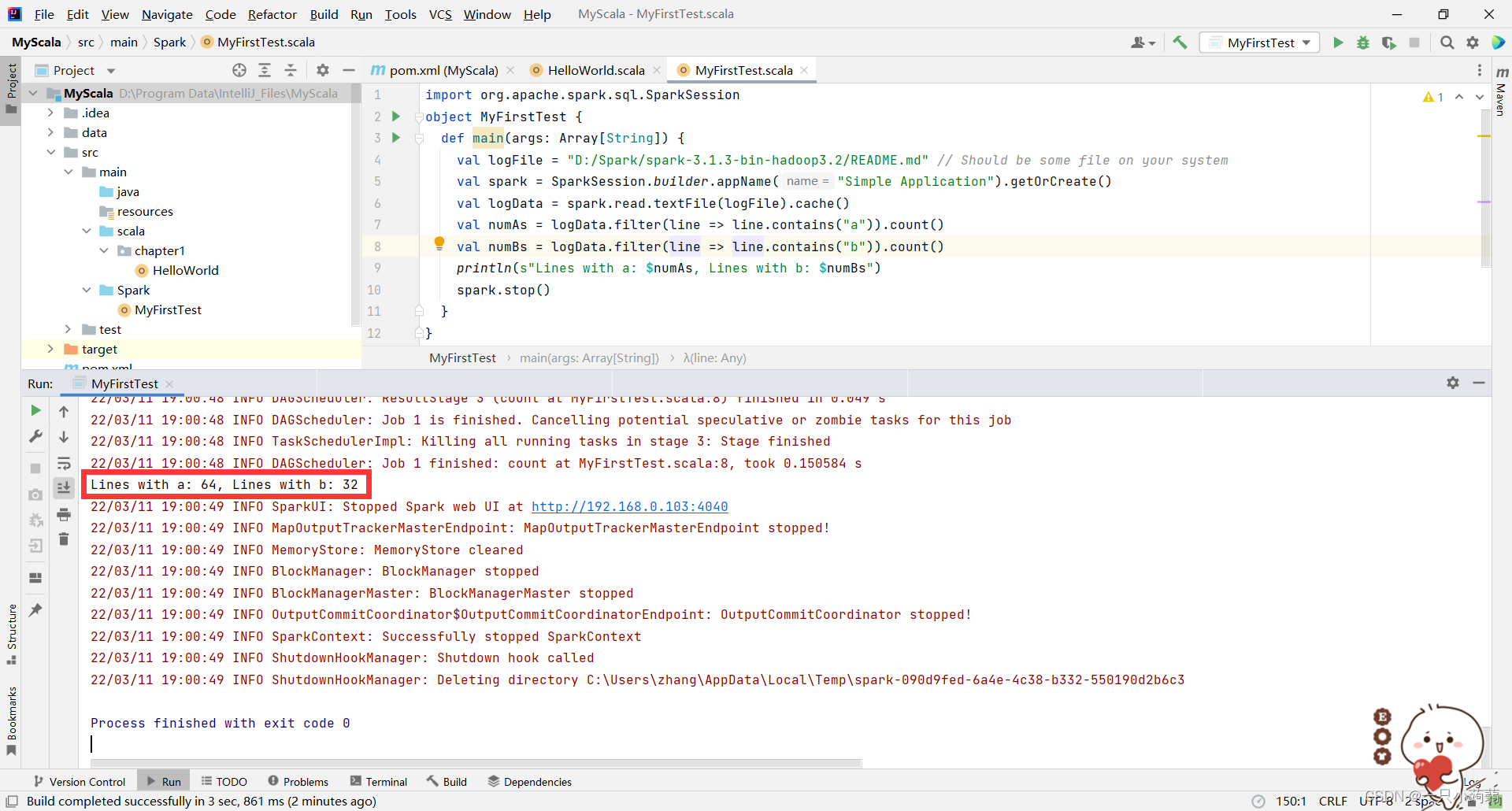

IntelliJ在业界被公认为最好的java开发工具,而Spark的原生态语言是Scala,Scala是Java的延伸,所以IntelliJ是一款很适合于运行Spark程序的集成开发环境。下载过程和基本的配置过程就不说了,可以参考这篇博客。 四、遇到的问题1.由于JDK版本太高,开始使用的最新版JDK,与Spark兼容性差,导致运行Spark程序时出现很多问题。如运行spark-shell出现java.lang.illegalAccessError。解决办法就是使用JDK8或者JDK11,Spark可能还不支持JDK17。 2.在IDEA中运行时,结果面板上出现很多INFO日志信息,而输出的结果只是隐藏在其中的一行,不易浏览。需要设置一下配置文件。前面说过路径%SPARK_HOME%\conf\log4j.properties.template是Spark的一个配置文件,我们拷贝该文件一份到IDEA工程文件下的src/main/resources文件夹,更改文件第一行log4j.rootCategory=INFO, console为log4j.rootCategory=ERROR, console,并将文件名log4j.properties.template改为log4j.properties即可。 修改前:

修改后:

|

【本文地址】