| chatgpt赋能Python | 您所在的位置:网站首页 › pyspark实战指南下载 › chatgpt赋能Python |

chatgpt赋能Python

|

PySpark数据预处理:让海量数据简单易处理

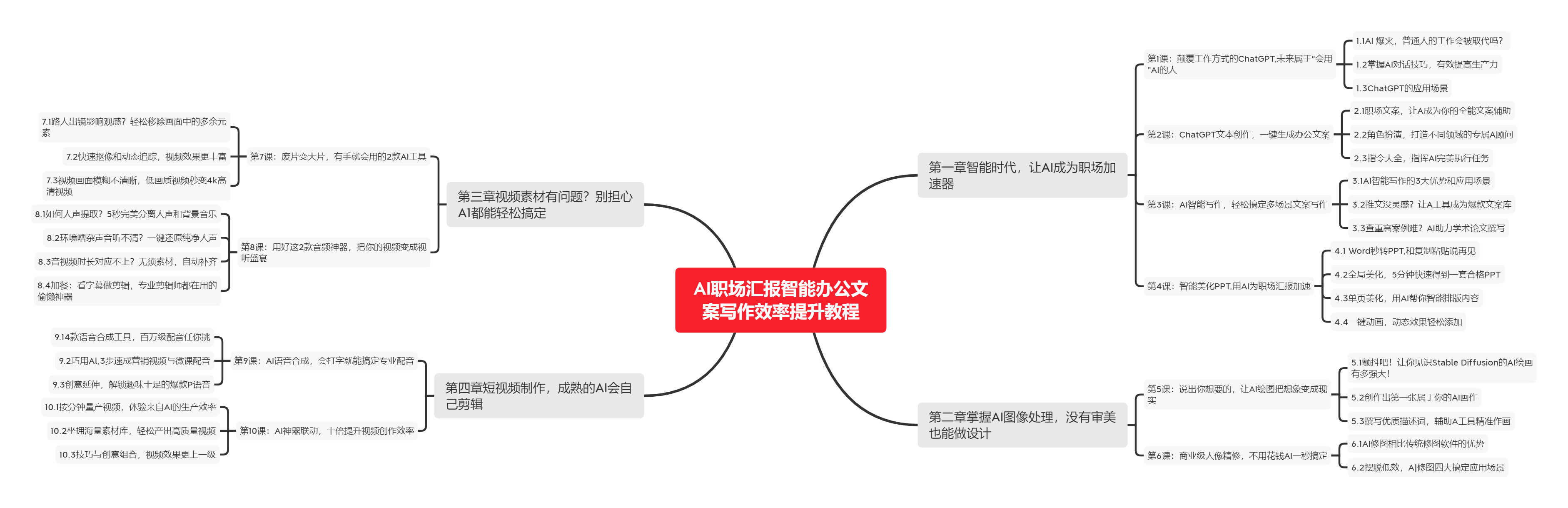

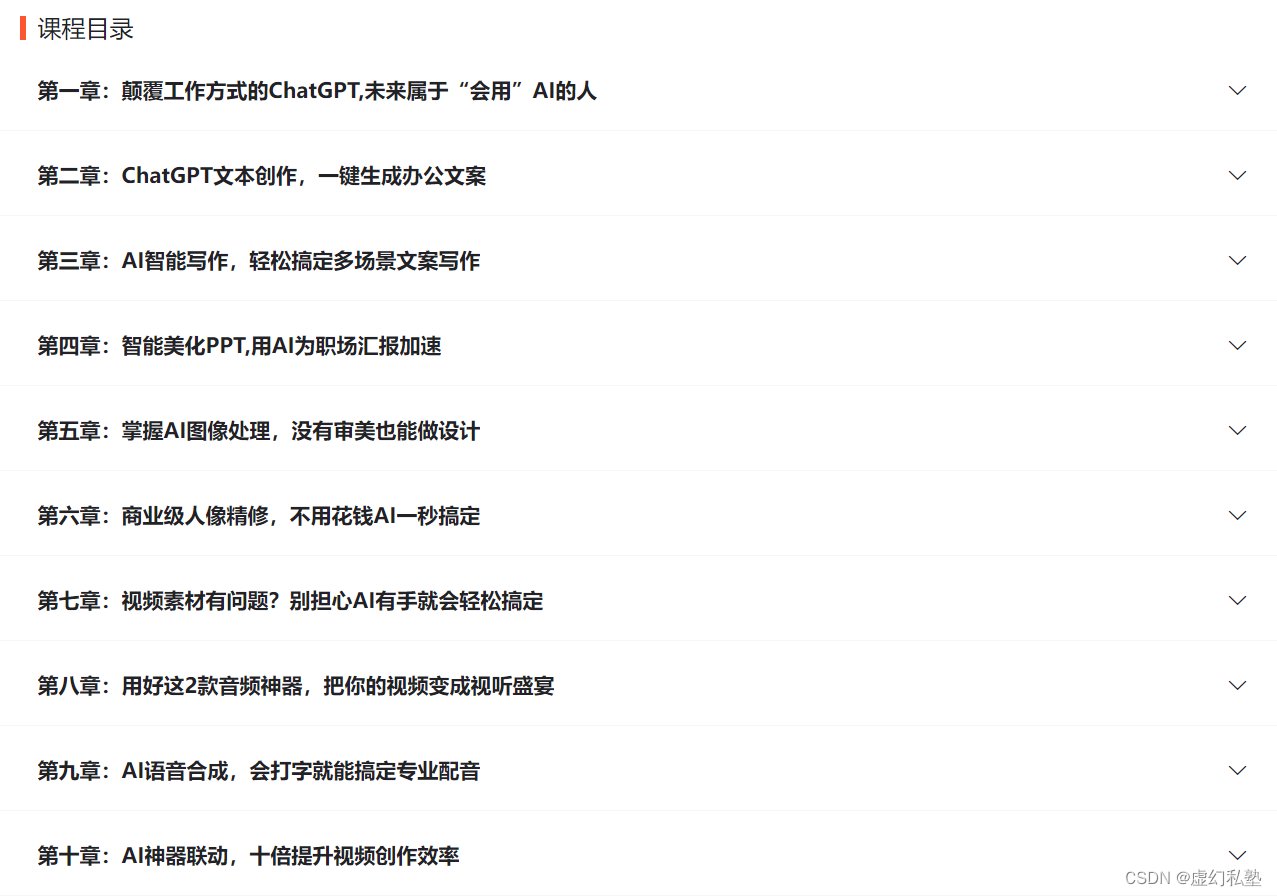

大数据已经成为当今数据行业的一种趋势,许多企业也投入了大量的时间和资源来处理海量数据。然而,许多业务工作人员可能不知道如何处理这些数据。在这种情况下,PySpark是一种非常强大的工具,可以帮助您简化数据处理。 什么是PySpark?PySpark是Apache Spark的Python API,Spark是一种分布式计算引擎,可用于在大数据集上进行高速计算。PySpark能够与Python生态系统中的其他工具(如NumPy、Pandas和Matplotlib)轻松集成,帮助您更快地进行数据预处理、建模和可视化。 数据预处理是什么?数据预处理是指在对数据进行分析之前,通过清洗、转换、集成和规范化等处理方法对数据进行加工和转换。 这有助于我们识别和纠正数据的错误和异常值,以确保数据集的质量和一致性。 PySpark的数据预处理技术 数据清洗如果数据集包含有缺少值和无用数据的情况,我们需要进行数据清洗,以保证数据的准确性。可以使用PySpark API中提供的方法,如na.drop()和na.fill(),来处理带有空值的数据,并使用drop()等方法来删除不相关的列和行。 数据转换在数据预处理中,数据转换是常见任务之一。可以使用PySpark的map()、flatMap()和filter()等方法,以及函数来转换数据,将数据从一种格式转换为另一种格式。 数据集成在数据集成中,我们需要将不同源的数据集合并为一个数据集。可以使用PySpark API中的join()和union()方法来合并数据集。此外,还可以使用Pandas库中的merge()方法,将数据集合并为一个数据集。 数据规范化在处理数据时,不同的数据源可能使用不同的格式、单位和编码格式。在数据规范化过程中,可以使用PySpark API中的方法,例如withColumnRenamed()和withColumn(),更改列名称并将数据转换为特定格式。 结论数据预处理是数据分析中的关键步骤,PySpark提供了丰富的数据预处理技术,这些技术的使用可以使您更轻松地处理和分析大规模数据集。通过PySpark,您可以利用Python语言和其他Python开源库的优势来创建高级数据预处理和分析工具。在PySpark的帮助下,您可以更快地清理、集成和规范化数据,缩短数据分析周期,并更加深入地了解数据之间的关系。 最后的最后本文由chatgpt生成,文章没有在chatgpt生成的基础上进行任何的修改。以上只是chatgpt能力的冰山一角。作为通用的Aigc大模型,只是展现它原本的实力。 对于颠覆工作方式的ChatGPT,应该选择拥抱而不是抗拒,未来属于“会用”AI的人。 🧡AI职场汇报智能办公文案写作效率提升教程 🧡 专注于AI+职场+办公方向。 下图是课程的整体大纲 |

【本文地址】

下图是AI职场汇报智能办公文案写作效率提升教程中用到的ai工具

下图是AI职场汇报智能办公文案写作效率提升教程中用到的ai工具