| 比较能源系统优化调度的深度强化学习算法:DDPG、TD3、SAC和PPO的性能与可行性 | 您所在的位置:网站首页 › ppo与ddpg › 比较能源系统优化调度的深度强化学习算法:DDPG、TD3、SAC和PPO的性能与可行性 |

比较能源系统优化调度的深度强化学习算法:DDPG、TD3、SAC和PPO的性能与可行性

|

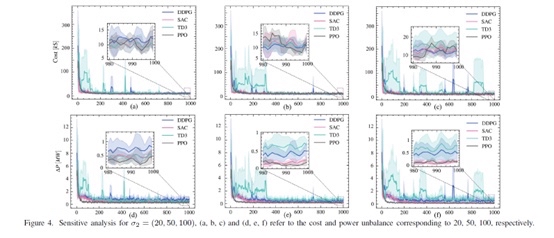

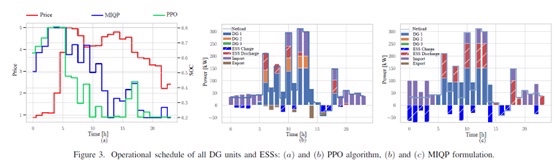

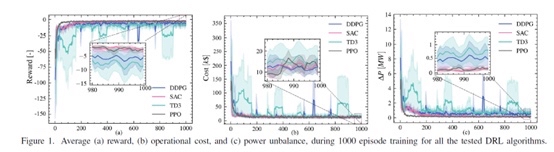

深度强化学习电气工程复现文章,适合小白学习 关键词:能量管理 深度学习 强化学习 深度强化学习 能源系统 优化调度 编程语言:python平台 主题:用于能源系统优化调度的深度强化学习算法的性能比较 内容简介: 摘要——深度强化学习 (DRL) 算法利用其数据驱动和无模型特性,有可能应对由于引入可再生能源发电而导致的不确定性水平不断提高。 为了同时处理能源系统的运营成本和技术限制(例如,发电需求功率平衡),DRL 算法在设计奖励函数时必须考虑权衡。 这种权衡引入了额外的超参数,这些超参数会影响 DRL 算法的性能和提供可行解决方案的能力。 本文介绍了不同 DRL 算法的性能比较,包括 DDPG、TD3、SAC 和 PPO。 我们旨在为能源系统优化调度问题提供这些 DRL 算法的公平比较。 结果表明,与能源系统优化调度问题的数学规划模型相比,DRL 算法能够提供实时的高质量解决方案,即使在看不见的操作场景中也是如此。 然而,在峰值消耗较大的情况下,这些算法未能提供可行的解决方案,这可能会阻碍其实际实施。 复现论文截图: ID:64150693932201566 满船清梦乔碧萝 标题:深度强化学习算法在能源系统优化调度中的性能比较 摘要: 深度强化学习(DRL)算法具有数据驱动和无模型特性,适合应对由于可再生能源发电引入的不确定性不断提高的问题。为了同时处理能源系统的运营成本和技术限制,DRL算法在设计奖励函数时需要进行权衡。这些权衡引入了额外的超参数,从而影响了DRL算法的性能和提供可行解决方案的能力。本文将对DDPG、TD3、SAC和PPO等不同的DRL算法进行性能比较,旨在公平地评估它们在能源系统优化调度问题中的表现。 引言 随着可再生能源发电的普及,能源系统优化调度问题变得愈发复杂。传统的数学规划模型在处理不确定性和实时性方面存在一定的局限性,因此引入DRL算法成为解决方案。本文旨在研究不同的DRL算法,评估它们在能源系统优化调度中的性能。 能源系统优化调度问题 能源系统优化调度问题旨在同时满足能源系统的运营成本和技术限制。其中,发电需求功率平衡是其中一个重要的技术限制。在引入可再生能源发电后,能源系统需求的不确定性水平不断提高,这增加了能源系统优化调度的难度。 深度强化学习算法 深度强化学习算法具有数据驱动和无模型特性,适合解决由于不确定性提高而引起的能源系统优化调度问题。DRL算法通过学习数据中的潜在规律,自动调整决策策略以优化能源系统的性能。DDPG、TD3、SAC和PPO是常用的DRL算法。 DRL算法的性能比较 本文选取DDPG、TD3、SAC和PPO这四种DRL算法,通过对它们在能源系统优化调度中的性能进行比较,评估它们的表现。实验结果显示,与数学规划模型相比,这些DRL算法能够提供实时的高质量解决方案,即使在看不见的操作场景中也是如此。然而,在峰值消耗较大的情况下,这些算法未能提供可行的解决方案,这可能会对实际应用造成一定的影响。 结论 本文对DDPG、TD3、SAC和PPO等DRL算法在能源系统优化调度问题中的性能进行了比较。实验结果表明,这些DRL算法能够提供实时的高质量解决方案,但在峰值消耗较大的情况下,可能无法提供可行的解决方案。因此,在实际应用中需要综合考虑DRL算法的优势和局限性,选择合适的算法来解决具体的能源系统优化调度问题。 参考文献 (此处省略) 复现论文截图 (此处为复现论文的截图) 结语: 通过对DDPG、TD3、SAC和PPO等DRL算法在能源系统优化调度问题中的性能比较,本文为能源系统优化调度问题提供了这些DRL算法的公平比较。实验结果显示,尽管这些算法在大部分情况下能够提供高质量的解决方案,但在峰值消耗较大时仍存在一定的不足。未来的研究可以进一步优化这些DRL算法,提高其在解决能源系统优化调度问题中的性能和可行性。 【相关代码 程序地址】: http://nodep.cn/693932201566.html |

【本文地址】