| 超越Sora极限,120秒超长AI视频模型诞生 | 您所在的位置:网站首页 › picsart剪视频 › 超越Sora极限,120秒超长AI视频模型诞生 |

超越Sora极限,120秒超长AI视频模型诞生

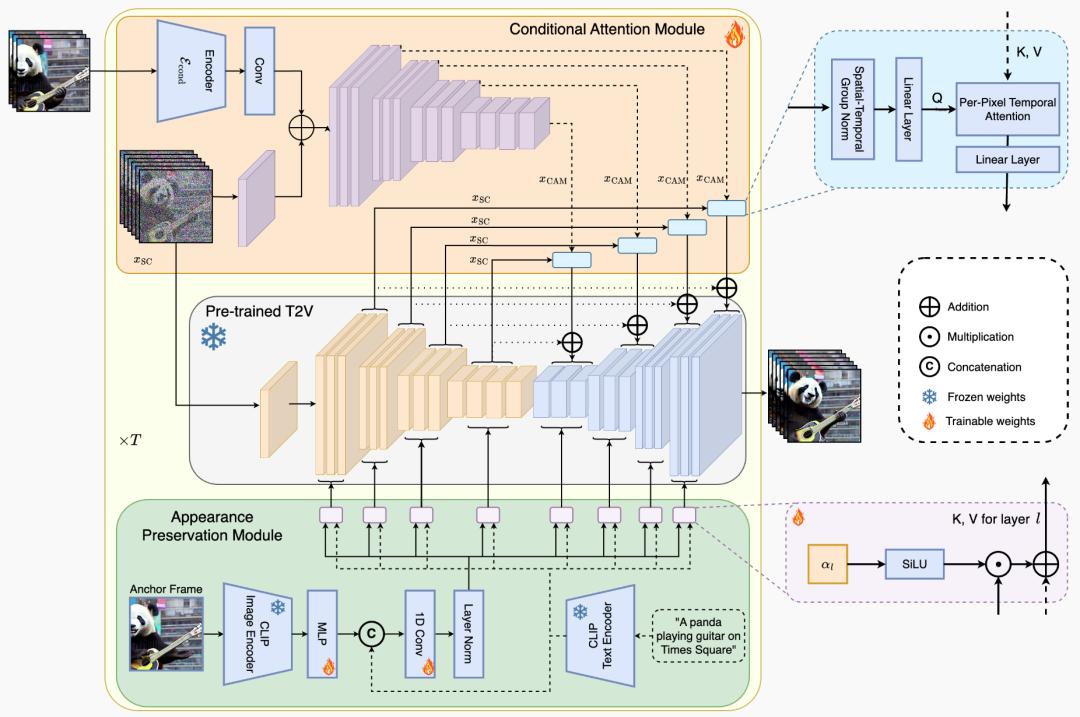

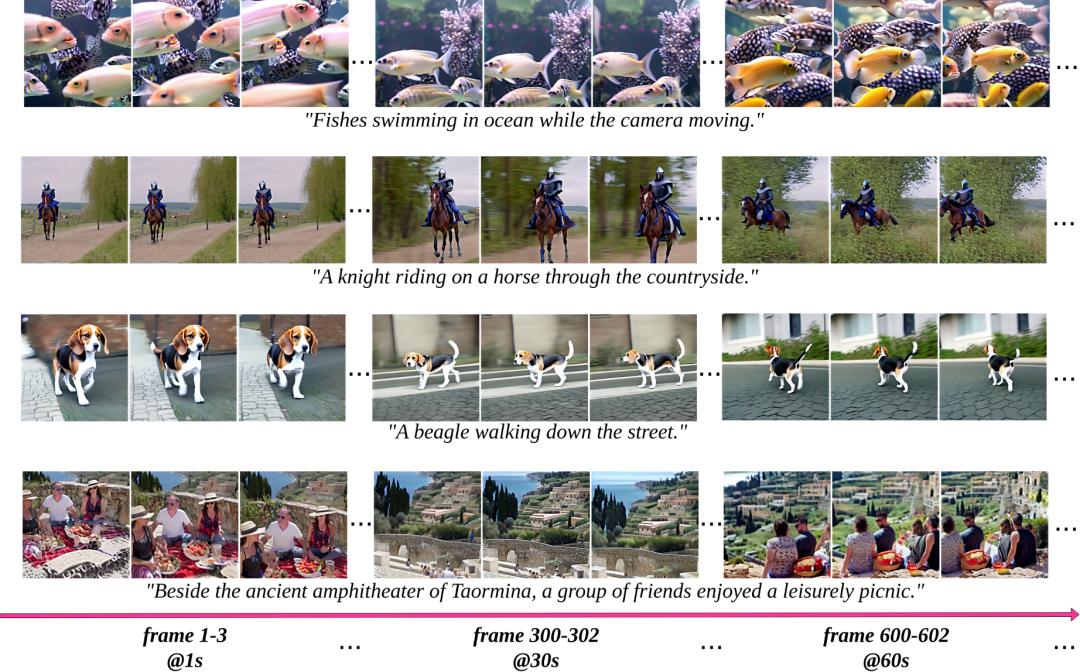

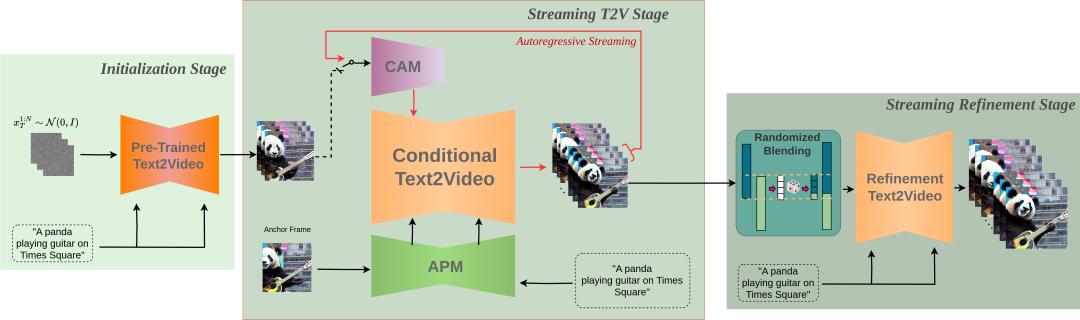

新智元报道 编辑:润 好困 【新智元导读】UT奥斯丁等机构提出了一种名为StreamingT2V的技术,让AI视频的长度扩展至近乎无限,而且一致性,动作幅度也非常好! Sora一出,文生视频的在长度这个指标上就卷的没边了。 从Pika和Runway的4秒,到VideoPoet的理论无限长,各个团队都在通过各种不同的技术路径不断延长视频生成长度的上限。 最近,来自Picsart AI Research,UT Austin和Shi Labs的研究团队提出了一个新的文生视频技术——StreamingT2,可以生成高度一致而且长度可扩展的视频。 文生视频技术进入长视频时代。  论文地址:https://arxiv.org/abs/2403.14773 具体来说,StreamingT2V可以生成1200帧甚至理论上无限长的长视频,并且能保证视频内容过渡非常自然平滑,内容丰富多样。 帝国士兵在烟雾中不停奔跑,虽然动作很滑稽,但是幅度很大,人物一致性很好。 它的核心构架由3个部分组成: - 一个短期记忆单元——条件注意力模块(CAM),它能够确保视频的连贯性,通过关注前一个视频片段的特征来引导当前片段的生成; - 一个长期记忆单元——外观保持模块,它帮助模型记住视频开头的场景和对象,防止随着时间推移而遗忘开头的场景; - 一种随机混合技术,使得即使是无限长的视频也能保持一致性,避免了视频片段之间的不协调。  而且,StreamingT2V的特点并不限定于使用特定的文生视频模型。 这意味着只要将基础模型的性能不断提高,生成的视频效果还能不断提升。  效果展示 1200帧,2分钟 可以看到,在两分钟的视频中场景的动态效果很好,虽然在细微材质上还是有一些粗糙和畸变,但是整体的运动幅度基本上已经达到了Sora的水准。 和其他的「长」视频AI技术相比,StreamingT2V的动态效果明显好太多了。 600帧 1分钟 整个镜头的晃动感有一种手持摄影机拍摄的风格,而且鸟的动作细节也很真实。 蜜蜂在花上的运动效果也很逼真,镜头运动幅度和动作幅度都很大,而且蜜蜂形态的一致性保持得也很好。 航拍镜头的运动也很合理,只是场景中的大面积的植物颜色和细节还是不太稳定。 虽然珊瑚还是会出现无中生有的情况,但是镜头运动的幅度和场景整体的一致性已经非常高了。 240帧,24秒  而这个圣诞老人虽然动作显得非常鬼畜滑稽,但是一致性保持得非常好,动作幅度更是吊打大部分的文生视频模型。  对于爆炸和烟雾的处理也已经非常成熟,逼真了。  开花的动态效果非常自然,已经可以以假乱真真实的加速播放的静物运动摄影了。  80帧,8秒 在时间更短的的视频中,无论是内容的一致性和动作的自然程度和动作幅度效果都很好。       只是在场景和环境的表现上,还有一些明显的瑕疵。 实现方法  StreamingT2V技术的工作流程可以分为三个主要阶段。 首先,在初始化阶段,研究人员利用一个文本到视频的模型来创造出视频的前16帧,这相当于视频的起始段落。 接下来,进入Streaming T2V阶段,研究人员会继续生成视频的后续帧,这一过程是通过一种称为自回归的技术来实现的,意味着每一个新帧的生成都会参考之前已生成的帧,从而确保视频内容的连贯性。 最后,在Streaming Refinement阶段,研究人员对已生成的长视频(无论是600帧、1200帧还是 |

【本文地址】