| lstm对时间数据的预测作用(多变量对多变量预测) | 您所在的位置:网站首页 › lstm预测效果差 › lstm对时间数据的预测作用(多变量对多变量预测) |

lstm对时间数据的预测作用(多变量对多变量预测)

|

思考: 如何处理原始数据,空值?无意义列?数据归一化?异常值?时序数据预测问题的数据格式如何构造(X,Y);如何使用LSTM来预测时序数据(输入输出?多加几成lstm注意什么?return_sequences=True?);如何用模型预测?生成结果注意什么?反归一化再进行比较。归(反归)一化注意什么?模型参数如何调整?例如:学习率如何调整? 1.使用lstm进行空气污染预测介绍 采用空气质量数据集。数据来源自位于北京的美国大使馆在2010年至2014年共5年间每小时采集的天气及空气污染指数。目的:利用前一个或几个小时的天气条件和污染数据预测下一个(当前)时刻/(或者后几个时刻的数据)的污染程度(预测PM2.5浓度)(本文示例用前五个时刻的数据预测后五个时刻的数据)原始数据如下:1.No 行数 2.year 年 3.month 月 4.day 日 5.hour 小时 6.pm2.5 PM2.5浓度 7.DEWP 露点 8.TEMP 温度 9.PRES 大气压 10.cbwd 风向 11.lws 风速 12.ls 累积雪量 13.lr 累积雨量 2.数据预处理

2.数据预处理

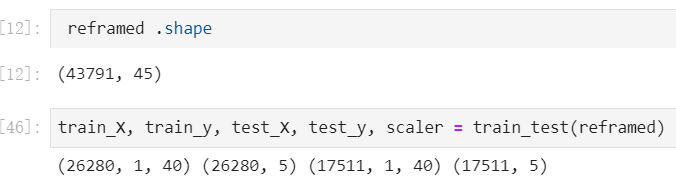

1. 数据清洗 将日期(年月日时)合并为一个日期,并作为表的索引删除没有意义的NO列为列名重起好理解的名字空值处理(NA),充填0观察到2010年1月1日pm2.5为NA,将该天数据删除形成一个新表导入包 #导入用到的包 import pandas as pd from datetime import datetime from matplotlib import pyplot from sklearn.preprocessing import LabelEncoder, MinMaxScaler from sklearn.metrics import mean_squared_error from keras.models import Sequential from keras.layers import Dense from keras.layers import LSTM, Dropout from numpy import concatenate from math import sqrt from keras.callbacks import ReduceLROnPlateau数据清洗(详细注释): def parse(x): return datetime.strptime(x, '%Y %m %d %H') def read_raw(): dataset = pd.read_csv('raw.csv', parse_dates=[['year', 'month', 'day', 'hour']], index_col=0, date_parser=parse) #将日期合并 dataset.drop('No', axis=1, inplace=True) #删除no列(无意义) # manually specify column names dataset.columns = ['pollution', 'dew', 'temp', 'press', 'wnd_dir', 'wnd_spd', 'snow', 'rain'] #给每列换个好理解的名 dataset.index.name = 'date' #行的索引名为name,解析得到的日期格式列会作为DataFrame的第一列。则此时会以新生成的time_date列而不是name作为Index。因此保险的方法是指定列名,如index_col = 'name' # mark all NA values with 0 dataset['pollution'].fillna(0, inplace=True) # drop the first 24 hours dataset = dataset[24:] #删除第一天的数据,取列表24行之后的数据 # summarize first 5 rows print(dataset.head(5)) # save to file dataset.to_csv('pollution.csv')形成的数据格式: 2.对每列数据进行绘图观测(5年数据),除了日期。 绘图代码: def drow_pollution(): dataset = pd.read_csv('pollution.csv', header=0, index_col=0) values = dataset.values #取文件中的值 # specify columns to plot groups = [0, 1, 2, 3, 5, 6, 7] i = 1 # plot each column pyplot.figure(figsize=(10, 10)) for group in groups: pyplot.subplot(len(groups), 1, i) pyplot.plot(values[:, group]) pyplot.title(dataset.columns[group], y=0.5, loc='right') i += 1 pyplot.show()结果: 提取需要的输入: def cs_to_sl(): # load dataset dataset = pd.read_csv('pollution.csv', header=0, index_col=0) values = dataset.values # integer encode direction encoder = LabelEncoder() #先构造encoder,通过fit函数传入需要编码的数据,在内部生成对应的key-value,然后encoder 用于需要转化的数据,用transform函数 values[:, 4] = encoder.fit_transform(values[:, 4]) #先将object对象转化为硬编码 # ensure all data is float values = values.astype('float32') # frame as supervised learning reframed = series_to_supervised(values, 5, 5) # drop columns we don't want to predict 删掉我们不想要的输出,留下40,48,56,64,72(5天的数据) reframed.drop(reframed.columns[[41,42,43,44,45,46,47,49,50,51,52,53,54,55,57,58,59,60,61,62,63,65,66,67,68,69,70,71,73, 74, 75, 76, 77, 78, 79]], axis=1, inplace=True) print(reframed.head()) return reframed #reframed.shape:(43791, 45)生成结果:  4.模型的训练集和测试集的划分:

首先对数据进行归一化处理,返回归一化的函数,后面好使用反归一化。归一化不关注数据的大小长度信息,关注数据与数据之间的联系,相对属性三年前的数据为训练集,三年后的为测试集调整模型数据的输入维度(lstm需要输入三维数据)

def train_test(reframed):

# split into train and test sets

values = reframed.values

scaler11 = MinMaxScaler(feature_range=(0, 1))

values = scaler11.fit_transform(values)

n_train_hours = 365 * 24*3 #

train = values[:n_train_hours, :]

test = values[n_train_hours:, :]

# split into input and outputs

train_X, train_y = train[:, :-5],train[:, -5:]

test_X, test_y = test[:, :-5], test[:, -5:]

train_X = train_X.reshape((train_X.shape[0], 1, train_X.shape[1])) #train_X开始2维,(26280,40)变成三维(26280, 1, 40)train_y:(26280,5)

test_X = test_X.reshape((test_X.shape[0], 1, test_X.shape[1]))

print(train_X.shape, train_y.shape, test_X.shape, test_y.shape)

return train_X, train_y, test_X, test_y, scaler11

4.模型的训练集和测试集的划分:

首先对数据进行归一化处理,返回归一化的函数,后面好使用反归一化。归一化不关注数据的大小长度信息,关注数据与数据之间的联系,相对属性三年前的数据为训练集,三年后的为测试集调整模型数据的输入维度(lstm需要输入三维数据)

def train_test(reframed):

# split into train and test sets

values = reframed.values

scaler11 = MinMaxScaler(feature_range=(0, 1))

values = scaler11.fit_transform(values)

n_train_hours = 365 * 24*3 #

train = values[:n_train_hours, :]

test = values[n_train_hours:, :]

# split into input and outputs

train_X, train_y = train[:, :-5],train[:, -5:]

test_X, test_y = test[:, :-5], test[:, -5:]

train_X = train_X.reshape((train_X.shape[0], 1, train_X.shape[1])) #train_X开始2维,(26280,40)变成三维(26280, 1, 40)train_y:(26280,5)

test_X = test_X.reshape((test_X.shape[0], 1, test_X.shape[1]))

print(train_X.shape, train_y.shape, test_X.shape, test_y.shape)

return train_X, train_y, test_X, test_y, scaler11

结果为: 实验结果: 参考: 1.使用Keras进行LSTM实战 |

【本文地址】

公司简介

联系我们

总结:

总结: