| 音视频同步的方法:深入探索基于FFmpeg的音视频同步策略 | 您所在的位置:网站首页 › ffmpeg延迟时间设置 › 音视频同步的方法:深入探索基于FFmpeg的音视频同步策略 |

音视频同步的方法:深入探索基于FFmpeg的音视频同步策略

|

音视频同步艺术:深入探索基于FFmpeg的同步策略

(一)音视频同步的基本概念与重要性(Basic Concepts and Importance of Audio-Video Synchronization)1.1 音视频同步的定义与影响(Definition and Impact of Audio-Video Synchronization)1.2 音视频同步的挑战与常见问题(Challenges and Common Issues in Audio-Video Synchronization)1.3 音视频同步的重要性(Importance of Audio-Video Synchronization)

二、音视频同步的常见方法概述2.1 时间戳同步方法(Timestamp Synchronization Method)2.2 帧率控制同步方法(Frame Rate Control Synchronization Method)2.3 缓冲区控制同步方法(Buffer Control Synchronization Method)

三、深入探讨以音频为基准的同步方法(In-depth Exploration of Audio-Based Synchronization Methods)3.1 音频为基准的同步方法的基本原理(Basic Principles of Audio-Based Synchronization Method)3.2 音频为基准的同步方法的实现步骤(Implementation Steps of Audio-Based Synchronization Method)3.3 音频为基准的同步方法的优势与局限(Advantages and Limitations of Audio-Based Synchronization Method)

四、音视频同步的高级应用与实践(Advanced Applications and Practices of Audio-Video Synchronization)4.1 音视频同步在直播中的应用(Application of Audio-Video Synchronization in Live Streaming)4.2 音视频同步在VR/AR中的应用(Application of Audio-Video Synchronization in VR/AR)4.3 音视频同步在嵌入式设备中的应用(Application of Audio-Video Synchronization in Embedded Devices)

五、音频为基准的同步方法的编程实践(Programming Practice of Audio-Based Synchronization Methods)5.1 音频为基准同步方法的基本原理(Basic Principles of Audio-Based Synchronization Method)5.2 音频为基准的同步方法的实现步骤(Implementation Steps of Audio-Based Synchronization Method)5.3 PID 控制 5.4 对比

六、疑问解答6.1 怎么保证丢弃的帧用户觉察不到? 6.2 音频缓冲区和音频设备缓冲区会冲突么? 6.3 删除帧可以理解,插入额外帧指哪些帧? 6.4 调整帧率具体怎么做,是调整解码器帧率?6.5 如何判断用户无法觉察的时间区间?6.6 缓冲区的数据结构选择?6.7 音视频两者处理速度是不一致的,怎么调整同步?6.8 音视频两者样本数是不一样的,怎么进行同步?6.9 是否一般以秒为单位计算同步区间?

(一)音视频同步的基本概念与重要性(Basic Concepts and Importance of Audio-Video Synchronization)

1.1 音视频同步的定义与影响(Definition and Impact of Audio-Video Synchronization)

音视频同步(Audio-Video Synchronization),也常被称为口唇同步(Lip Sync),是指在播放过程中,图像与声音的播放时间保持一致,使得观众感觉到图像与声音是同时发生的。在实际的音视频处理过程中,由于音频和视频的处理速度可能不同,或者由于网络传输的延迟,可能会导致音视频不同步的情况发生。 音视频不同步的情况会严重影响观众的观看体验。例如,当我们观看一部电影时,如果画面中的人物的口型动作和声音不同步,我们会感到非常不适。这是因为我们的大脑习惯于将看到的图像和听到的声音进行关联,如果这两者不同步,就会产生认知上的困扰。 音视频同步的问题在很多领域都有可能出现,例如在电视广播、网络直播、视频会议等场景中。在这些场景中,由于音视频数据需要通过网络传输,而网络的延迟和丢包等问题可能会导致音视频数据到达播放设备的时间不同步。因此,如何确保音视频同步,是音视频处理技术中的一个重要问题。 在解决音视频同步的问题时,我们通常会采用一些同步策略,例如基于时间戳的同步策略、基于帧率的同步策略等。这些策略的目标都是尽可能地使得音视频数据在播放时能够保持同步。 1.2 音视频同步的挑战与常见问题(Challenges and Common Issues in Audio-Video Synchronization)音视频同步是一项技术挑战,因为它涉及到多个复杂的因素。以下是一些常见的挑战和问题: 处理速度的差异(Processing Speed Differences):音频和视频数据的处理速度可能会有所不同。例如,视频数据通常比音频数据更复杂,因此处理视频数据可能需要更多的时间。这可能导致音频数据比视频数据先被处理和播放,从而导致音视频不同步。 网络延迟(Network Latency):在网络传输中,音频和视频数据可能会受到不同程度的延迟。例如,由于网络拥塞或其他因素,视频数据可能会比音频数据到达播放设备的时间晚。这也可能导致音视频不同步。 数据丢失(Data Loss):在网络传输过程中,音频和视频数据都可能会丢失。如果丢失的是音频数据,那么播放设备可能会继续播放视频数据,但没有对应的音频数据,这会导致音视频不同步。反之亦然。 设备性能(Device Performance):播放设备的性能也可能影响音视频同步。例如,如果设备的处理能力不足,可能无法及时处理音频和视频数据,从而导致音视频不同步。 解决这些挑战需要深入理解音视频处理的原理,并采用有效的同步策略。在接下来的章节中,我们将详细介绍这些策略,以及如何在实际的音视频处理过程中应用这些策略。 1.3 音视频同步的重要性(Importance of Audio-Video Synchronization)音视频同步是影音体验中的关键因素,其重要性不容忽视。当音频和视频之间的同步丢失时,用户体验会大大降低。下面是一个简单的示意图,描述了音视频不同步可能导致的一些问题:

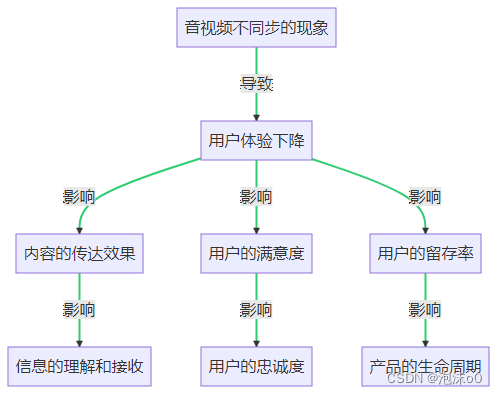

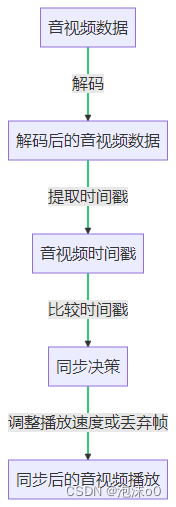

如图所示,音视频不同步的现象会导致用户体验下降,进而影响内容的传达效果、用户的满意度和留存率。这些影响进一步影响到信息的理解和接收、用户的忠诚度,以及产品的生命周期。 内容的传达效果(Content Delivery Effect):音视频同步是确保信息正确传达的关键。如果音频和视频不同步,可能会导致观众理解错误,影响信息的传达效果。 用户的满意度(User Satisfaction):音视频同步直接影响用户的观看体验。如果音频和视频不同步,用户可能会感到不适,导致满意度下降。 用户的留存率(User Retention):音视频同步也影响用户的留存率。如果用户在观看过程中经常遇到音视频不同步的问题,他们可能会选择离开,转向其他平台。 信息的理解和接收(Information Understanding and Reception):音视频同步对于信息的理解和接收至关重要。音视频不同步可能会导致观众无法正确理解信息,影响信息的接收。 用户的忠诚度(User Loyalty):音视频同步可以影响用户的忠诚度。如果用户经常遇到音视频不同步的问题,他们可能会对平台失去信任,影响用户的忠诚度。 产品的生命周期(Product Lifecycle):音视频同步也可以影响产品的生命周期。如果音视频不同步的问题无法得到解决,可能会导致产品的生命周期缩短。 因此,音视频同步不仅影响用户体验,还可能影响到产品的生命周期和公司的盈利能力。这就是为什么我们需要深入研究音视频同步,找到有效的解决方案。 二、音视频同步的常见方法概述 2.1 时间戳同步方法(Timestamp Synchronization Method)在音视频处理中,时间戳同步是一种常见的同步方法。它的基本原理是利用音频和视频的时间戳(Timestamp)来进行同步。时间戳是在编码时附加在每个音频和视频帧上的,表示该帧在整个流中的播放时间位置。 在解码后,我们可以提取出每个音频和视频帧的时间戳,然后比较音频和视频的时间戳,根据比较结果做出同步决策。例如,如果视频帧的时间戳比音频帧的时间戳早,那么我们可以稍微减慢视频的播放速度,或者丢弃一些视频帧,以便让音频赶上视频;反之,如果音频帧的时间戳比视频帧的时间戳早,那么我们可以稍微减慢音频的播放速度,或者丢弃一些音频帧,以便让视频赶上音频。 下图是一个简单的时间戳同步流程图:

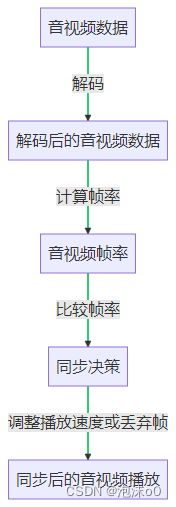

这种方法的优点是实现相对简单,只需要对时间戳进行比较和调整即可。但是,它也有一些局限性。例如,如果音频和视频的时间戳不准确,或者音视频数据丢失或损坏,可能会导致同步失败。此外,这种方法也不能解决音视频的漂移问题,即音视频的播放速度不匹配,导致随着时间的推移,音视频的同步性逐渐失效。 2.2 帧率控制同步方法(Frame Rate Control Synchronization Method)帧率控制同步方法是另一种常见的音视频同步方法。它的基本原理是通过控制音频和视频的播放帧率来实现同步。 在解码后,我们可以计算出音频和视频的帧率,然后比较音频和视频的帧率,根据比较结果做出同步决策。例如,如果视频的帧率比音频的帧率高,那么我们可以稍微减慢视频的播放速度,或者丢弃一些视频帧,以便让音频赶上视频;反之,如果音频的帧率比视频的帧率高,那么我们可以稍微减慢音频的播放速度,或者丢弃一些音频帧,以便让视频赶上音频。 下图是一个简单的帧率控制同步流程图:

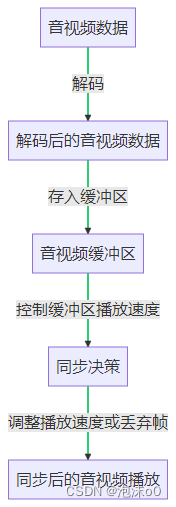

这种方法的优点是可以较好地处理音视频的漂移问题,即音视频的播放速度不匹配,导致随着时间的推移,音视频的同步性逐渐失效。但是,它也有一些局限性。例如,如果音频和视频的帧率不准确,或者音视频数据丢失或损坏,可能会导致同步失败。此外,这种方法可能会导致视频的播放不够流畅,因为需要频繁地调整播放速度或丢弃帧。 2.3 缓冲区控制同步方法(Buffer Control Synchronization Method)缓冲区控制同步方法是第三种常见的音视频同步方法。它的基本原理是通过控制音频和视频数据在缓冲区中的播放速度来实现同步。 在解码后,我们将音频和视频数据存入缓冲区。然后,我们可以通过控制缓冲区中音频和视频数据的播放速度来实现同步。例如,如果视频数据在缓冲区中的播放速度比音频数据快,那么我们可以稍微减慢视频数据的播放速度,或者丢弃一些视频帧,以便让音频赶上视频;反之,如果音频数据在缓冲区中的播放速度比视频数据快,那么我们可以稍微减慢音频数据的播放速度,或者丢弃一些音频帧,以便让视频赶上音频。 下图是一个简单的缓冲区控制同步流程图:

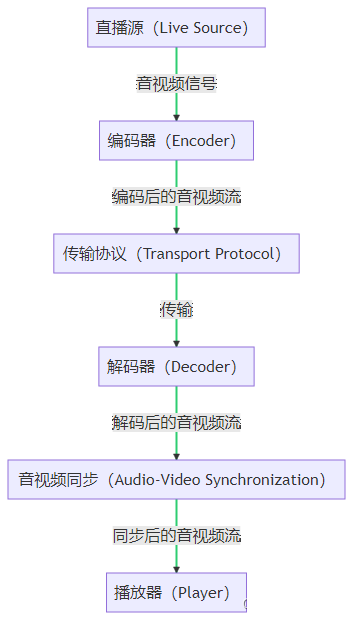

这种方法的优点是可以较好地处理音视频数据的丢失或损坏问题,因为缓冲区可以提供一定的容错能力。但是,它也有一些局限性。例如,如果缓冲区的大小不合适,或者缓冲区的管理策略不合理,可能会导致同步失败。此外,这种方法可能会导致视频的播放不够流畅,因为需要频繁地调整播放速度或丢弃帧。 三、深入探讨以音频为基准的同步方法(In-depth Exploration of Audio-Based Synchronization Methods) 3.1 音频为基准的同步方法的基本原理(Basic Principles of Audio-Based Synchronization Method)音频为基准的同步方法(Audio-Based Synchronization Method)是一种常见的音视频同步策略,它的核心思想是以音频流作为同步的基准,然后调整视频流以达到音视频同步的效果。这种方法的出发点是音频的连续性和稳定性通常比视频更好,因此以音频为基准可以提高同步的稳定性和准确性。 在实际应用中,音频为基准的同步方法主要涉及以下几个关键步骤: 音频解码(Audio Decoding):首先,我们需要对音频流进行解码,得到原始的音频数据。在这个过程中,我们需要注意音频的采样率(Sampling Rate)、声道数(Channel Number)等参数,这些参数将影响后续的同步过程。 音频时间戳(Audio Timestamp):解码后的音频数据会有一个对应的时间戳,这个时间戳通常是由音频编码时的采样率决定的。音频时间戳是同步过程的关键,我们需要根据音频时间戳来调整视频的播放。 视频调整(Video Adjustment):在得到音频时间戳后,我们需要对视频流进行调整,使其与音频流同步。这个过程可能涉及到视频帧的丢弃、插入等操作,具体的操作取决于音频和视频的时间戳差。 同步校验(Synchronization Verification):最后,我们需要对同步结果进行校验,确保音视频同步的准确性。这个过程可以通过计算音视频时间戳的差值、观察音视频的播放效果等方式进行。 以上就是音频为基准的同步方法的基本原理,接下来我们将深入探讨这个方法的实现步骤和具体应用。 3.2 音频为基准的同步方法的实现步骤(Implementation Steps of Audio-Based Synchronization Method)实现以音频为基准的同步方法,需要经过以下几个步骤: 音频解码与时间戳获取(Audio Decoding and Timestamp Acquisition):首先,我们需要对音频流进行解码,得到原始的音频数据。同时,我们需要获取每个音频帧的时间戳。这个时间戳通常是由音频编码时的采样率决定的,它代表了音频帧在整个音视频流中的相对位置。 视频解码与时间戳获取(Video Decoding and Timestamp Acquisition):与音频解码类似,我们也需要对视频流进行解码,得到原始的视频帧。同时,我们需要获取每个视频帧的时间戳。视频帧的时间戳通常是由视频编码时的帧率决定的,它代表了视频帧在整个音视频流中的相对位置。 音视频同步(Audio-Video Synchronization):在获取了音频和视频的时间戳后,我们需要进行音视频同步。具体来说,我们需要比较音频和视频的时间戳,然后根据比较结果调整视频的播放。如果音频时间戳落后于视频时间戳,我们需要暂停视频的播放,等待音频的播放;如果音频时间戳超前于视频时间戳,我们需要快进视频的播放,追赶音频的播放。 同步效果校验(Synchronization Effect Verification):最后,我们需要对同步效果进行校验。我们可以通过计算音视频时间戳的差值、观察音视频的播放效果等方式进行校验。如果同步效果不理想,我们需要调整同步策略,重新进行同步。 3.3 音频为基准的同步方法的优势与局限(Advantages and Limitations of Audio-Based Synchronization Method)音频为基准的同步方法在实际应用中具有一些显著的优势,但也存在一些局限性。以下是对这些优势和局限的详细讨论: 优势(Advantages): 稳定性(Stability):由于音频流的连续性和稳定性通常比视频流更好,因此以音频为基准的同步方法可以提供更稳定的同步效果。 准确性(Accuracy):音频为基准的同步方法通过精确控制视频的播放,以匹配音频的播放,从而可以提供较高的同步准确性。 灵活性(Flexibility):音频为基准的同步方法可以适应各种不同的音视频流,包括不同的编码格式、不同的播放环境等。 局限(Limitations): 处理复杂性(Processing Complexity):音频为基准的同步方法需要对音视频流进行精确的控制,这可能会增加处理的复杂性。 资源需求(Resource Demand):音频为基准的同步方法可能需要更多的计算资源和内存资源,以支持精确的同步控制。 同步延迟(Synchronization Delay):在某些情况下,音频为基准的同步方法可能会导致同步延迟,特别是当音频流和视频流的编码格式或播放环境有较大差异时。 以上就是音频为基准的同步方法的优势与局限,理解这些优势和局限有助于我们更好地选择和使用音视频同步方法。 四、音视频同步的高级应用与实践(Advanced Applications and Practices of Audio-Video Synchronization) 4.1 音视频同步在直播中的应用(Application of Audio-Video Synchronization in Live Streaming)在直播应用中,音视频同步是至关重要的。由于网络延迟和数据包丢失等因素,音频和视频数据可能会在不同的时间到达播放器,导致音视频不同步。这种情况下,我们需要采用一些策略来确保音视频同步。 下面是一个简单的直播系统的工作流程图:

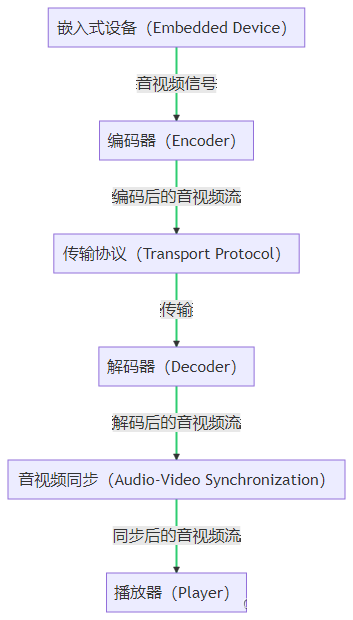

在这个流程中,音视频同步主要在播放器(Player)部分进行。以下是一些常见的同步策略: 基于时间戳的同步(Timestamp-based Synchronization):在编码时,音频和视频帧会被赋予一个时间戳(Timestamp),表示它们应该在什么时候被播放。播放器会根据这些时间戳来播放音视频,从而实现同步。 基于缓冲区的同步(Buffer-based Synchronization):播放器会为音频和视频各自维护一个缓冲区(Buffer)。当缓冲区中的数据达到一定量时,播放器会开始播放。通过控制缓冲区的大小,可以在一定程度上实现音视频同步。 基于帧率的同步(Frame Rate-based Synchronization):在某些情况下,我们可以通过控制音视频的帧率(Frame Rate)来实现同步。例如,如果视频的帧率是30帧/秒,音频的采样率是48000采样/秒,那么每播放一帧视频,就应该播放1600个音频采样。 以上是一些基本的同步策略,但在实际应用中,可能需要根据具体情况进行调整和优化。例如,当网络条件不好时,可能需要动态调整缓冲区的大小或者改变帧率来保持同步。 在下一部分,我们将深入探讨这些同步策略的具体实现和优化方法。 4.2 音视频同步在VR/AR中的应用(Application of Audio-Video Synchronization in VR/AR)在虚拟现实(VR)和增强现实(AR)应用中,音视频同步的重要性更为突出。由于VR/AR设备需要提供高度沉浸式的体验,任何微小的音视频不同步都可能导致用户感到不适,甚至产生眩晕等症状。因此,VR/AR设备需要采用更为精确和高效的同步策略。 下面是一个简单的VR/AR系统的工作流程图:

在这个流程中,音视频同步主要在渲染器(Renderer)部分进行。以下是一些常见的同步策略: 基于时间戳的同步(Timestamp-based Synchronization):这与直播应用中的策略类似,都是通过时间戳来控制音视频的播放。但在VR/AR应用中,由于需要提供实时的交互体验,时间戳的精度需要更高。 基于传感器数据的同步(Sensor Data-based Synchronization):VR/AR设备通常会配备各种传感器,如陀螺仪、加速度计等,用于检测用户的头部或身体的运动。这些传感器数据可以用来调整音视频的播放,以实现更精确的同步。 基于预测的同步(Prediction-based Synchronization):由于网络延迟等因素,音视频数据可能会在不同的时间到达设备。为了解决这个问题,我们可以使用各种预测算法,如卡尔曼滤波器(Kalman Filter)等,来预测未来的音视频数据,从而实现同步。 以上是一些基本的同步策略,但在实际应用中,可能需要根据具体情况进行调整和优化。例如,当网络条件不好时,可能需要动态调整预测算法的参数,或者使用更高级的同步策略,如基于机器学习的同步策略等。 4.3 音视频同步在嵌入式设备中的应用(Application of Audio-Video Synchronization in Embedded Devices)嵌入式设备,如智能电视、车载娱乐系统、无人机等,也需要进行音视频同步。由于嵌入式设备的硬件资源有限,音视频同步的策略需要考虑到资源的限制,同时也要保证同步的精度。 下面是一个简单的嵌入式设备的音视频播放流程图:

在这个流程中,音视频同步主要在播放器(Player)部分进行。以下是一些常见的同步策略: 基于时间戳的同步(Timestamp-based Synchronization):这与前面的策略类似,都是通过时间戳来控制音视频的播放。但在嵌入式设备中,由于硬件资源的限制,可能需要使用更为简洁和高效的时间戳处理算法。 基于硬件的同步(Hardware-based Synchronization):一些嵌入式设备可能会有专门的硬件模块来进行音视频同步,如专门的同步电路或者DSP(Digital Signal Processor)等。这些硬件模块可以提供更精确和稳定的同步效果。 基于操作系统的同步(OS-based Synchronization):在一些嵌入式系统中,可以利用操作系统的特性来实现音视频同步,如使用实时操作系统(RTOS)的定时器功能等。 以上是一些基本的同步策略,但在实际应用中,可能需要根据具体情况进行调整和优化。例如,当设备的硬件资源有限时,可能需要使用更为简洁和高效的同步策略,或者使用硬件加速等技术来提高同步的效果。 五、音频为基准的同步方法的编程实践(Programming Practice of Audio-Based Synchronization Methods) 5.1 音频为基准同步方法的基本原理(Basic Principles of Audio-Based Synchronization Method)在音频为基准的同步方法中,我们将音频帧的播放时间作为基准,然后根据这个基准来调整视频帧的播放时间,从而实现音视频同步。这种方法的基本原理可以用以下几个步骤来描述: 音频帧的解码和播放(Decoding and Playing of Audio Frames):首先,我们需要解码音频帧,并将其送入音频设备进行播放。在播放过程中,我们需要记录每一帧的播放时间,这个时间将作为同步的基准。 视频帧的解码(Decoding of Video Frames):与此同时,我们也需要解码视频帧。但是,与音频帧不同,视频帧在解码后并不立即播放,而是存入一个缓冲区中。 视频帧的同步和播放(Synchronization and Playing of Video Frames):当音频设备开始播放一帧音频时,我们会查找缓冲区中的视频帧,找到一个与当前音频帧最接近的视频帧,然后将其送入视频设备进行播放。这样,我们就可以保证视频帧的播放时间与音频帧的播放时间相近,从而实现音视频同步。 以上是音频为基准的同步方法的基本原理。在下一部分,我们将详细介绍如何在编程中实现这种同步方法。 5.2 音频为基准的同步方法的实现步骤(Implementation Steps of Audio-Based Synchronization Method)实现音频为基准的同步方法需要以下几个步骤: 初始化音视频设备(Initialize Audio and Video Devices):首先,我们需要初始化音视频设备,包括音频播放设备和视频显示设备。在这个过程中,我们需要设置音视频设备的参数,如采样率、帧率、分辨率等。 解码音视频帧(Decode Audio and Video Frames):然后,我们需要解码音视频帧。在FFmpeg中,我们可以使用avcodec_decode_audio4和avcodec_decode_video2函数来解码音频和视频帧。 播放音频帧(Play Audio Frames):当音频帧解码完成后,我们可以将其送入音频设备进行播放。在播放过程中,我们需要记录每一帧的播放时间,这个时间将作为同步的基准。 同步视频帧(Synchronize Video Frames):当音频设备开始播放一帧音频时,我们需要同步视频帧。具体来说,我们需要找到一个与当前音频帧最接近的视频帧,然后将其送入视频设备进行播放。在FFmpeg中,我们可以使用av_sync_point函数来判断一个视频帧是否需要同步。 处理同步误差(Handle Synchronization Errors):在实际应用中,由于网络延迟、设备性能等因素,音视频同步可能会出现误差。我们需要设计一些策略来处理这些误差,如调整视频帧的播放速度、丢弃一些音视频帧等。 音视频同步是一个复杂的主题,涉及到许多因素,包括时间戳、解码器的行为、网络延迟等等。我将尽力提供一个更详细的例子,但请注意,这是一个复杂的主题,可能需要深入研究和实践才能完全理解。 在FFmpeg中,音频和视频同步通常依赖于PTS(Presentation Time Stamp)和DTS(Decoding Time Stamp)。这些时间戳在解码过程中被用来确定每个帧应该何时被显示或播放。在理想情况下,音频和视频的PTS应该是对齐的,这样就可以在正确的时间播放每个音频和视频帧。 然而,在实际应用中,音频和视频的PTS可能会有所偏差,导致音视频不同步。这时,我们需要采取一些策略来调整音频或视频的播放速度,使它们能够同步。 以下是一个简单的同步策略: 首先,我们需要计算音频和视频的PTS差(diff)。这可以通过简单地相减得到。 然后,我们需要决定如何调整播放速度。如果diff是正的(也就是说,音频比视频快),我们可以通过减慢音频的播放速度来同步。如果diff是负的(也就是说,视频比音频快),我们可以通过加快音频的播放速度来同步。 最后,我们需要实施这个调整。在FFmpeg中,我们可以通过调整音频帧的采样率来改变播放速度。例如,如果我们想要加快播放速度,我们可以通过增加采样率来实现。如果我们想要减慢播放速度,我们可以通过减少采样率来实现。 这只是一个基本的同步策略,实际的同步过程可能会更复杂。例如,我们可能需要考虑网络延迟、解码器的行为、以及其他可能影响同步的因素。此外,我们可能需要实施更复杂的同步策略,例如使用PID控制器来动态调整播放速度。 一个基本的C++代码示例,它展示了如何计算PTS差异,并根据这个差异调整音频帧的采样率。请注意,这只是一个简单的示例,实际的同步过程可能会更复杂,并且可能需要考虑其他因素。 #include #include // 假设我们有一个音频帧和一个视频帧 double audioPTS; double videoPTS; // 假设我们有一个函数来获取音频帧的采样率 double getSampleRate(); // 假设我们有一个函数来设置音频帧的采样率 void setSampleRate(double rate); int main() { // 计算PTS差 double diff = audioPTS - videoPTS; // 获取当前的采样率 double currentSampleRate = getSampleRate(); // 根据PTS差调整采样率 if (diff > 0) { // 音频比视频快,减慢播放速度 setSampleRate(currentSampleRate * (1 - std::abs(diff))); } else if (diff // 计算PTS差 double error = audioPTS - videoPTS; // 计算积分项 integral += error; // 计算微分项 double derivative = error - prev_error; // 计算PID控制器的输出 double output = Kp * error + Ki * integral + Kd * derivative; // 获取当前的采样率 double currentSampleRate = getSampleRate(); // 根据PID控制器的输出调整采样率 setSampleRate(currentSampleRate * (1 + output)); // 更新上一次的误差 prev_error = error; return 0; }这个代码示例假设getSampleRate和setSampleRate函数已经存在,并且可以用来获取和设置音频帧的采样率。在实际的应用中,你可能需要使用FFmpeg的API来实现这些功能。 此外,这个示例使用了一个简单的PID控制器来调整采样率。在实际的应用中,你可能需要根据具体的情况来调整PID控制器的参数(Kp、Ki和Kd)。 最后,请注意这个示例没有考虑到其他可能影响同步的因素,例如网络延迟和解码器的行为。在实际的应用中,你可能需要考虑这些因素。 5.4 对比 方法精度复杂性响应性稳定性灵活性PID控制高高高高高调整采样率中中中中中添加延迟低低低低低精度:PID控制器可以提供高精度的同步,因为它可以动态调整播放速度以减小PTS的误差。直接调整采样率的精度较低,因为它只能在一开始就设定好播放速度。添加延迟的精度最低,因为它只能在一开始就设定好延迟时间。 复杂性:PID控制器的实现相对复杂,需要调整PID控制器的参数并实时计算误差、积分和微分。直接调整采样率的实现较简单,只需要计算PTS的差并根据差值调整采样率。添加延迟的实现最简单,只需要在一开始就设定好延迟时间。 响应性:PID控制器的响应性最高,因为它可以实时调整播放速度以应对PTS的变化。直接调整采样率的响应性较低,因为它只能在一开始就设定好播放速度。添加延迟的响应性最低,因为它只能在一开始就设定好延迟时间。 稳定性:PID控制器的稳定性最高,因为它可以通过微分控制来提高系统的稳定性。直接调整采样率的稳定性较低,因为它可能会因为PTS的突然变化而导致播放速度的突然变化。添加延迟的稳定性最低,因为它无法应对PTS的变化。 灵活性:PID控制器的灵活性最高,因为它可以根据实际情况调整PID控制器的参数。直接调整采样率的灵活性较低,因为它只能在一开始就设定好播放速度。添加延迟的灵活性最低,因为它只能在一开始就设定好延迟时间。 六、疑问解答 6.1 怎么保证丢弃的帧用户觉察不到?音视频同步技术已经非常成熟,大多数情况下,你在观看视频时,可能并不会察觉到丢帧的情况。这是因为音视频播放器会使用一系列复杂的策略来保持音视频同步,而且这些策略通常会尽量避免对用户体验产生明显的影响。 以下是一些可能的策略: 调整播放速度:播放器可以稍微调整音频或视频的播放速度,使其与另一方同步。这种调整通常非常微小,以至于用户几乎无法察觉。 插入或删除帧:在某些情况下,播放器可能会选择丢弃一些帧,或者插入一些额外的帧,以保持同步。这种策略通常会在用户无法察觉的情况下进行。 使用缓冲区:播放器通常会使用一个缓冲区来存储即将播放的音视频数据。通过控制缓冲区中的数据播放速度,播放器可以有效地处理网络延迟等问题,保持音视频同步。 使用时间戳:音视频数据在编码时,通常会附带一个时间戳,表示该帧应该在什么时候播放。播放器可以使用这些时间戳来保持音视频同步。 总的来说,虽然丢帧是一种可能的同步策略,但在实际的应用中,播放器通常会使用更复杂的策略,以保持音视频同步,同时尽量避免对用户体验产生影响。 6.2 音频缓冲区和音频设备缓冲区会冲突么?音频设备内部确实有一个缓冲区,这个缓冲区主要用于存储即将播放的音频数据。当我们将音频数据发送给音频设备时,音频设备会将这些数据存储在其内部的缓冲区中,然后按照一定的速度从缓冲区中取出数据进行播放。 然而,这并不意味着我们不能在音频设备之外再设置一个缓冲区。实际上,音频设备的内部缓冲区和我们设置的外部缓冲区是两个不同的概念,它们各自承担不同的任务。 音频设备的内部缓冲区主要用于保证音频的连续播放,避免因为数据传输延迟而导致的播放中断。而我们设置的外部缓冲区则主要用于控制音频的播放速度,以实现音视频同步。 在音视频同步的过程中,我们可以通过控制外部缓冲区中的数据量,以及数据送入音频设备的速度,来调整音频的播放速度。这种方法并不会与音频设备的内部缓冲区产生冲突,因为这两个缓冲区各自承担不同的任务,而且它们之间的数据传输是有序的:我们首先将数据从外部缓冲区送入音频设备,然后音频设备再从其内部缓冲区中取出数据进行播放。 6.3 删除帧可以理解,插入额外帧指哪些帧?插入额外的帧通常是指在视频流中添加一些新的帧,以保持音视频同步。这些额外的帧可以是重复的帧,也可以是通过插值生成的新的帧。 重复帧:这是最简单的方法,就是将前一帧或后一帧复制一份作为新的帧。这种方法的优点是实现简单,但缺点是可能会导致视频的播放不流畅,因为用户可能会察觉到帧的重复。 插值帧:这是一种更复杂的方法,需要使用一些算法(例如,运动插值算法)来生成新的帧。插值帧是根据前后两帧的内容计算出来的,它代表了前后两帧之间的一个过渡状态。这种方法的优点是可以生成更自然、更流畅的视频,但缺点是实现复杂,计算量大。 在实际的应用中,选择哪种方法主要取决于具体的需求和条件。例如,如果对视频的播放流畅性要求很高,那么可能会选择使用插值帧;反之,如果对实现复杂度和计算量有限制,那么可能会选择使用重复帧。 6.4 调整帧率具体怎么做,是调整解码器帧率?调整帧率是另一种常见的音视频同步策略。帧率,也就是每秒钟显示的帧数,是衡量视频流畅度的重要指标。在音视频同步的过程中,我们可以通过调整音频或视频的帧率来达到同步的目的。 例如,假设我们有一个音频流和一个视频流,它们的播放速度不同步。如果视频的帧率比音频的帧率高,那么视频会比音频播放得更快,导致不同步。在这种情况下,我们可以通过减小视频的帧率(也就是减少每秒钟显示的帧数)来降低视频的播放速度,从而使视频与音频同步。 同样,如果音频的播放速度比视频快,我们可以通过增加视频的帧率来提高视频的播放速度,从而使视频与音频同步。 需要注意的是,调整帧率并不一定意味着改变解码器的解码帧率。解码器的解码帧率通常是固定的,由视频的编码格式决定。调整帧率通常是通过丢弃一些帧或插入一些额外的帧来实现的,这不会改变解码器的解码帧率,但会改变最终显示给用户的帧率。 6.5 如何判断用户无法觉察的时间区间?用户对于视频流畅性的感知能力会受到多种因素的影响,包括视频的内容、用户的注意力、用户的视觉敏感度等。因此,很难给出一个精确的区间来描述用户能够察觉到的帧插入或删除的数量。然而,我们可以根据一些常见的视觉感知原理,给出一些大致的指导。 视觉暂留效应:人眼有一种视觉暂留效应,即在一瞬间看到的图像会在短时间内保留在视网膜上。这个时间通常在100-200毫秒之间。因此,如果在这个时间内插入或删除一帧,用户可能不会察觉到。 帧率和视觉流畅性:人眼对于帧率的感知能力有一定的限制。一般来说,当帧率超过24帧/秒时,人眼就会感觉到视频是连续的,而不是由一帧帧单独的图像组成。因此,如果在一秒钟内插入或删除少于24帧,用户可能不会察觉到。 内容和注意力:用户对于视频的注意力和视频的内容也会影响他们的感知能力。例如,如果视频的内容变化很快,或者用户的注意力分散,那么他们可能不会察觉到少量的帧插入或删除。 总的来说,如果你想要在用户无法察觉的情况下插入或删除帧,你应该尽量保持插入或删除的帧数较少(例如,每秒钟不超过24帧),并且尽量在用户的视觉暂留效应的时间内(例如,100-200毫秒)进行操作。然而,这只是一个大致的指导,具体的效果可能会因为多种因素而有所不同。 6.6 缓冲区的数据结构选择?在音视频处理中,缓冲区通常使用的数据结构是队列或环形缓冲区。这是因为音视频数据的处理通常需要满足先入先出(FIFO)的原则,即先解码的数据先播放,后解码的数据后播放,这与队列和环形缓冲区的特性相符。 队列:队列是一种先入先出(FIFO)的数据结构,适合用于存储需要按照特定顺序处理的数据。在音视频处理中,我们可以将解码后的音视频帧存入队列,然后按照顺序从队列中取出帧进行播放。 环形缓冲区:环形缓冲区是一种特殊的队列,它的头尾是相连的,形成一个环形。环形缓冲区的优点是可以有效地利用存储空间,当缓冲区满时,新的数据可以覆盖旧的数据。在音视频处理中,如果我们希望在缓冲区满时能够继续存储新的音视频帧,而且不关心被覆盖的旧帧,那么可以使用环形缓冲区。 链表、数组和二叉树等其他数据结构在音视频处理的缓冲区中使用较少。链表和数组在插入和删除数据时的效率较低,而二叉树则更适合用于需要进行快速查找和排序的场景,而不是音视频处理这种需要按照特定顺序处理数据的场景。 6.7 音视频两者处理速度是不一致的,怎么调整同步?音频和视频的处理速度确实可能不同,这是因为音频和视频的解码、渲染和播放过程可能需要不同的时间。为了保证音视频同步,你需要在播放每一帧时检查音频和视频的同步状态,并根据需要进行调整。 以下是一些可能的方法: 使用系统时钟:你可以使用一个系统时钟来同步音频和视频。系统时钟是一个单调递增的时钟,它表示从播放开始到现在的时间。在播放每一帧时,你可以将这一帧的PTS(Presentation Time Stamp)和系统时钟进行比较,如果PTS比系统时钟快,那么你可以延迟播放这一帧,如果PTS比系统时钟慢,那么你可以尽快播放这一帧。 调整播放速度:如果音频和视频的处理速度有较大的差距,你可能需要调整播放速度。例如,如果视频处理速度比音频快,你可以减慢视频的播放速度,或者加快音频的播放速度。 使用缓冲区:你可以使用缓冲区来存储解码后的音频和视频帧。在播放每一帧时,你可以检查音频和视频缓冲区的状态,如果一个缓冲区为空,那么你可以等待,直到这个缓冲区有数据可供播放。 使用同步机制:在多线程环境中,你可以使用同步机制(如互斥锁、条件变量等)来同步音频和视频的播放。例如,你可以使用一个条件变量来等待音频和视频都处理完毕,然后再播放下一帧。 请注意,这些只是一些基本的方法,实际的音视频同步可能需要考虑更多的因素,例如网络延迟、解码速度、播放速度等。你可能需要根据你的实际需求和环境来选择合适的方法。 6.8 音视频两者样本数是不一样的,怎么进行同步?你是对的,音频和视频的样本数(或帧数)通常是不一样的。视频通常以固定的帧率(如24帧/秒或30帧/秒)播放,而音频的样本率通常远高于视频的帧率(如44100样本/秒或48000样本/秒)。这意味着在同一秒内,音频的样本数通常远多于视频的帧数。 然而,尽管音频和视频的样本数不一样,但是它们的时间戳(PTS,Presentation Time Stamp)应该是一致的,至少在理想情况下是这样。PTS表示的是这个样本或帧应该在什么时候被播放,而不是这个样本或帧是第几个样本或帧。因此,即使音频的样本数多于视频的帧数,但是它们的PTS应该是一致的。 例如,假设我们有一个视频帧,它的PTS是1.0秒,这意味着这个视频帧应该在播放开始后的1.0秒被显示。同时,我们也有一些音频样本,它们的PTS也是1.0秒,这意味着这些音频样本应该在播放开始后的1.0秒被播放。尽管音频样本的数量可能远多于视频帧的数量,但是它们的PTS是一致的。 在实际的音视频同步中,你需要确保音频和视频的PTS一致,或者至少在一个可接受的范围内。如果音频和视频的PTS有较大的差距,那么你可能需要进行一些调整,例如调整播放速度,或者延迟其中一个流的播放,以使它们的PTS一致。 6.9 是否一般以秒为单位计算同步区间?是的,通常情况下,音频和视频的时间戳(PTS,Presentation Time Stamp)都是以秒为单位的。这意味着,如果你有一个时间戳为1.0的帧,那么这个帧应该在播放开始后的1.0秒被播放。 在播放音频和视频时,你需要根据当前的系统时间和每一帧的PTS来决定何时播放这一帧。例如,如果当前的系统时间是1.0秒,那么你应该播放所有PTS小于或等于1.0秒的帧。 如果你的音频和视频流是连续的,那么你可以简单地在每一秒的开始时,播放所有PTS在这一秒内的帧。例如,在1.0秒的开始时,你可以播放所有PTS在1.0到2.0之间的帧。 然而,如果你的音频和视频流有间隔,或者你需要处理音视频不同步的问题,那么你可能需要更精细的控制。你可能需要在每一帧的PTS到来时,立即播放这一帧,而不是等到下一秒的开始。你也可能需要根据音视频的同步状态,调整播放速度,或者延迟其中一个流的播放。 总的来说,你需要根据你的实际需求和环境,以及音视频的同步状态,来决定何时播放每一帧。 |

【本文地址】

![[外链图片转存失败,源站可能有防盗链机制,建议将图片保存下来直接上传(img-tiPfeQ3X-1686067148673)(null)]](https://img-blog.csdnimg.cn/3a2ef8a7481d428194d1199042efb0d5.png)