| Docker + Hadoop搭建伪集群 | 您所在的位置:网站首页 › docker配置hadoop集群 › Docker + Hadoop搭建伪集群 |

Docker + Hadoop搭建伪集群

|

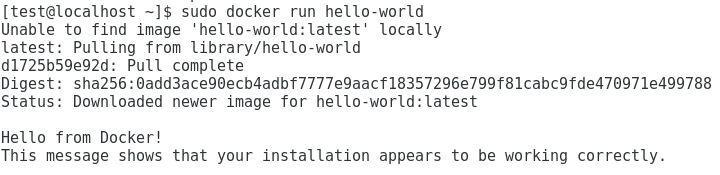

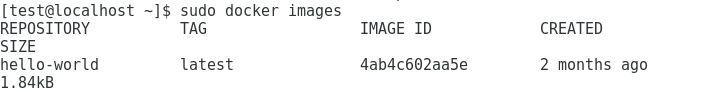

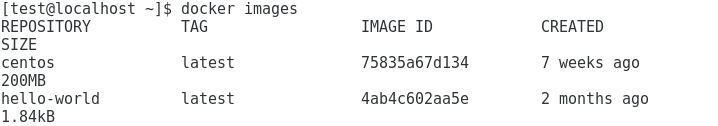

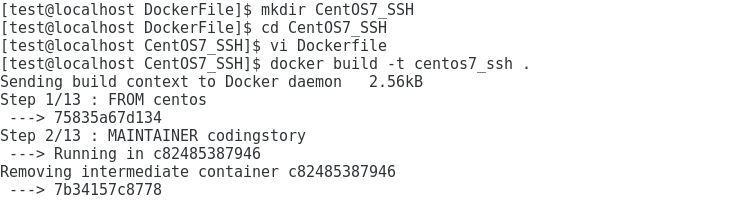

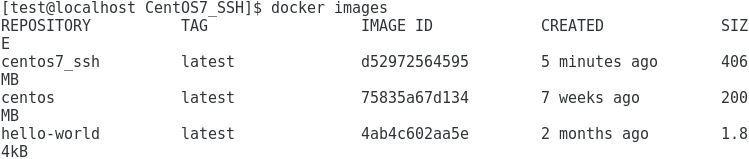

目的: 利用docker容器构建3台虚拟主机,一台为管理节点两台为数据节点以此来构建hadoop伪集群,三台虚拟主机之间使用SSH进行连接 因此整体思路为安装Centos镜像,为镜像安装SSH,Hadoop,Java,根据镜像创建三个容器,这样每个容器其实就相当于一台运行着Centos的主机,选择一个为管理节点配置Hadoop 文章很长,请耐心阅读 操作系统Centos7,安装时最好选择安装GNOME桌面 下载Docker CE1 删除旧版本 $ sudo yum remove docker \ docker-client \ docker-client-latest \ docker-common \ docker-latest \ docker-latest-logrotate \ docker-logrotate \ docker-selinux \ docker-engine-selinux \ docker-engine配置Docker仓库 $ sudo yum install -y yum-utils \ device-mapper-persistent-data \ lvm2 $ sudo yum-config-manager \ --add-repo \ https://download.docker.com/linux/centos/docker-ce.repo安装Docker CE $ sudo yum install docker-ce启动Docker CE $ sudo systemctl enable docker $ sudo systemctl start docker为Docker创建新的工作组 $ sudo usermod -aG docker $USER切换至root用户 $ ru test测试Docker是否正常工作 $ docker run hello-world拉取Centos镜像 $ docker pull centos $ docker images拉取的镜像 Dockerfile FROM centos MAINTAINER codingstory #安装SSH RUN yum install -y openssh-server sudo RUN sed -i 's/UsePAM yes/UsePAM no/g' /etc/ssh/sshd_config RUN yum install -y openssh-clients #添加用户名为hadoop用户密码为hadoop的用户 RUN useradd hadoop RUN echo "hadoop:hadoop" | chpasswd #提升hadoop用户的权限 RUN echo "hadoop ALL=(ALL) ALL" >> /etc/sudoers RUN ssh-keygen -t dsa -f /etc/ssh/ssh_host_dsa_key RUN ssh-keygen -t rsa -f /etc/ssh/ssh_host_rsa_key #开启SSH服务端口为22 RUN mkdir /var/run/sshd EXPOSE 22 CMD ["/usr/sbin/sshd", "-D"]安装 $ docker build -t centos7_ssh .安装过程中会出现红色警报可以不用管

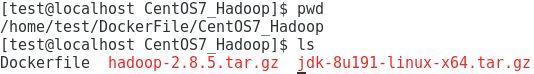

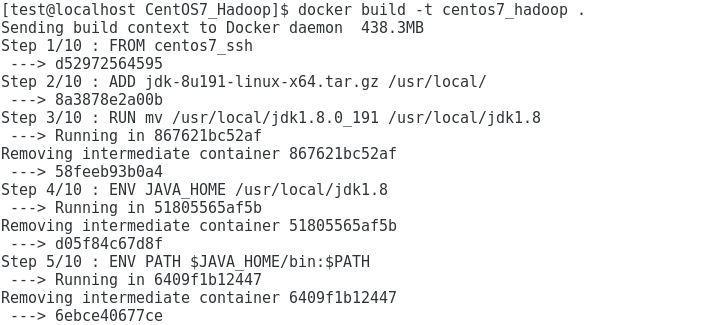

SSH连接测试成功后,要为镜像安装Hadoop和Java 进入到DockerFile文件夹中建立一个新的文件夹 $ mkdir CentOS7_Hadoop $ cd CentOS7_Hadoop $ vi DockerfileDockerfile FROM centos7_ssh #解压下载的java文件 ADD jdk-8u191-linux-x64.tar.gz /usr/local/ # 更改文件夹名字 RUN mv /usr/local/jdk1.8.0_191 /usr/local/jdk1.8 ENV JAVA_HOME /usr/local/jdk1.8 ENV PATH $JAVA_HOME/bin:$PATH # 解压下载的Hadoop文件 ADD hadoop-2.8.5.tar.gz /usr/local RUN mv /usr/local/hadoop-2.8.5 /usr/local/hadoop ENV HADOOP_HOME /usr/local/hadoop ENV PATH $HADOOP_HOME/bin:$PATH RUN yum install -y which sudo进入Hadoop官网下载hadoop-2.8.5.tar.gz的二进制文件 进入Java官网下载[Linux x64 jdk-8u191-linux-x64.tar.gz ](https://www.oracle.com/technetwork/java/javase/downloads/jdk8-downloads-2133151.html) 把下载的文件放入DockerFile/CentOS7_Hadoop目录下

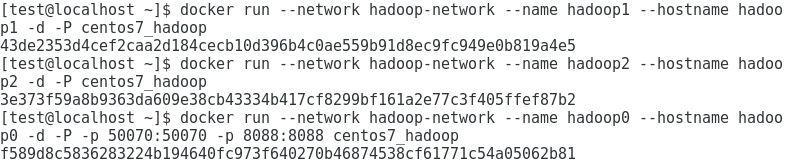

对于hadoop0来说,我们希望它能作为管理员,因此把它的端口50070和8088映射到我们自己的主机中

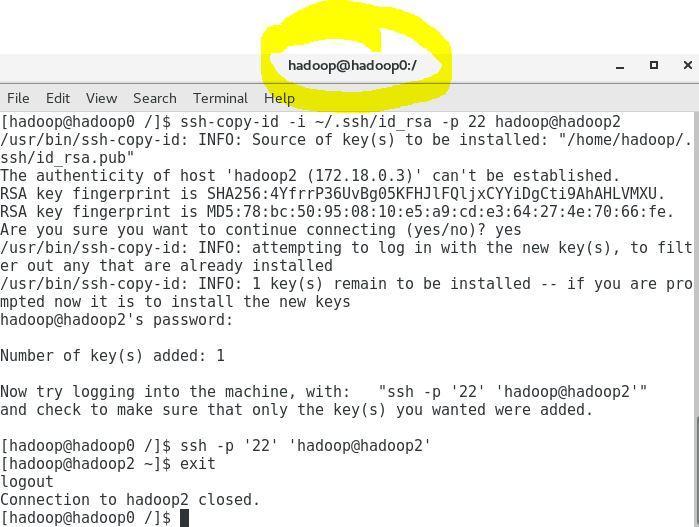

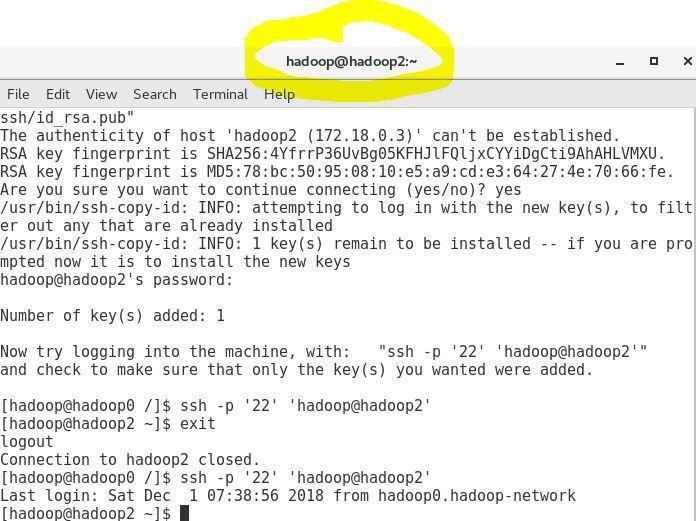

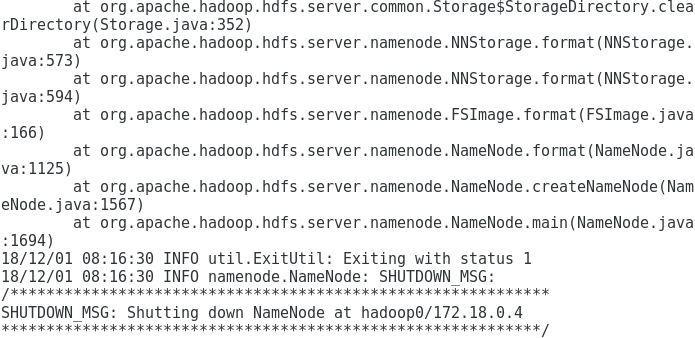

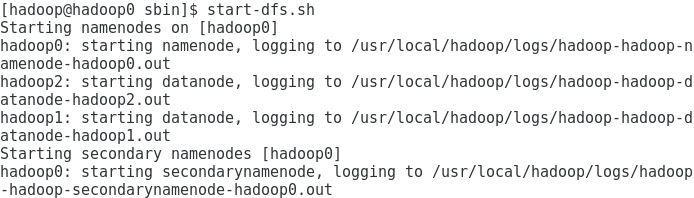

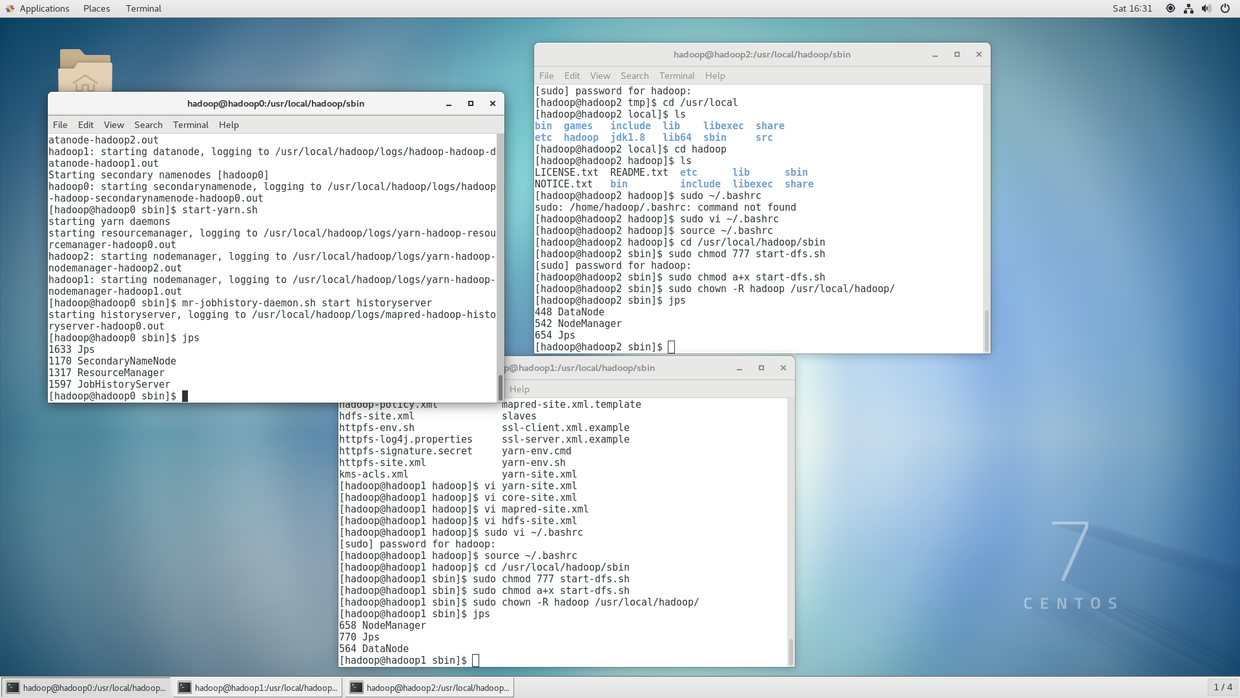

都生成用于SSH连接的公钥和私钥 $ ssh-keygen都将自己的公钥复制给其它容器 $ ssh-copy-id -i ~/.ssh/id_rsa -p 22 hadoop@hadoop0 $ ssh-copy-id -i ~/.ssh/id_rsa -p 22 hadoop@hadoop1 $ ssh-copy-id -i ~/.ssh/id_rsa -p 22 hadoop@hadoop2这样我们就可以不需要密码就可以访问其它容器,假设我们现在处于hadoop0容器 我们可以使用 $ ssh -p '22' 'hadoop@hadoop2'访问hadoop2容器 访问之前 将下面的代码configuration部分复制到core-site.xml文件中的configuration部分 fs.default.name hdfs://hadoop0:9000 io.file.buffer.size 131072 hadoop.tmp.dir file:/home/${user.name}/tmp A base for other temporary directories. hadoop.proxyuser.hduser.hosts * hadoop.proxyuser.hduser.groups * fs.trash.interval 1440 $ sudo vi /usr/local/hadoop/etc/hadoop/hdfs-site.xml将下面的代码configuration部分复制到hdfs-site.xml文件中的configuration部分 dfs.namenode.name.dir file:/usr/local/hadoop/hdfs/name dfs.datanode.data.dir file:/usr/local/hadoop/hdfs/data dfs.replication 2 dfs.namenode.secondary.http-address hadoop0:9001 dfs.webhdfs.enabled true切入到hadoop目录下 $ cd /usr/local/hadoop/etc/hadoop $ sudo cp mapred-site.xml.template mapred-site.xml将下面的代码configuration部分复制到mapred-site.xml文件中的configuration部分 mapreduce.framework.name yarn mapreduce.jobhistory.address hadoop0:10020 mapreduce.jobhistory.webapp.address hadoop0:19888 $ sudo vi yarn-site.xml将下面的代码configuration部分复制到yarn-site.xml文件中的configuration部分 yarn.nodemanager.aux-services mapreduce_shuffle yarn.nodemanager.auxservices.mapreduce.shuffle.class org.apache.hadoop.mapred.ShuffleHandler yarn.resourcemanager.address hadoop0:8032 yarn.resourcemanager.scheduler.address hadoop0:8030 yarn.resourcemanager.resource-tracker.address hadoop0:8031 yarn.resourcemanager.admin.address hadoop0:8033 yarn.resourcemanager.webapp.address hadoop0:8088 $ sudo vi slaves删除原来的内容加入 hadoop1 hadoop2查看JAVA_HOME路径 $ echo $JAVA_HOME $ sudo vi hadoop-env.sh找到 export JAVA_HOME=${JAVA_HOME}将其更改为JAVA_HOME路径,例如 export JAVA_HOME=/usr/local/jdk1.8现在将修改过后的hadoop文件发送给hadoop1和hadoop2容器2 $ sudo scp -r /usr/local/hadoop hadoop@hadoop1:/tmp $ sudo scp -r /usr/local/hadoop hadoop@hadoop1:/tmp进入hadoop1和hadoop2删除原来的hadoop文件 $ rm -rf /usr/local/hadoop从/tmp文件夹将hadoop复制到/usr/local/hadoop里面 $ sudo cp -rf /tmp/hadoop /usr/local/hadoop三个容器中都要增加Hadoop环境变量 $ sudo vi ~/.bashrc增加环境变量 export PATH=$PATH:/usr/local/hadoop/bin:/usr/local/hadoop/sbin执行以下命令,使刚添加的环境变量有效 $ source ~/.bashrc这样配置就完成了 下面开始启动Hadoop 进入hadoop0容器 $ hdfs namenode -format -force会出现下面这样的结果 之后在hadoop0容器中运行 $ start-dfs.sh检查启动状态 $ hadoop dfsadmin -report

如果有什么疑问,可以在评论区指出,欢迎探讨! 本文刚开始发布于简书-Docker+Hadoop构建伪集群 Docker在Centos上安装–官方文档 ↩︎ ssh使用scp: /目录: Permission denied ↩︎ “Permission denied” errors whe starting a single node cluster in Hadoop ↩︎ |

【本文地址】

为拉取的镜像安装SSH

为拉取的镜像安装SSH

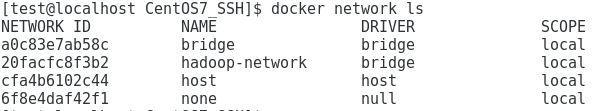

构建网络环境

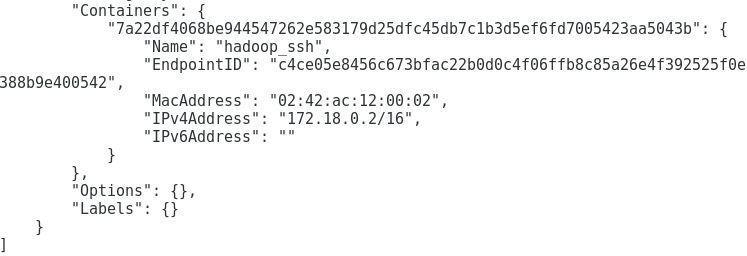

构建网络环境 测试SSH功能 建立一个容器(此时的容器已经有操作系统和网路了相当于一台虚拟主机了)

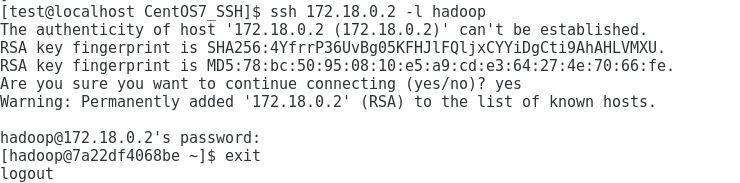

测试SSH功能 建立一个容器(此时的容器已经有操作系统和网路了相当于一台虚拟主机了) 测试SSH连接

测试SSH连接 解释一下命令的含义172.18.0.2代表了我们刚刚创建的容器(虚拟主机)的IP地址,hadoop代表了我们要连接到容器(虚拟主机)中名为hadoop的用户

解释一下命令的含义172.18.0.2代表了我们刚刚创建的容器(虚拟主机)的IP地址,hadoop代表了我们要连接到容器(虚拟主机)中名为hadoop的用户 执行Dockerfile

执行Dockerfile

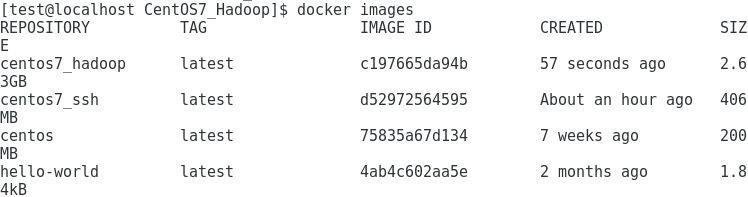

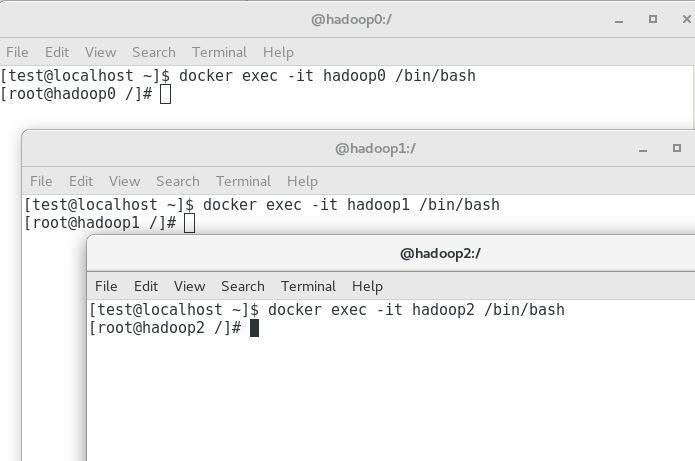

现在我们的镜像已经安装了SSH、Hadoop、Java 再根据镜像创建三个容器

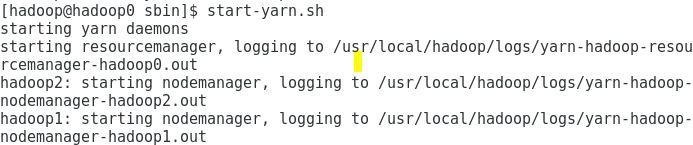

现在我们的镜像已经安装了SSH、Hadoop、Java 再根据镜像创建三个容器 打开三个命令行分别进入三个容器

打开三个命令行分别进入三个容器 在三个命令行中全部切换为hadoop用户

在三个命令行中全部切换为hadoop用户 访问之后

访问之后  下面进行Hadoop的配置 进入hadoop0容器

下面进行Hadoop的配置 进入hadoop0容器 三个容器中都要提升hadoop对hadoop文件夹权限3:

三个容器中都要提升hadoop对hadoop文件夹权限3:

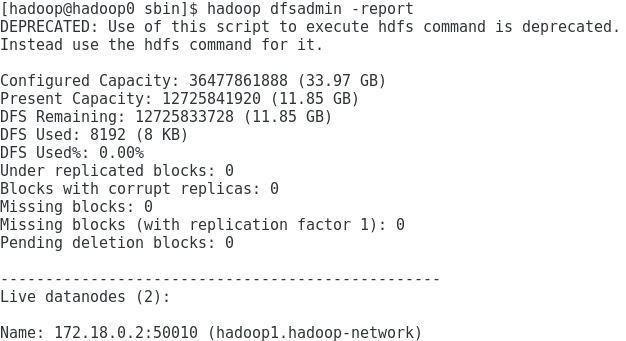

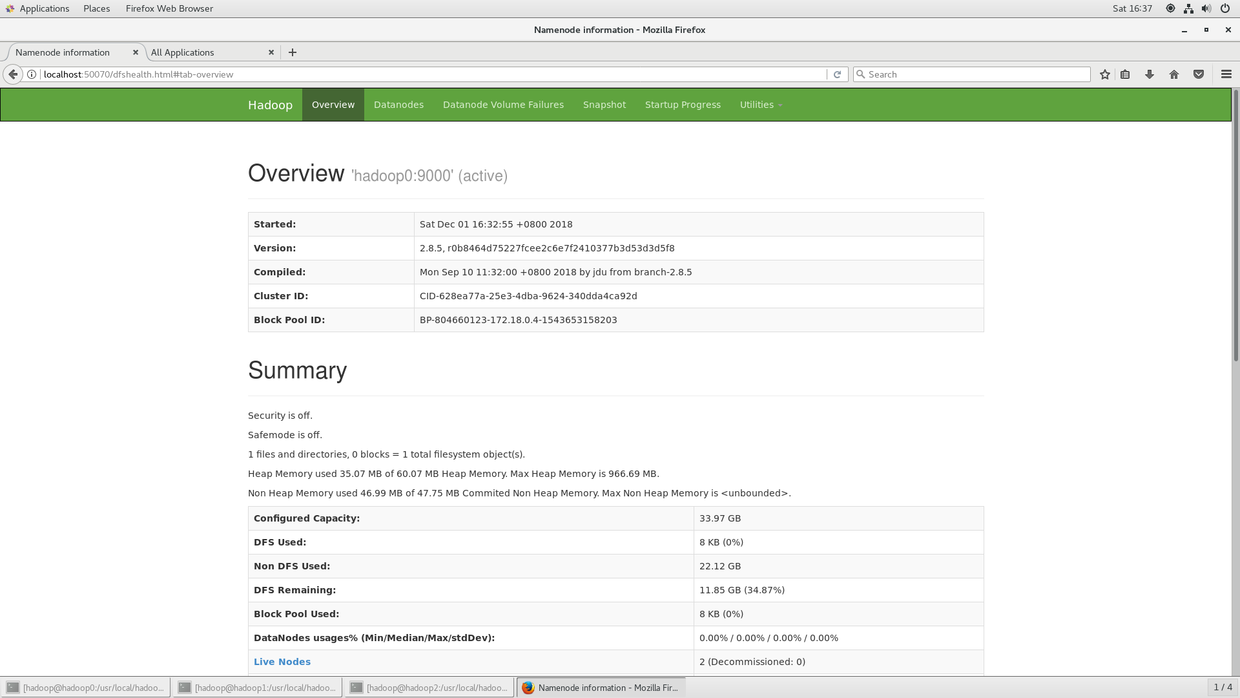

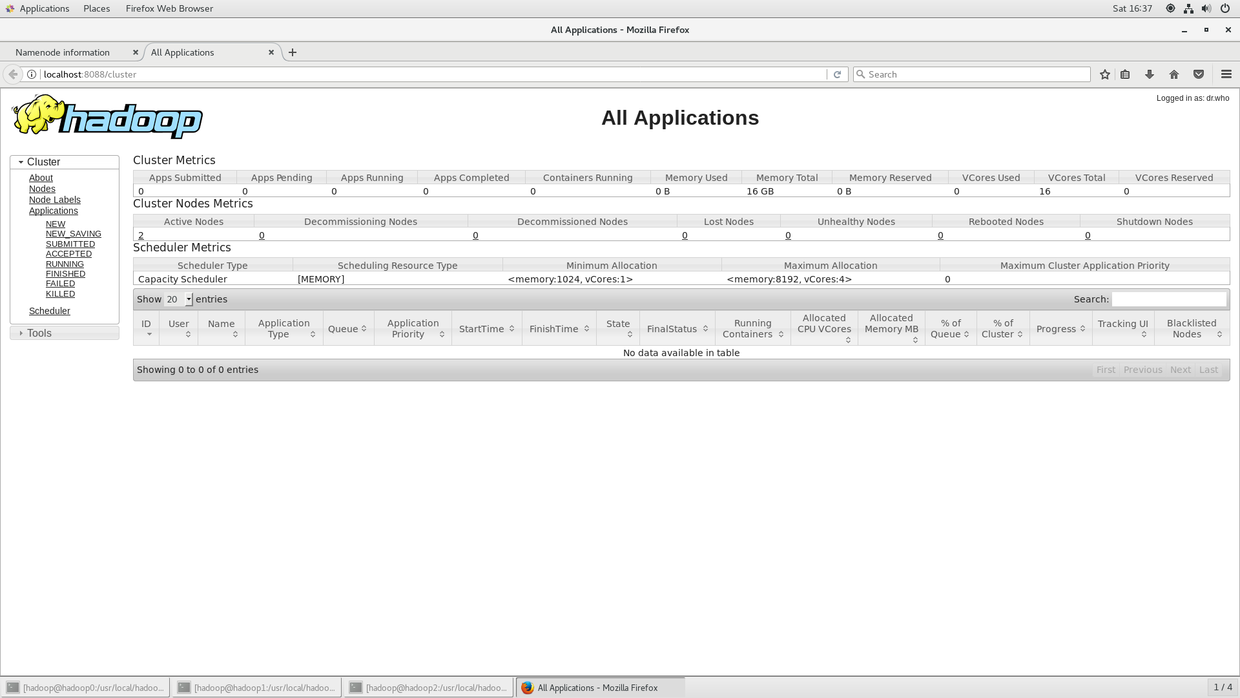

打开http://localhost:50070和http://localhost:8088查看是否正确

打开http://localhost:50070和http://localhost:8088查看是否正确

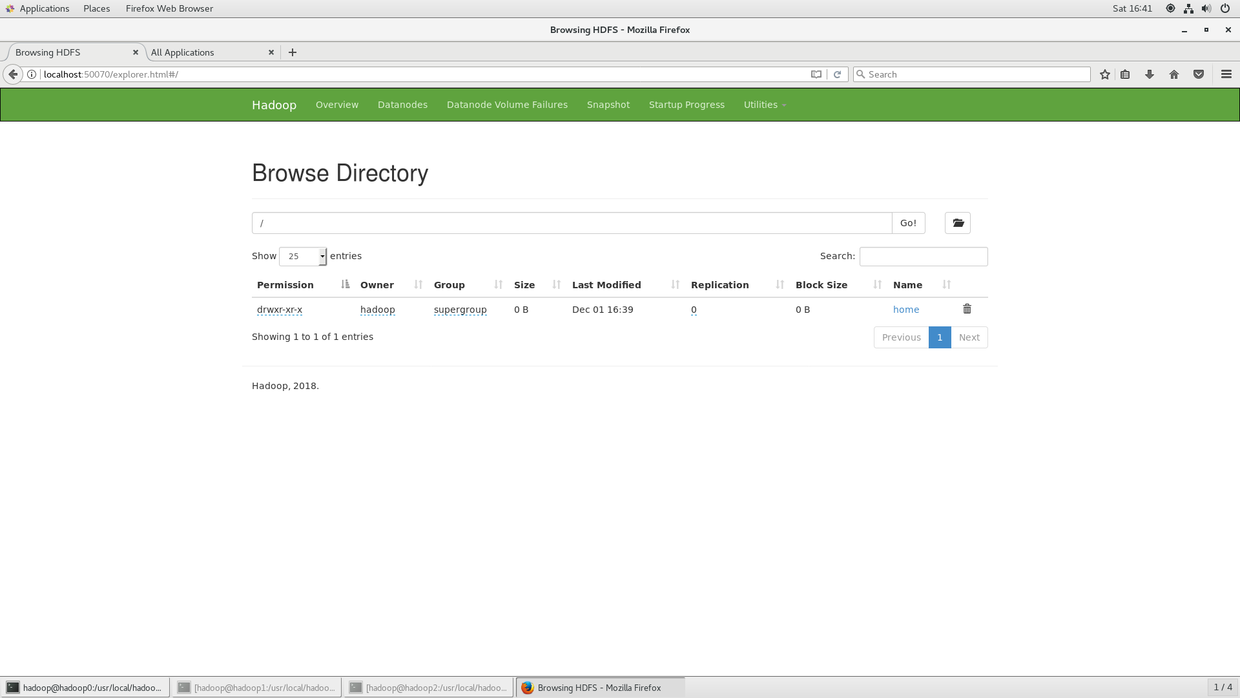

创建一个文件试试

创建一个文件试试 至此就完成了Docker+Hadoop构建的伪集群

至此就完成了Docker+Hadoop构建的伪集群