| 论文阅读笔记 | 您所在的位置:网站首页 › dac医学表示什么 › 论文阅读笔记 |

论文阅读笔记

|

CE-Net: Context Encoder Network for 2D Medical Image Segmentation--CE-Net:用于二维医学图像分割的上下文编码网络

摘要一、introduce早期医学图像深度学习方法早期U-Net网络的应用对U-Net网络的改进U-Net以及改进U-Net网络的限制【编码器-解码器】基于上述讨论,本论文提出了:论文主要贡献:

二、Method网络架构A.特性编码器模块B.上下文提取器模块1) Atrous Convolution:2) Dense Atrous Convolution Module:3) Residual Multi-Kernel Pooling:

C.特征解码器模块

三,Experiment实验分割结果Ablation Study(消融研究)1)采用预训练ResNet模型的消融研究:2)密集Atrous卷积块的消融研究:3)残差多核池模块的消融研究:4)相似复杂度网络的消融研究:

四,总结

Medical Image Segmentation–CE-Net:用于二维医学图像分割的上下文编码网络)

摘要

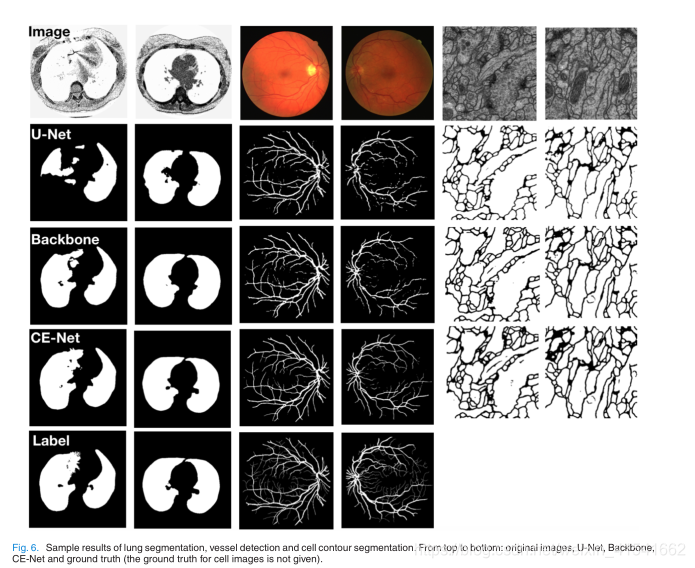

提示:这里可以添加本文要记录的大概内容: 基于U-net的方法已经被提出。但是,连续池化和跨越式卷积操作导致了部分空间信息的丢失。本文提出了一种上下文编码网络(CE-Net),用于二维医学图像分割中获取更多的高层次信息和保留空间信息。 CE-Net主要包含三个主要组件:特征编码模块、上下文提取模块和特征解码器模块。我们使用预先训练的ResNet块作为固定的特征提取器。由新提出的密集atrous卷积块和残馀多核池块形成的上下文。我们将所提出的ce - net应用于不同的二维医学图像分割任务。综合结果表明,该方法在光学椎间盘分割、血管检测、肺检测,细胞轮廓分割,视网膜光学相干层析成像层析。等方面均优于原始U-Net方法 一、introduce基于深度学习的分割方法是基于像素分类的学习方法。与传统的像素或超像素分类方法经常使用手工制作的特征不同,深度学习方法是对特征进行学习,克服手工制作特征的局限性。 早期医学图像深度学习方法早期的医学图像分割深度学习方法大多基于图像补丁。Ciresan等人[39]提出了基于patch和滑动窗口策略来分割显微镜图像中的神经元膜。然后,Kamnitsas等人在[40]中采用了一种具有完全连通条件随机场(CRF)的多尺度三维CNN架构来增强基于patch的脑损伤分割。显然,该解决方案存在两个主要缺陷:滑动窗口造成的冗余计算和无法学习全局特征。 早期U-Net网络的应用随着端到端全卷积网络[41]的出现,Ronneberger等人提出了用于生物医学图像分割的U-shape Net (U-Net)框架。U-Net在电子显微镜记录的神经元结构分割和光镜图像的细胞分割方面取得了良好的成果。它已经成为生物医学图像分割的一种流行的神经网络结构。Sevastopolsky[43]应用U-Net直接分割视网膜眼底图像视盘和视杯,用于青光眼诊断。Roy等人在光学相干断层扫描(OCT)图像中使用了类似的网络来分割视网膜层。Norman等人利用U-Net从膝关节MRI数据中分割软骨和半月板。U-Net还可以用于从CT图像[45]中直接分割肺部。 对U-Net网络的改进针对不同的医学图像分割任务,在U-Net上进行了许多变化。Fu等[4]采用CRF收集多阶段特征图,提高船舶检测性能。随后,提出了一种改进的U-Net框架(称为M-Net)[2],通过在U-Net架构中加入多尺度输入和深度监控,实现了视盘和视杯的联合分割。深度监督主要引入与中期特征相关的额外损失函数。在深度监控的基础上,Chen等人[46]提出了一种V oxresnet来分割容积脑,Dou等人[47]提出了3D deep supervised network (3D DSN)来自动分割CT容积中的肺。 为了提高U-Net的特征学习能力,提出了一些新的模块来替代原有的模块。Apostolopoulos等人[48]提出了分支残差u -net (branch residual u -net)来分割病理OCT视网膜层,用于年龄相关性黄斑变性诊断。BRUnet依赖于残余连接和扩张的卷积来增强最终的OCT视网膜层分割。Gibson等人在[49]中引入每个编码块的密集连接,自动分割腹部CT上的多个器官。Kumar等人[21]提出了一种用于婴儿大脑MRI分割的InfiNet。除了上述基于U-Net的医学图像分割的研究成果外,一些研究者也在改进U-Net用于一般图像分割方面取得了进展。Peng等人提出了一种新的全局卷积网络来改进语义分割。Lin等[51]提出了一种包含残差卷积单元、多分辨率融合和链式残差池的多径细化网络。Zhao等[52]采用空间金字塔池法收集提取的特征图,提高了语义分割性能。 U-Net以及改进U-Net网络的限制【编码器-解码器】U-Net及其变体的一个常见限制是,连续的池化操作或卷积跨步降低了特征分辨率,以学习越来越抽象的特征表示。虽然这种不变性有利于分类或目标检测任务,它经常阻碍密集的预测任务需要详细的空间信息。 从直观上看,将高分辨率地形图保持在中间阶段可以提高分割性能。但是,它增加了feature map的大小,这并不是最优的,从而加快了训练速度,降低了优化的难度。因此,在加速训练和保持高分辨率之间存在一个权衡。 一般来说,U-Net结构可以被认为是编码器-解码器结构。该编码器的目标是逐步降低特征映射的空间维数,捕捉更多的高级语义特征。解码器的目的是恢复对象的细节和空间维度。 因此,为了提高图像分割的性能,可以自发地在 编码器中捕获更多的高级特征,在解码器中保留更多的空间信息。 基于上述讨论,本论文提出了:基于上述讨论,以及使神经网络更广泛、更深入的InceptionResNet结构[53]和[54],我们提出了一种新的密集atrous卷积(DAC)块来使用atrous卷积。原始的U-Net架构通过在编码路径中采用连续的3×3卷积和池化操作来捕获有限尺度范围内的多尺度特征。我们提出的DAC块可以通过注入4个级联分支的多尺度atrous卷积来捕获更广泛和更深的语义特征。在该模块中,利用剩余连接来防止梯度消失。此外,我们还提出了一种基于空间金字塔池化的残差多核池化(RMP) 。 **RMP**块通过使用不同大小的池化操作,进一步编码从DAC模块中提取的对象的多尺度上下文特征,而不需要额外的学习权重。综上所述,我们提出了DAC块,通过多尺度atrous卷积来提取丰富的特征表示,然后使用RMP块,通过多尺度池化操作来进一步提取上下文信息。我们将新提出的 DAC 块和 RMP 块与主干编码器-解码器结构相结合,提出了一种名为CE-Net的新型上下文编码器网络。 它依靠DAC块和RMP块来获得更多的抽象特征和保留更多的空间信息,从而提高医学图像分割的性能。 论文主要贡献:我们提出了一个DAC块和RMP块,以捕获更多的高级特征和保留更多的空间信息。 我们将提出的DAC块和RMP块与编码器-解码器结构相结合,用于医学图像分割。 将该方法应用于视盘分割、视网膜血管检测、肺分割、细胞轮廓分割和视网膜OCT层段分割。结果表明,该方法在不同任务下的性能优于现有方法。 二、Method 网络架构本文提出的CE-Net主要由三部分组成:特征编码模块、上下文提取模块和特征解码器模块,如图1所示:

在U-Net架构中,编码器的每个块包含两个卷积层和一个最大池化层。在该方法中,我们将其替换为特征编码模块中预先训练好的ResNet-34[53],保留了前4个特征提取块,没有平均池化层和全连通层。与原块相比,ResNet增加了快捷机制,避免了梯度消失,加速了网络收敛,如图1(b)所示。为了方便起见,我们使用预先训练的ResNet作为骨干方法的改良U-net。 上下文提取器模块是一个新提出的模块,由DAC块和RMP块组成。该模块提取上下文语义信息并生成更高级的特性映射 1) Atrous Convolution:在语义分割任务和目标检测任务中,深度卷积层在提取图像特征表示方面已被证明是有效的。然而,池化层会导致图像中语义信息的丢失。为了克服这一限制,对[56]密集分割采用了atrous卷积: The atrous convolution最初是为了高效计算小波变换而提出的。数学上,二维信号下的atrous卷积计算如下: 在深度学习中,Inception[54]和ResNet[53]是两个经典且具有代表性的架构。 Inception系列结构采用了不同的接受域来拓宽结构。相反,ResNet采用快捷连接机制,避免了梯度的爆炸和消失。它使神经网络首次突破了数千层。Inception-ResNet[54]块结合了Inception和ResNet,继承了这两种方法的优点。从而成为深度cnn领域的一种基准方法。 基于Inception-ResNet-V2块和atrous卷积,我们提出了密集atrous卷积(DAC)块来编码高级语义特征映射。如图3所示,将atrous卷积以级联方式叠加。在这种情况下,DAC有四个级联分支,随着atrous卷积数的逐渐增加,从1到1、3、5,每个分支的感受野分别为3、7、9、19。它使用不同的接受域,类似于Inception结构。在每个atrous分支,我们应用一个1×1卷积校正线性激活。最后,我们直接在原有特性的基础上添加其他特性,比如ResNet中的快捷机制。由于所提出的块看起来像一个密集连接块,我们称它为密集atrous卷积块。通常情况下,大接收场的卷积对于大对象可以提取并生成更抽象的特征,而小接收场的卷积对于小对象则更好。DAC块通过结合不同atrous速率的atrous卷积,能够提取出不同大小的对象的特征。

医学图像中物体大小变化大是分割的一个挑战。例如,中晚期的肿瘤可能比早期的大得多。本文提出了残差多核池算法来解决这一问题,该算法主要依赖于多个有效视场来检测不同大小的目标 接受域的大小大致决定了我们能使用多少上下文信息。一般的最大池操作只使用一个池内核,例如2×2。如图4所示,所提出的RMP用四个不同大小的接受域对全局上下文信息进行编码:2×2, 3×3, 5×5和6×6。四个级别的输出包含不同大小的特性映射。为了减少权值的维数和计算成本,我们在池化的每一层之后使用1×1卷积。它将特征图的维度降低到原始尺寸的 1/N 。 总结其中N为原始特征图中的通道数。然后对低维特征图进行上采样,通过双线性插值得到与原始特征图相同大小的特征。最后,我们将原始特征与上采样特征映射连接起来。 提示:这里对文章进行总结: 采用特征解码器模块对特征编码器模块和上下文提取模块提取的高级语义特征进行恢复。 跳过连接从编码器到解码器获取一些详细信息,以弥补连续池化和跨越式卷积操作造成的信息丢失。与[48]类似,我们采用了一个有效的块来提高译码性能。u型网络解码器的两种常用操作是简单的升级和反褶积。升级运算通过线性插值来增大图像大小,而反褶积(也称为转置卷积)通过卷积运算来放大图像。直观地说,转置卷积可以学习自适应映射,以恢复更详细的信息特征。因此,我们选择使用转置卷积来恢复解码器的高分辨率特征。如图1©所示,主要包括依次为1×1 co olu, 3×3转置卷积和1×1卷积。特征解码器模块基于跳跃连接和解码器块,输出与原始输入相同大小的掩码 三,Experiment 实验分割结果

为了验证预训练的ResNet、DAC块和RMP块在CE-Net中的有效性, 1)采用预训练ResNet模型的消融研究:我们提出的方法基于U-Net,因此U-Net是最基本的基线模型。我们使用残差块来代替U-Net原有的编码器块,以提高学习能力。我们把预先训练残差块和特征解码器的改进的u形网络称为骨干网络。最近的研究[78]指出,ImageNet预训练在很大程度上有助于规避优化问题,预训练权重的微调比从头开始收敛得更快。我们还进行了实验来比较训练前和没有训练的结果。图8显示了两种情况下的损失如何变化。

正如我们所看到的,在进行前训练的情况下,损失减少得更快。表VI显示了分割结果。通过采用预先训练的ResNet块,Backbone方法获得了更好的性能。对于OD分割,重叠误差从0.115降至0.075,降低34.8%。视网膜血管检测Acc和AUC分别从0.939和0.960增加到0.943和0.971。 结果表明,预处理的ResNet块是有益的 2)密集Atrous卷积块的消融研究:DAC块采用了不同速率的atrous卷积,组装在类似Inception的块中。因此,我们首先进行实验来验证atrous卷积的有效性。我们使用常规卷积来代替DAC块中的atrous卷积(参见Backbone + DAC w/o atrous)。如表VI所示,我们提出的DAC模块(参考Backbone + DAC with atrous)在OD分割方面将重叠误差从0.073减少到0.061,降低了16.4%,提高了视网膜血管检测中的Acc和AUC。这表明,与常规卷积相比,反向卷积有助于提取高级语义特征。我们还将我们提出的DAC块与常规的Inception-V2块(简称Backbone + Inception-block)进行了比较。对比结果表明,DAC块优于常规初始块,OD分割的重叠误差从0.068减少到0.061,相对减少了10.3%。最后,重叠误差从 Backbone 的 0.075 降低到 0.061(Backbone +DAC),降低了 18.7%。 这表明,所提出的DAC块能够进一步提取全局信息,得到高分辨率的高级语义特征图,这对我们的分割任务是很有用的。 3)残差多核池模块的消融研究:表VI还展示了RMP的效果,提高了OD分割的性能。带RMP模块的Backbone被称为“Backbone+ RMP”。OD分割的重叠误差从0.075下降到0.061,与Backbone相比下降了18.7%;视网膜血管检测的Acc和AUC评分从0.943和0.971上升到0.952和0.974。RMP模块可以对全局信息进行编码,改变特征图的组合方式。

研究表明,复杂性是网络能力的体现[79],复杂性的增加往往导致更好的性能。因此,人们担心改进可能来自于网络复杂性的增加。为了缓解这种担忧,我们将我们的网络与具有类似复杂性的网络进行比较。在本文中,我们将其与上述由常规的Inception-ResNet-V2块(backbone + Inception-ResNet-block)备份的骨干进行比较。表VI显示我们的CE-Net更好,OD分割的重叠误差从0.065减少到0.058,Acc和AUC评分从0.951和0.974增加到0.955和0.978 四,总结医学图像分割在医学图像分析中占有重要地位。本文提出了一种用于医学图像分割的端到端深度学习框架CE-Net。与U-Net相比,CE-Net采用预训练的ResNet块作为特征编码器。在ResNet改进的U-Net结构中集成了新提出的密集atrous卷积块和剩余多核池,以捕获更多的高级特征和保留更多的空间信息。我们的方法可以应用到一个新的应用精细调整我们的模型使用新的训练数据和手动地面真相。实验结果表明,本文提出的方法能够在视盘分割、视网膜血管检测、视网膜血管检测、肺分割,细胞轮廓分割,视网膜OCT层分割。 该方法具有通用性,可应用于其他二维医学图像分割任务。本文在二维图像上验证了我们的方法,将其扩展到三维数据将是一个可能的未来工作。 |

【本文地址】

其中,输入特征映射x和滤波器w的卷积得到输出y, atrous速率r对应于我们对输入信号采样的步幅。它相当于将输入x与上采样滤波器进行卷积,通过在沿每个空间维度的两个连续滤波器值之间插入r−1个零产生(因此得名atrous卷积,法语单词atrous在英语中表示孔)。标准卷积是速率r = 1的一种特殊情况,atrous卷积允许我们通过改变速率值自适应地修改滤波器的视场。如图2所示。

其中,输入特征映射x和滤波器w的卷积得到输出y, atrous速率r对应于我们对输入信号采样的步幅。它相当于将输入x与上采样滤波器进行卷积,通过在沿每个空间维度的两个连续滤波器值之间插入r−1个零产生(因此得名atrous卷积,法语单词atrous在英语中表示孔)。标准卷积是速率r = 1的一种特殊情况,atrous卷积允许我们通过改变速率值自适应地修改滤波器的视场。如图2所示。