| U2Fusion: A Unified Unsupervised Image Fusion Network 图像融合论文阅读 | 您所在的位置:网站首页 › cnn文章阅读 › U2Fusion: A Unified Unsupervised Image Fusion Network 图像融合论文阅读 |

U2Fusion: A Unified Unsupervised Image Fusion Network 图像融合论文阅读

|

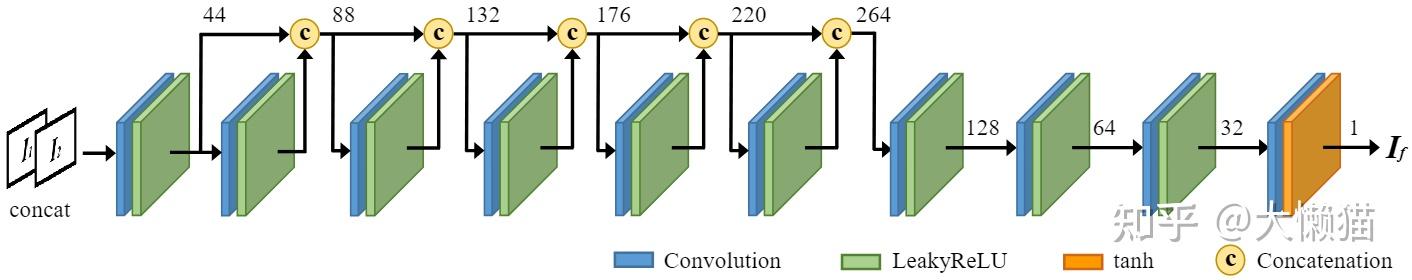

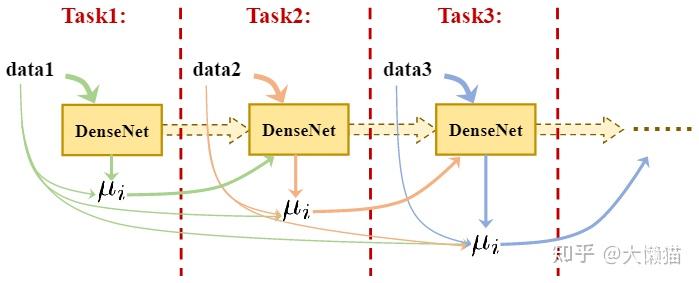

U2Fusion: A Unified Unsupervised Image Fusion NetworkU2Fusion: 一种统一的无监督图像融合网络研究背景由于硬件设备或光学成像的限制,使用一种类型的传感器或一种单一的拍摄设置拍摄的图像只能捕捉到一部分信息。例如,反射光的信息,其亮度在有限的范围内,在预定的景深内,是不完整信息的典型表示。基于传统融合框架的方法中,融合规则的有限选择和手动设计的复杂性限制了性能的提高。在端到端模型中,融合问题是通过依赖监督学习的基本事实或专门设计的无监督学习指标来解决的。然而,不存在用于多个任务的通用基本事实或无参考指标。由于源图像的类型不同,要集成的重要信息差异很大,因此限制了大多数方法对特定任务的有效性。 现有算法的通用性不足,只适合单一的图像融合任务。Idea 神经网络具有强大的特征表示能力,可以统一表示多种多样的信息,它可以形成一个统一的融合框架,作者将此作为研究切入点。鉴于统一模型已经过多曝光图像融合训练,它能够提高多模态或多焦点图像中曝光不足/曝光过度区域的融合性能。因此,通过收集多个任务的优势,统一模型可以为每个单一融合任务取得更好的结果,比多个单独训练的模型具有更强的泛化能力。 在连续学习(Continual Learning)环境中,学习被视为要学习的一系列任务。在训练阶段,权重会适应新任务而不会忘记之前学习的任务。在本研究中,作者使用连续学习以解决多个融合任务。 聚焦于图像融合的主要目标,即保存源图像中的重要信息,模型基于测量来确定这些信息的丰富性。方法的关键问题是探索一种统一的测量方法来确定源图像的信息保存程度。作者的方法不是在监督学习中最大化融合结果和ground truth之间的相似度,而是依赖于这样的程度来保持与源图像的自适应相似度。而且,作为一种无监督模型,它适用于ground truth几乎不可用的多重融合问题。 模型概述提出了一种称为 U2Fusion 的统一无监督图像融合网络。在信息保存方面,首先采用特征抽取器从源图像中提取丰富而全面的特征。然后,测量特征中的信息的丰富度以定义这些特征的相对重要性,这说明了源图像和融合结果之间的相似关系。在这些策略的基础上,训练 DenseNet 模块来生成融合结果,而不需要 ground truth。 模型优势通过考虑上述限制,作者提出了一种统一的无监督图像融合网络,该网络具有以下特征。i) 它是一个端到端的模型,不受手动设计的融合规则的限制。ii)它是各种融合任务的统一模型,而不是特定目标,例如独特问题、度量的特殊性、二进制掩码的需求等。iii)它是一个无监督的模型,不需要ground truth。iv)通过不断学习解决新任务而不丧失原有能力,它可以用统一的参数解决多个任务。 网络结构 图1 U2Fusion 网络流程图,虚线表示损失函数中使用的数据 I_1\和I_2\表示源图像,训练 DenseNet以生成融合图像I_f\。特征提取的输出是特征图\phi_{C_1}(I_1)\、··· 、\phi_{C_5}(I_1)\和\phi_{C_1}(I_2) \、··· 、\phi_{C_5}(I_2)\。然后对这些特征图执行信息测量,产生由g_{I_1}\和g_{I_2}\表示的两个测量值。在随后的处理中,最终的信息保存度表示为\omega_1\和\omega_2\。 在损失函数中使用I_1\、I_2\、I_f\、\omega_1\和\omega_2 \,无需 ground truth。在训练阶段,\omega_1\和\omega_2 \被测量并应用于定义损失函数。然后,优化 DenseNet 模块以最小化损失函数。在测试阶段,不需要测量\omega_1\和\omega_2 \,因为 DenseNet 已经优,DenseNet 网络结构如图所示:  图2 模型中使用的DenseNet架构,串联/LeakyReLU/tanh函数后显示的数字是相应特征图的通道 DenseNet用于生成融合结果I_f\,其中输入是I_1\和I_2\的级联。因此,它是一个端到端的模型,不需要设计融合规则。U2Fusion 中 DenseNet 的架构由 10 个层组成,每个层都有一个卷积,然后是一个激活函数。所有卷积层的内核大小设置为 3×3,步长设置为 1。在卷积之前使用反射填充以减少边界伪影。没有使用池化层来避免信息丢失。前九层中的激活函数是 LeakyReLU,斜率设置为 0.2,而最后一层的激活函数为 tanh。 此外,研究已经证明,如果在接近输入和接近输出的层之间建立更短的连接,则神经网络可以更深入和有效地训练。因此,在前七层中,使用来自密集连接的 CNN 的密集连接块来提高信息流和性能。在这些层中,以前馈方式在每个层和所有层之间建立快捷直接连接,如图2中的级联操作所示。这样,可以减少梯度消失的问题。同时,可以在减少参数数量的同时进一步加强特征传播。特征图的通道都设置为 44。随后的四个层逐渐减少特征图的通道,直到达到单通道融合结果。 特征提取 图3 VGG-16为输入图像I\提取感知特征图,\phi_{C_j}(I)\表示在第 j 个最大池化层之前由卷积层提取的特征图。最后一行是以 [bathsize、height、width、channels] 形式提取的特征图的形状 信息测量为了测量提取的特征地图中包含的信息,使用其梯度进行评估。 其中\phi_{C_j}(I)\是图2中第 j 个最大池化层之前卷积层的特征图。k 表示D_j\通道的第 k 个通道中的特征图。\Vert\cdot\Vert_F\表示Frobenius范数,而\nabla\是拉普拉斯算子。 信息保存程度为了保存源图像中的信息,将两个自适应权值分配为信息保存度,定义了融合图像与源图像之间的相似度权重。权重越高代表相似度越高,对应的源图像的信息保存程度就越高。这些自适应权重表示为\omega_1\和\omega_2\是根据信息测量结果g_{I_1}\和g_{I_2}\来估计的,在损失函数中使用\omega_1\和\omega_2\来控制特定源图像的信息保存程度。。鉴于g_{I_1}\和g_{I_2}\之间的差值是绝对值而不是相对值,与它们本身相比,它可能太小,无法反映它们的差值。因此,为了增强和体现权重的差异,使用预定义的正常数c\来缩放值以获得更好的权重分配。因此,\omega_1\和\omega_2\定义为: 损失函数总损失函数 损失函数总损失函数 其中 θ 表示 DenseNet 中的参数,D 是训练数据集。L_{sim}(\theta)\是结果图像和源图像之间的相似性损失,L_{ewc}(\theta, D)\是为连续学习而设计的项目,如下一小节所述,λ是控制权衡的超参数。 SSIM损失L_{ssim}\ 其中S_{x, y}\表示两个图像之间的SSIM值。虽然SSIM关注对比度和结构的变化,但它对强度分布的差异表现出较弱的约束。 图像均方误差损失L_{SSIM}\ 同时,通过平均所有可能的输出,通过约束 MSE 获得的结果受到相对模糊的影响,而SSIM可以弥补这个问题。因此,这两个损失函数互补偿,α 为权重,L_{sim}(\theta, D)\公式为:  弹性权重合并(EWC)损失L_{ewc}(\theta, D)\使用联合训练会导致计算难度和时间成本不断增加,在顺序训练过程中,优化参数以解决新问题,同时失去从先前任务中学习到的能力,这个问题被称为灾难性遗忘。为了避免这一缺陷,应用弹性权重合并(EWC)算法来防止其发生。在EWC中,当前任务θ的参数值与先前任务θ的参数值之间的平方距离根据其对θ的重要性进行加权。这些重要参数被赋予更高的权重,以防止忘记从旧任务中学习到的内容,而重要性较小的参数可以被修改到更大的程度,以从新任务中学习。通过这种方式,该模型能够通过弹性权重合并进行连续学习。连续学习的损失,称为L_{ewc}(\theta, D)\: 弹性权重合并(EWC)损失L_{ewc}(\theta, D)\使用联合训练会导致计算难度和时间成本不断增加,在顺序训练过程中,优化参数以解决新问题,同时失去从先前任务中学习到的能力,这个问题被称为灾难性遗忘。为了避免这一缺陷,应用弹性权重合并(EWC)算法来防止其发生。在EWC中,当前任务θ的参数值与先前任务θ的参数值之间的平方距离根据其对θ的重要性进行加权。这些重要参数被赋予更高的权重,以防止忘记从旧任务中学习到的内容,而重要性较小的参数可以被修改到更大的程度,以从新任务中学习。通过这种方式,该模型能够通过弹性权重合并进行连续学习。连续学习的损失,称为L_{ewc}(\theta, D)\: 其中 i 表示网络中的第 i 个参数,\mu_i\表示相应平方距离的权重。为了评估重要性,\mu_i\被指定为 Fisher 信息矩阵的对角项,并通过使用先前任务中的数据计算梯度的平方来近似,定义如下:  鉴于可以在丢弃旧数据D^*\之前计算 Fisher 信息矩阵,该模型不需要D^*\来训练当前任务。如果存在几个先前的任务,则根据特定任务和相应数据调整L_{ewc}(\theta, D)\。然后,对最终\mu_i\的这些梯度的平方进行平均。训练过程和数据流如图所示:  图4 EWC过程中数据流的直观描述,细线表示只保留了一小部分数据,这些数据仅用于计算\mu_i\,而不用于训练 DenseNet 实验验证实验配置融合任务以及数据集 在三种类型的融合任务上执行 U2Fusion:i)多模态图像融合,包括VIS-IR和医学图像(PET-MRI)融合;ii)多曝光图像融合;iii)多曝光图像融合。训练数据集来自四个公开可用的数据集:任务1使用 RoadScene(VIS-IR)和 Harvard2(PETMRI),任务2使用 Learning a Deep Single Image Contrast Enhancer from Multi-Exposure Images 的中的数据集,以及任务3使用Lytro。为了验证通用性,测试数据集还包含两个附加数据集:用于VIS-IR图像融合的 TNO 和用于多曝光图像融合的 EMPA HDR。 所有数据集中的源图像被裁剪成大小为64×64的图像块。对于多焦点图像,由于对齐的图像对不足,图像被放大和翻转以获得额外的训练数据。我们将 α =20,λ =8e4,c 设置为3e3、3.5e3 和 1e2,并且相应地将 epochs 设置为3、2 和 2。优化器RMSPropOptimizer以学习率1e-4更新参数。批量大小为18。实验在NVIDIA Geforce GTX Titan X GPU和3.4 GHz Intel Core i5-7500 CPU上进行。融合结果评估主观评价(定性比较)任务红外与可见光医学图像多曝光多聚焦数据集TNO、RoadSceneHarvardEMPA HDRDSIFT方法HMSDRPCNNGFFGBMGTFCNNDSIFTCNNDenseFusePAPCNNGBMGFDFFusionGANNSCTDeepfuseSESF-FuseDDcGAANFLER客观评价(定量比较)任务红外与可见光、医学图像多曝光多聚焦correlation coefficient (CC)测量源图像和结果之间的线性相关度CCCCSSIM结构相似性指数SSIMEIpeak signalto-noise ratio (PSNR)评估由融合过程引起的失真PSNRVIFsum of the correlations of differences (SCD)量化融合图像的质量SCDMGedge intensity (EI),反映了边缘点的梯度幅度消融实验EWC消融实验 当在没有EWC的情况下训练模型时,任务2的性能下降,整个图像的亮度降低。此外,在任务1的结果之间存在明显差异。使用EWC,这两个问题得到了缓解。独立训练 通过统一的参数,U2Fusion从单个任务中学习的信息可以促进其他任务。为了验证,我们为每个任务训练一个单独的模型。因此,不同任务之间不会发生交互。根据实验结果可知,通过集合多个任务的优势,U2Fusion不仅对多种类型的源图像具有较强的泛化能力,而且对同一类型源图像中的多种区域也具有较强的泛化能力。因此,一个统一的模型可以实现不同融合任务的相互促进。自适应信息保存度的消融实验 为了验证自适应信息保存度的有效性,我们进行了ω1和ω2直接设置为0.5的实验。这种现象在多焦点图像融合的结果中最为明显。当ω1和ω2直接设置为0.5时,网络无法区分聚焦区域和散焦区域。训练顺序消融实验 多模式和多曝光图像融合的训练顺序对融合结果的影响不大,而多聚焦图像的训练顺序对融合结果的影响比较显著。多模式→多曝光→多聚焦的顺序表现最佳。因此,在U2Fusion中采用了它。U2Fusion vs. FusionDN四方面改进:首先,改进了信息保存度分配策略。通过对提取的特征进行信息度量来分配信息保存程度,而不是原始源图像中的信息量和信息质量。通过考虑其他方面,改进的策略提供了一种改进的综合度量来捕捉源图像的本质特征。其次,对损失函数进行修正。梯度损失的去除减少了虚假边缘,增加的基于像素强度的损失有助于减少融合图像中的亮度偏差。第三,我们将第一个任务从可见光(VIS)和红外(IR)图像融合转变为多模式图像融合,其中包括可见光-红外图像融合和医学图像融合。最后,在其他公开可用的数据集上验证了U2Fusion。知识欠缺1、二元聚焦掩模 binary focus mask图像处理中的 “掩膜” Mask_掩膜图像_暖仔会飞的博客-CSDN博客 2、连续学习 Continual Learning连续学习介绍 | Xiu's Blog (xiuyuli.com) 连续学习Continual learning, CL 最新2022研究综述 - 知乎 (zhihu.com) 3、拉普拉斯算子[OpenCV-图像处理]如何计算图像梯度,以及如何使用梯度来检测边缘-CSDN博客 [Python图像处理] 十七.图像锐化与边缘检测之Roberts、Prewitt、Sobel和Laplacian算子 - 腾讯云开发者社区-腾讯云 (tencent.com) 4、Fisher information matrix Fisher信息矩阵方差、标准差、协方差、相关系数 - 知乎 (zhihu.com) 费舍尔信息矩阵及自然梯度法 - 知乎 (zhihu.com) 5、YCbCr color spaceRGB与YCBCR颜色空间转换及python实现 - 知乎 (zhihu.com) |

【本文地址】