| 强化学习记录 | 您所在的位置:网站首页 › ELLF算法与LLF算法的区别 › 强化学习记录 |

强化学习记录

|

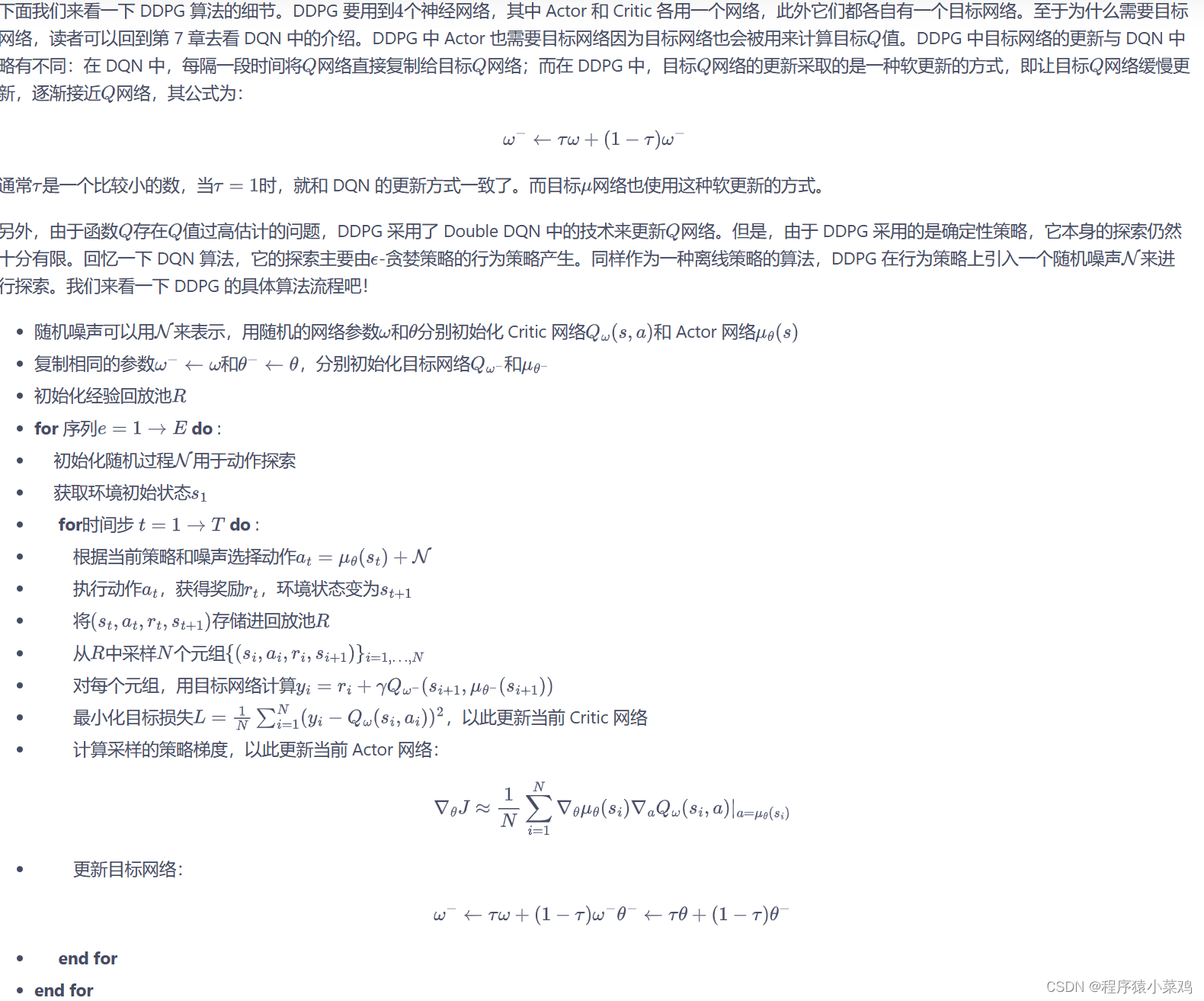

Actor-Critic 和 PPO都是在线策略算法,这意味着它们的样本效率比较低。 DQN 算法直接估计最优函数 Q,可以做到离线策略学习,但是它只能处理动作空间有限的环境,这是因为它需要从所有动作中挑选一个值最大的动作。如果动作个数是无限的,虽然可以将动作空间离散化,但这比较粗糙,无法精细控制。 深度确定性策略梯度(DDPG)是用来处理动作空间无限的环境并且使用离线策略的算法。构造一个确定性策略,用梯度上升的方法来最大化Q值。 PPO 学习随机性策略,而DDPG 则学习一个确定性策略。 DDPG 是离线策略算法,但是它的训练非常不稳定,收敛性较差,对超参数比较敏感,也难以适应不同的复杂环境。一个更加稳定的离线策略算法 Soft Actor-Critic(SAC)被提出,属于最大熵强化学习的范畴。SAC学习一个随机性策略。 最大熵强化学习(maximum entropy RL)的思想就是除了要最大化累积奖励,还要使得策略更加随机。其中, SAC 算法原本是针对连续动作交互的环境提出的,但是SAC 也能处理与离散动作交互的环境,通过修改策略网络和价值网络的网络结构,得出SAC 可以在离散动作环境下平衡探索与利用的优秀性质。

|

【本文地址】

公司简介

联系我们