| 【深度学习】学习率 (learning rate) | 您所在的位置:网站首页 › 001是啥意思 › 【深度学习】学习率 (learning rate) |

【深度学习】学习率 (learning rate)

|

Introduction

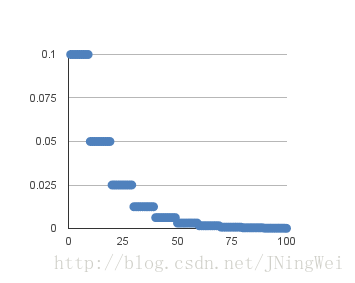

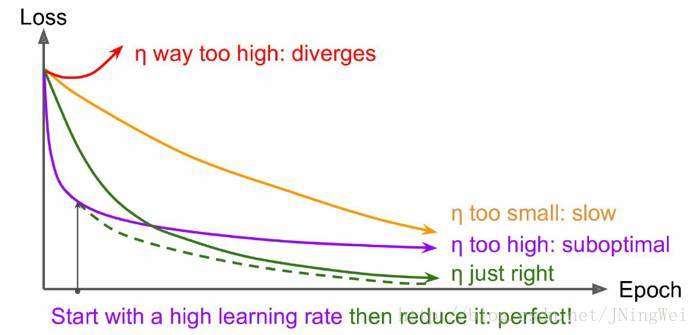

学习率 (learning rate),控制 模型的 学习进度 : lr 即 stride (步长) ,即反向传播算法中的 η \eta η : ω n ← ω n − η ∂ L ∂ ω n \omega^{n} \leftarrow \omega^{n} - \eta \frac{\partial L}{\partial \omega^{n}} ωn←ωn−η∂ωn∂L 学习率大小 学习率 大学习率 小学习速度快慢使用时间点刚开始训练时一定轮数过后副作用1.易损失值爆炸;2.易振荡。1.易过拟合;2.收敛速度慢。 学习率设置在训练过程中,一般根据训练轮数设置动态变化的学习率。 刚开始训练时:学习率以 0.01 ~ 0.001 为宜。一定轮数过后:逐渐减缓。接近训练结束:学习速率的衰减应该在100倍以上。Note: 如果是 迁移学习 ,由于模型已在原始数据上收敛,此时应设置较小学习率 ( ≤ 1 0 − 4 \leq 10^{-4} ≤10−4) 在新数据上进行 微调 。 学习率减缓机制 轮数减缓指数减缓分数减缓英文名step decayexponential decay 1 / t 1/t 1/t decay方法每N轮学习率减半学习率按训练轮数增长指数插值递减 l r t = l r 0 / ( 1 + k t ) lr_{t} = lr_{0} / (1+kt) lrt=lr0/(1+kt) , k k k 控制减缓幅度, t t t 为训练轮数 把脉 目标函数损失值 曲线理想情况下 曲线 应该是 滑梯式下降 [绿线]: [1] 调整学习速率以优化神经网络训练 [2] 如何找到最优学习率 |

【本文地址】

公司简介

联系我们