垃圾分类数据集+垃圾分类识别训练代码(支持googlenet, resnet, inception |

您所在的位置:网站首页 › 垃圾分类数据统计表格 › 垃圾分类数据集+垃圾分类识别训练代码(支持googlenet, resnet, inception |

垃圾分类数据集+垃圾分类识别训练代码(支持googlenet, resnet, inception

|

垃圾分类数据集+垃圾分类识别训练代码(支持googlenet, resnet, inception_v3, mobilenet_v2)

目录 垃圾分类数据集+垃圾分类识别训练代码(支持googlenet, resnet, inception_v3, mobilenet_v2) 1. 前言 2. 垃圾数据集说明 (1)垃圾数据集dataset1 (2)垃圾数据集dataset2 (3)自定义数据集 3. 垃圾分类识别模型训练 (1)项目安装 (2)准备Train和Test数据 (3)配置文件: config.yaml (4)开始训练 (5)可视化训练过程 (6)一些优化建议 (7) 一些运行错误处理方法: cannot import name 'load_state_dict_from_url' 4. 垃圾分类识别模型测试效果 5.项目源码下载 1. 前言垃圾分类,指按一定规定或标准将垃圾分类储存、分类投放和分类搬运,从而转变成公共资源的一系列活动的总称。分类的目的是提高垃圾的资源价值和经济价值,力争物尽其用。智能化垃圾分类系统能能够加速绿色环保的垃圾处理过程,并且对于居民垃圾分类意识的养成有极大的促进作用,对绿色都市和智能化城市管理都有着重大意义。

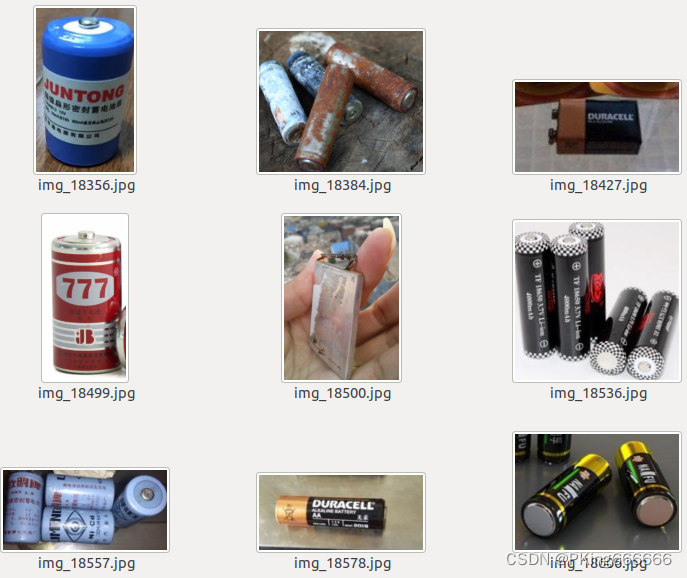

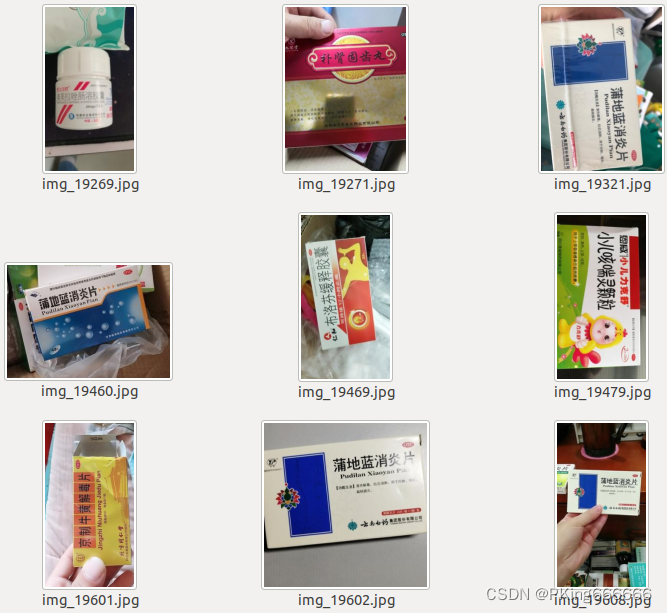

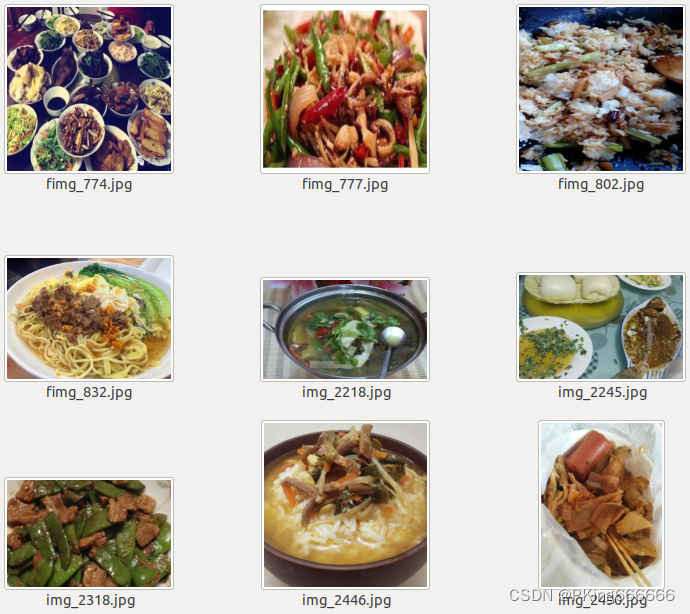

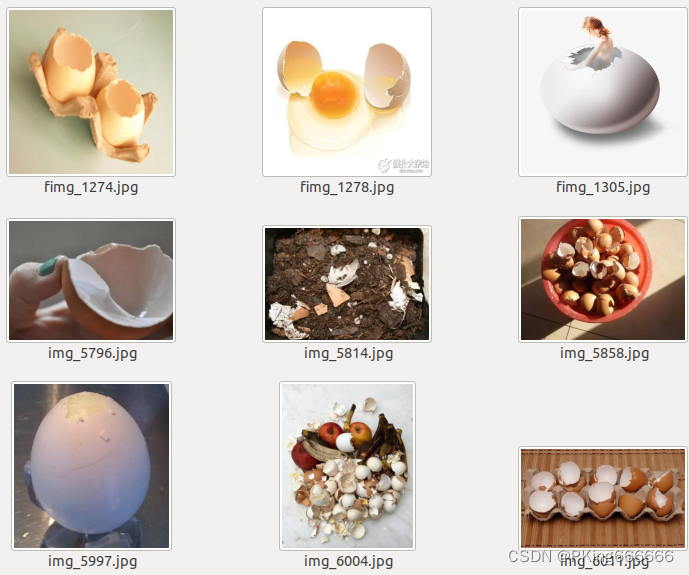

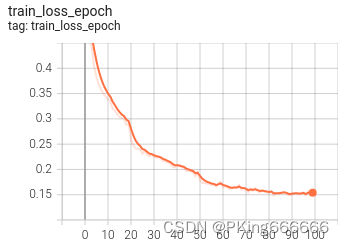

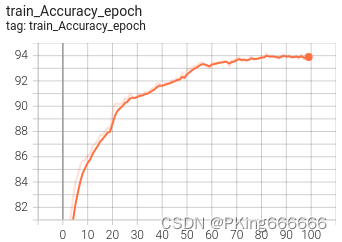

本项目将采用深度学习的方法,基于Pytorch搭建一个垃圾分类识别的训练和测试系统,实现智能化垃圾分类。目前,基于ResNet18的垃圾分类识别,在垃圾数据集dataset2,训练集的Accuracy在94%左右,测试集的Accuracy在92%左右,骨干网络可支持googlenet, resnet[18,34,50], inception_v3,mobilenet_v2等常用模型。如果想进一步提高准确率,可以尝试: 最重要的: 清洗数据集,垃圾数据集dataset1和垃圾数据集dataset2,大部分数据都是网上爬取的,质量并不高,存在很多错误的图片,尽管鄙人已经清洗一部分了,但还是建议你,训练前,再次清洗数据集,不然会影响模型的识别的准确率。使用不同backbone模型,比如resnet50或者更深模型增加数据增强: 已经支持: 随机裁剪,随机翻转,随机旋转,颜色变换等数据增强方式,可以尝试诸如mixup,CutMix等更复杂的数据增强方式样本均衡: 建议进行样本均衡处理调超参: 比如学习率调整策略,优化器(SGD,Adam等)损失函数: 目前训练代码已经支持:交叉熵,LabelSmoothing,可以尝试FocalLoss等损失函数【尊重原创,转载请注明出处】https://blog.csdn.net/guyuealian/article/details/126419147 2. 垃圾数据集说明 (1)垃圾数据集dataset1这是通过网上爬虫获取的垃圾数据集,总共包含了可回收物(recyclables)、有害垃圾(hazardous)、厨余垃圾(kitchen)、其他垃圾(other)四大类,以及40个小类。其中可回收物(recyclables)23种、有害垃圾(hazardous)3种、厨余垃圾(kitchen)8种、其他垃圾(other)6种,每种垃圾包含大约400张图片,共1.7万余张图像。 其中Train集16200张图片,平均每个类别405张;Test集800张图片,平均每个类别20张图片 垃圾类别样图可回收物(recyclables)  有害垃圾(hazardous) 有害垃圾(hazardous)  厨余垃圾(kitchen) 厨余垃圾(kitchen)  其他垃圾(other) 其他垃圾(other)

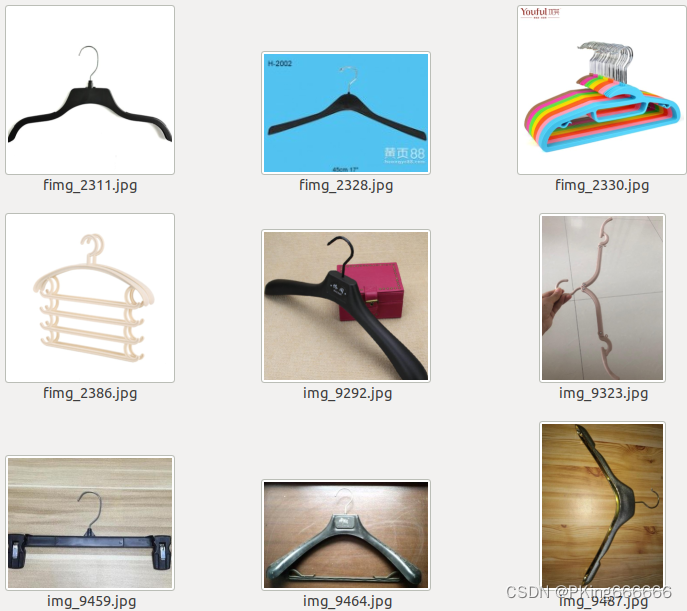

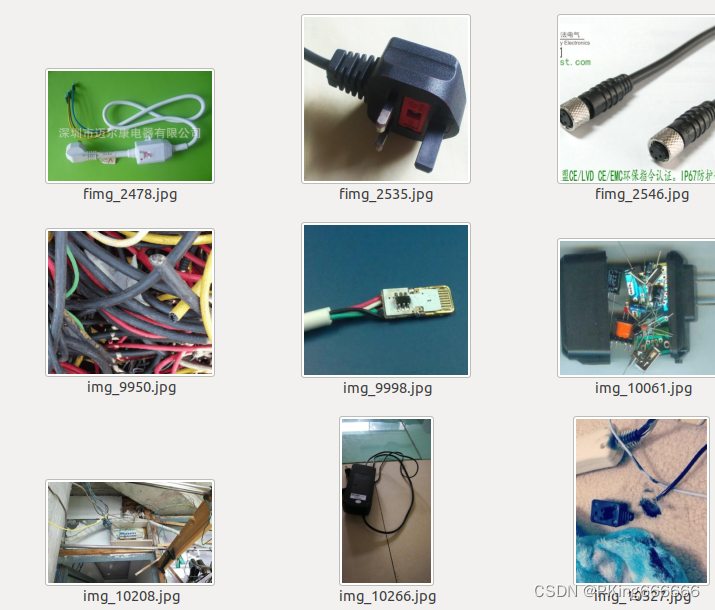

下表给出垃圾数据集dataset1的40个类别: 0-other garbage-fast food box 1-other garbage-soiled plastic 2-other garbage-cigarette 3-other garbage-toothpick 4-other garbage-flowerpot 5-other garbage-bamboo chopsticks 6-kitchen waste-meal 7-kitchen waste-bone 8-kitchen waste-fruit peel 9-kitchen waste-pulp 10-kitchen waste-tea 11-kitchen waste-Vegetable 12-kitchen waste-eggshell 13-kitchen waste-fish bone 14-recyclables-powerbank 15-recyclables-bag 16-recyclables-cosmetic bottles 17-recyclables-toys 18-recyclables-plastic bowl 19-recyclables-plastic hanger 20-recyclables-paper bags 21-recyclables-plug wire 22-recyclables-old clothes 23-recyclables-can 24-recyclables-pillow 25-recyclables-plush toys 26-recyclables-shampoo bottle 27-recyclables-glass cup 28-recyclables-shoes 29-recyclables-anvil 30-recyclables-cardboard 31-recyclables-seasoning bottle 32-recyclables-bottle 33-recyclables-metal food cans 34-recyclables-pot 35-recyclables-edible oil barrel 36-recyclables-drink bottle 37-hazardous waste-dry battery 38-hazardous waste-ointment 39-hazardous waste-expired drugs (2)垃圾数据集dataset2该垃圾数据集是只包含两个大类,没有细分小类,其中类别Organic表示有机垃圾,类别Recycle表示可回收垃圾。Train集22,566张图片,Test集2,513张图片。 垃圾类别样图Organic有机垃圾 Recycle回收垃圾 Recycle回收垃圾 (3)自定义数据集

(3)自定义数据集

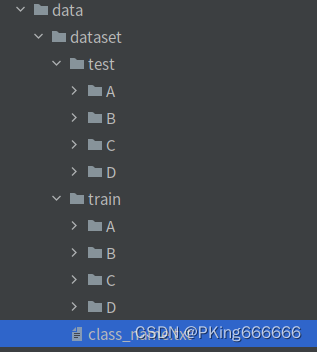

如果需要新增类别数据,或者需要自定数据集进行训练,可以如下进行处理: Train和Test数据集,要求相同类别的图片,放在同一个文件夹下;且子目录文件夹命名为类别名称,如

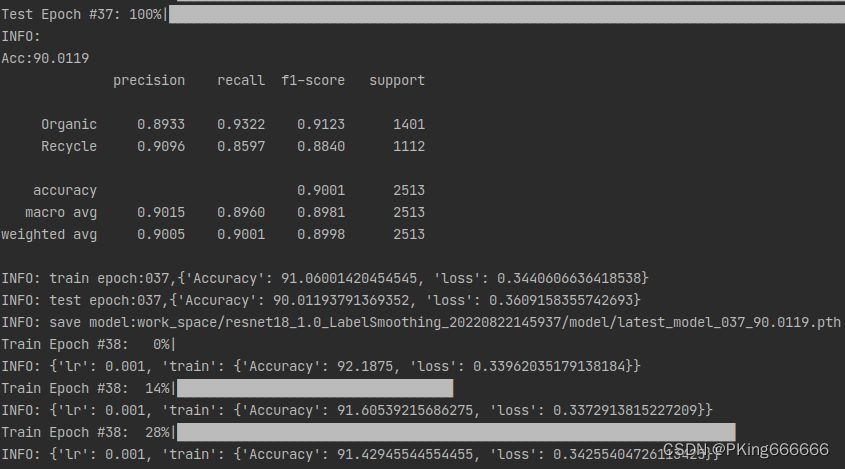

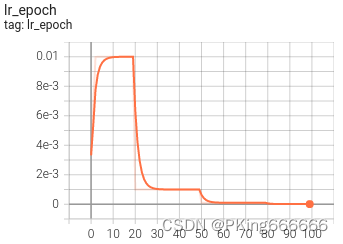

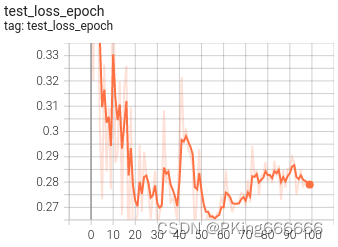

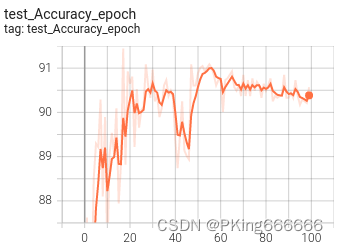

垃圾数据集dataset1和垃圾数据集dataset2,大部分数据都是网上爬取的,质量并不高,存在很多错误的图片,尽管鄙人已经清洗一部分了,但还是建议你,训练前,再次清洗数据集,不然会影响模型的识别的准确率。 3. 垃圾分类识别模型训练 (1)项目安装整套工程基本框架结构如下: . ├── classifier # 训练模型相关工具 ├── configs # 训练配置文件 ├── data # 训练数据 ├── libs ├── demo.py # 模型推理demo ├── README.md # 项目工程说明文档 ├── requirements.txt # 项目相关依赖包 └── train.py # 训练文件项目依赖python包请参考requirements.txt,使用pip安装即可: numpy==1.16.3 matplotlib==3.1.0 Pillow==6.0.0 easydict==1.9 opencv-contrib-python==4.5.2.52 opencv-python==4.5.1.48 pandas==1.1.5 PyYAML==5.3.1 scikit-image==0.17.2 scikit-learn==0.24.0 scipy==1.5.4 seaborn==0.11.2 tensorboard==2.5.0 tensorboardX==2.1 torch==1.7.1+cu110 torchvision==0.8.2+cu110 tqdm==4.55.1 xmltodict==0.12.0 basetrainer pybaseutils==0.6.5项目安装教程请参考(初学者入门,麻烦先看完下面教程,配置好开发环境): 项目开发使用教程和常见问题和解决方法视频教程:1 手把手教你安装CUDA和cuDNN(1)视频教程:2 手把手教你安装CUDA和cuDNN(2)视频教程:3 如何用Anaconda创建pycharm环境视频教程:4 如何在pycharm中使用Anaconda创建的python环境 (2)准备Train和Test数据下载垃圾分类数据集,Train和Test数据集,要求相同类别的图片,放在同一个文件夹下;且子目录文件夹命名为类别名称。 数据增强方式主要采用: 随机裁剪,随机翻转,随机旋转,颜色变换等处理方式 import numbers import random import PIL.Image as Image import numpy as np from torchvision import transforms def image_transform(input_size, rgb_mean=[0.5, 0.5, 0.5], rgb_std=[0.5, 0.5, 0.5], trans_type="train"): """ 不推荐使用:RandomResizedCrop(input_size), # bug:目标容易被crop掉 :param input_size: [w,h] :param rgb_mean: :param rgb_std: :param trans_type: :return:: """ if trans_type == "train": transform = transforms.Compose([ transforms.Resize([int(128 * input_size[1] / 112), int(128 * input_size[0] / 112)]), transforms.RandomHorizontalFlip(), # 随机左右翻转 # transforms.RandomVerticalFlip(), # 随机上下翻转 transforms.ColorJitter(brightness=0.5, contrast=0.5, saturation=0.5, hue=0.1), transforms.RandomRotation(degrees=5), transforms.RandomCrop([input_size[1], input_size[0]]), transforms.ToTensor(), transforms.Normalize(mean=rgb_mean, std=rgb_std), ]) elif trans_type == "val" or trans_type == "test": transform = transforms.Compose([ transforms.Resize([input_size[1], input_size[0]]), # transforms.CenterCrop([input_size[1], input_size[0]]), # transforms.Resize(input_size), transforms.ToTensor(), transforms.Normalize(mean=rgb_mean, std=rgb_std), ]) else: raise Exception("transform_type ERROR:{}".format(trans_type)) return transform修改配置文件数据路径:config.yaml # 训练数据集,可支持多个数据集 train_data: - '/path/to/rubbish/dataset2/train' # 测试数据集 test_data: '/path/to/rubbish/dataset2/test' # 类别文件 class_name: '/path/to/rubbish/dataset2/class_name.txt' (3)配置文件: config.yaml 目前支持的backbone有:googlenet,resnet[18,34,50],inception_v3,mobilenet_v2等, 其他backbone可以自定义添加训练参数可以通过(configs/config.yaml)配置文件进行设置配置文件:config.yaml说明如下: # 训练数据集,可支持多个数据集 train_data: - '/path/to/rubbish/dataset2/train' # 测试数据集 test_data: '/path/to/rubbish/dataset2/test' # 类别文件 class_name: '/path/to/rubbish/dataset2/class_name.txt' train_transform: "train" # 训练使用的数据增强方法 test_transform: "val" # 测试使用的数据增强方法 work_dir: "work_space/" # 保存输出模型的目录 net_type: "resnet18" # 骨干网络,支持:resnet18/50,mobilenet_v2,googlenet,inception_v3 width_mult: 1.0 input_size: [ 224,224 ] # 模型输入大小 rgb_mean: [ 0.5, 0.5, 0.5 ] # for normalize inputs to [-1, 1],Sequence of means for each channel. rgb_std: [ 0.5, 0.5, 0.5 ] # for normalize,Sequence of standard deviations for each channel. batch_size: 32 lr: 0.01 # 初始学习率 optim_type: "SGD" # 选择优化器,SGD,Adam loss_type: "CrossEntropyLoss" # 选择损失函数:支持CrossEntropyLoss,LabelSmoothing momentum: 0.9 # SGD momentum num_epochs: 100 # 训练循环次数 num_warn_up: 3 # warn-up次数 num_workers: 8 # 加载数据工作进程数 weight_decay: 0.0005 # weight_decay,默认5e-4 scheduler: "multi-step" # 学习率调整策略 milestones: [ 20,50,80 ] # 下调学习率方式 gpu_id: [ 0 ] # GPU ID log_freq: 50 # LOG打印频率 progress: True # 是否显示进度条 pretrained: False # 是否使用pretrained模型 finetune: False # 是否进行finetune 参数类型参考值说明train_datastr, list-训练数据文件,可支持多个文件test_datastr, list-测试数据文件,可支持多个文件class_namestr-类别文件work_dirstrwork_space训练输出工作空间net_typestrresnet18 backbone类型,{resnet18/50,mobilenet_v2,googlenet,inception_v3} input_sizelist[128,128]模型输入大小[W,H]batch_sizeint32batch sizelrfloat0.1初始学习率大小optim_typestrSGD优化器,{SGD,Adam}loss_typestrCELoss损失函数schedulerstrmulti-step学习率调整策略,{multi-step,cosine}milestoneslist[30,80,100]降低学习率的节点,仅仅scheduler=multi-step有效momentumfloat0.9SGD动量因子num_epochsint120循环训练的次数num_warn_upint3warn_up的次数num_workersint12DataLoader开启线程数weight_decayfloat5e-4权重衰减系数gpu_idlist[ 0 ]指定训练的GPU卡号,可指定多个log_freqin20显示LOG信息的频率finetunestrmodel.pthfinetune的模型progressboolTrue是否显示进度条distributedboolFalse是否使用分布式训练 (4)开始训练整套训练代码非常简单操作,用户只需要将相同类别的数据放在同一个目录下,并填写好对应的数据路径,即可开始训练了。 python train.py -c configs/config.yaml (5)可视化训练过程 训练过程可视化工具是使用Tensorboard,使用方法,在终端输入: # 基本方法 tensorboard --logdir=path/to/log/ # 例如 tensorboard --logdir=work_space/mobilenet_v2_1.0_CrossEntropyLoss/log可视化效果

(6)一些优化建议

(6)一些优化建议

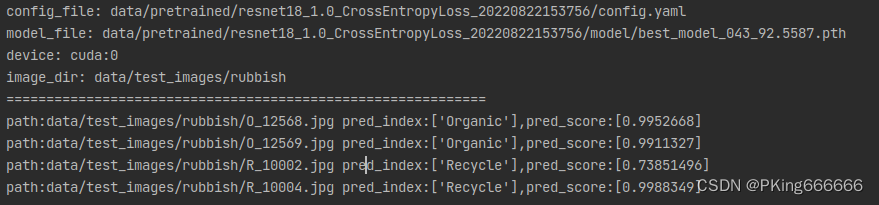

训练完成后,在垃圾数据集dataset2训练集的Accuracy在94%左右,测试集的Accuracy在92%左右;而在垃圾数据集dataset1的Accuracy在83%左右,如果想进一步提高准确率,可以尝试: 最重要的: 清洗数据集,垃圾数据集dataset1和垃圾数据集dataset2,大部分数据都是网上爬取的,质量并不高,存在很多错误的图片,尽管鄙人已经清洗一部分了,但还是建议你,训练前,再次清洗数据集,不然会影响模型的识别的准确率。使用不同backbone模型,比如resnet50或者更深模型增加数据增强: 已经支持: 随机裁剪,随机翻转,随机旋转,颜色变换等数据增强方式,可以尝试诸如mixup,CutMix等更复杂的数据增强方式样本均衡: 建议进行样本均衡处理调超参: 比如学习率调整策略,优化器(SGD,Adam等)损失函数: 目前训练代码已经支持:交叉熵,LabelSmoothing,可以尝试FocalLoss等损失函数 (7) 一些运行错误处理方法: 项目不要出现含有中文字符的目录文件或路径,否则会出现很多异常!!!!!!!! cannot import name 'load_state_dict_from_url'由于一些版本升级,会导致部分接口函数不能使用,请确保版本对应 torch==1.7.1 torchvision==0.8.2 或者将对应python文件将 from torchvision.models.resnet import model_urls, load_state_dict_from_url修改为: from torch.hub import load_state_dict_from_url model_urls = { 'mobilenet_v2': 'https://download.pytorch.org/models/mobilenet_v2-b0353104.pth', 'resnet18': 'https://download.pytorch.org/models/resnet18-5c106cde.pth', 'resnet34': 'https://download.pytorch.org/models/resnet34-333f7ec4.pth', 'resnet50': 'https://download.pytorch.org/models/resnet50-19c8e357.pth', 'resnet101': 'https://download.pytorch.org/models/resnet101-5d3b4d8f.pth', 'resnet152': 'https://download.pytorch.org/models/resnet152-b121ed2d.pth', 'resnext50_32x4d': 'https://download.pytorch.org/models/resnext50_32x4d-7cdf4587.pth', 'resnext101_32x8d': 'https://download.pytorch.org/models/resnext101_32x8d-8ba56ff5.pth', 'wide_resnet50_2': 'https://download.pytorch.org/models/wide_resnet50_2-95faca4d.pth', 'wide_resnet101_2': 'https://download.pytorch.org/models/wide_resnet101_2-32ee1156.pth', } 4. 垃圾分类识别模型测试效果demo.py文件用于推理和测试模型的效果,填写好配置文件,模型文件以及测试图片即可运行测试了 def get_parser(): # 配置文件 config_file = "data/pretrained/resnet18_1.0_CrossEntropyLoss_20220822153756/config.yaml" # 模型文件 model_file = "data/pretrained/resnet18_1.0_CrossEntropyLoss_20220822153756/model/best_model_043_92.5587.pth" # 待测试图片目录 image_dir = "data/test_images/rubbish" parser = argparse.ArgumentParser(description="Inference Argument") parser.add_argument("-c", "--config_file", help="configs file", default=config_file, type=str) parser.add_argument("-m", "--model_file", help="model_file", default=model_file, type=str) parser.add_argument("--device", help="cuda device id", default="cuda:0", type=str) parser.add_argument("--image_dir", help="image file or directory", default=image_dir, type=str) return parser python demo.py -c "data/pretrained/resnet18_1.0_CrossEntropyLoss_20220822153756/config.yaml" -m "data/pretrained/resnet18_1.0_CrossEntropyLoss_20220822153756/model/best_model_043_92.5587.pth" --image_dir "data/test_images/rubbish"运行测试结果:

pred_index:['Organic'],pred_score:[0.9952668]

pred_index:['Organic'],pred_score:[0.9911327]

pred_index:['Recycle'],pred_score:[0.73851496]

pred_index:['Recycle'],pred_score:[0.9988349] 5.项目源码下载整套项目源码内容包含:下载 垃圾数据集dataset1,其中Train集16200张图片,Test集800张图片垃圾数据集dataset2,其中Train集22,566张图片,Test集2,513张图片支持自定义数据集训练整套垃圾分类训练代码和测试代码(Pytorch版本) |

【本文地址】

今日新闻 |

点击排行 |

|

推荐新闻 |

图片新闻 |

|

专题文章 |