| 系统辨识 Identification Algorithm(基础篇) | 您所在的位置:网站首页 › 遗忘曲线法背知识点可以吗 › 系统辨识 Identification Algorithm(基础篇) |

系统辨识 Identification Algorithm(基础篇)

|

目录

目录 目录 基础知识 什么是系统辨识 辨识模型 噪声 矩阵运算 模型 时间序列模型 Time series model 方程误差模型 Equation error type model 输出误差模型 Output error type model 最小二乘法 Least Squares Principle 迭代最小二乘辨识 RLS identification 迭代最小二乘辨识的推导(对ARX模型) 最终结论 几个重要概念 带遗忘因子的迭代最小二乘辨识算法 FF-RLS 数据饱和 带遗忘因子的 RLS 固定记忆的 RLS 基础篇总结 基础知识 什么是系统辨识根据测得的输入输出,通过最小化误差标准函数,确定数学模型中未知的参数取值 Identification can be defined as the determination of a mathematical model from the observed input and output data by minimizing some error criterion function. 四个基本要素: A data set 数据集 A set of candidate models 模型类 criterion function 指标函数 optimizaiton approaches 优化方法 辨识模型在传递函数中,我们常用微分算子 s 的分式来表达输入输出之间的关系。在系统辨识中,我们根据 移位算子 z 的差分方程来表达输入、输出、噪声之间的关系 在系统辨识算法中,为了让不同的情况,不同的算法有共通的体系结构,我们所有的算法均是基于 辨识模型(identification model) 进行推演 辨识模型的特点: 无参变量\已知量 = 带参变量*待辨识参数 + 白噪声 噪声随机变量:形容随机事件的数学描述 随机过程:随时间变化的随机变量,依赖于时间 t 和事件 w,当时间固定时,即随机变量 白噪声 White Noise: Question: which terms as follows belong to white noise if v(t) is white noise: 根据白噪声的定义和性质可知,ABC仍然属于白噪声,而D不满足第三个条件 矩阵运算 f 列向量对 x 列向量的偏导:系统辨识中的模型均采用差分方程 difference function 的形式表达,其中 常用模型如下 时间序列模型 Time series model 自回归模型 AutoRegressive (AR) model其中,v是白噪声,na是自回归信号的阶 滑动平均模型 Moving Average (MA) model以下命名中的字母分别对应,输出信号类型、噪声类型、输入X 以下命名中的字母分别对应,输出OE、输入类型、噪声类型 此章为最小二乘法的推导过程,作为系统辨识算法推理的基础,详见最小二乘估计 迭代最小二乘辨识 RLS identification最小二乘辨识算法的核心,在于将现有模型转化为 辨识模型(identification model) 用以参数辨识

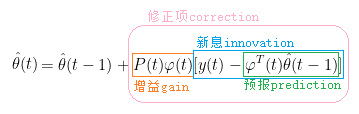

为了凑成辨识模型,我们定义 θ 和 φ 以便后期计算,可得相应的辨识模型 根据最小二乘法中得到的结论,参数 θ 的最小二乘估计为 据此,将 LSE 中求逆的部分单独定义为 为了保证算法的递推性,需要将 LSE 中的各变量递推关系式写出,如下 上述公式表示了各个变量在当前时刻与前一个时刻的递推关系,我们将上述递推关系代入 LSE 中得到递推的 LSE(此步骤目的是得到 θ(t) 与 θ(t-1) 之间的递推关系) 经过上面复杂的推导,终于获得了 递推最小二乘估计(Recursive Least Squares Estimation)算法 最终结论 由于矩阵求逆在实际运算中非常不友好,甚至不能保证可逆,因此引入以下矩阵多项式求逆算法: 代入到 P(t) 的递推关系式中,如下 P(t) 称为 协方差矩阵(covariance matrix) 为了表示方便,下面定义一个新的变量 L(t) 于是,可以得到递推最小二乘辨识的完整算法: 针对 RLSE 中各部分物理含义如下图所示

其中,根据 P(t) 的递推公式1.1,有下述情况需要考虑 可见,当且仅当 p0 取较大值时,P(t) 才能符合原有定义,否则算法会与实际值产生较大偏差 除此之外,在此区分定义两个概念: 新息(innovation): 残差(residual): 残差与新息的关系: 根据 RLS 算法,我们可以有以下推导 从上述推理可以发现,由于协方差矩阵 P 具有正定且单调递减的特性,会随着时间的增长最终趋于零,从而导致后面新加入的数据,对 RLSE 的影响越来越小。 这种情况下,对于一个数据集,如果有效数据集中在前面,不会对算法结果产生影响,正常运行;然而,如果有效数据集中在后面,则 RLS 会根据前面的无效数据获得结果,且后面的有效数据因为算法这一问题,无法修正结果,此时 RLS 的最终结果就是错误的。针对这种,新加入数据无法正常修正辨识结果的现象,称为 数据饱和(data saturation) data saturation: a phenomenon in which the new data have no attribution to improve the estimation of the parameter θ 带遗忘因子的 RLS为了解决数据饱和的问题,针对迭代算法,我们在每一次运算时,可以通过手动削弱之前估计值的影响,来保证新加入的数据可以修正结果。 其中,0 |

【本文地址】

| 今日新闻 |

| 推荐新闻 |

| 专题文章 |