| Python爬虫:汽车之家爬虫(完整代码) | 您所在的位置:网站首页 › 汽车之家二手车靠得住吗 › Python爬虫:汽车之家爬虫(完整代码) |

Python爬虫:汽车之家爬虫(完整代码)

|

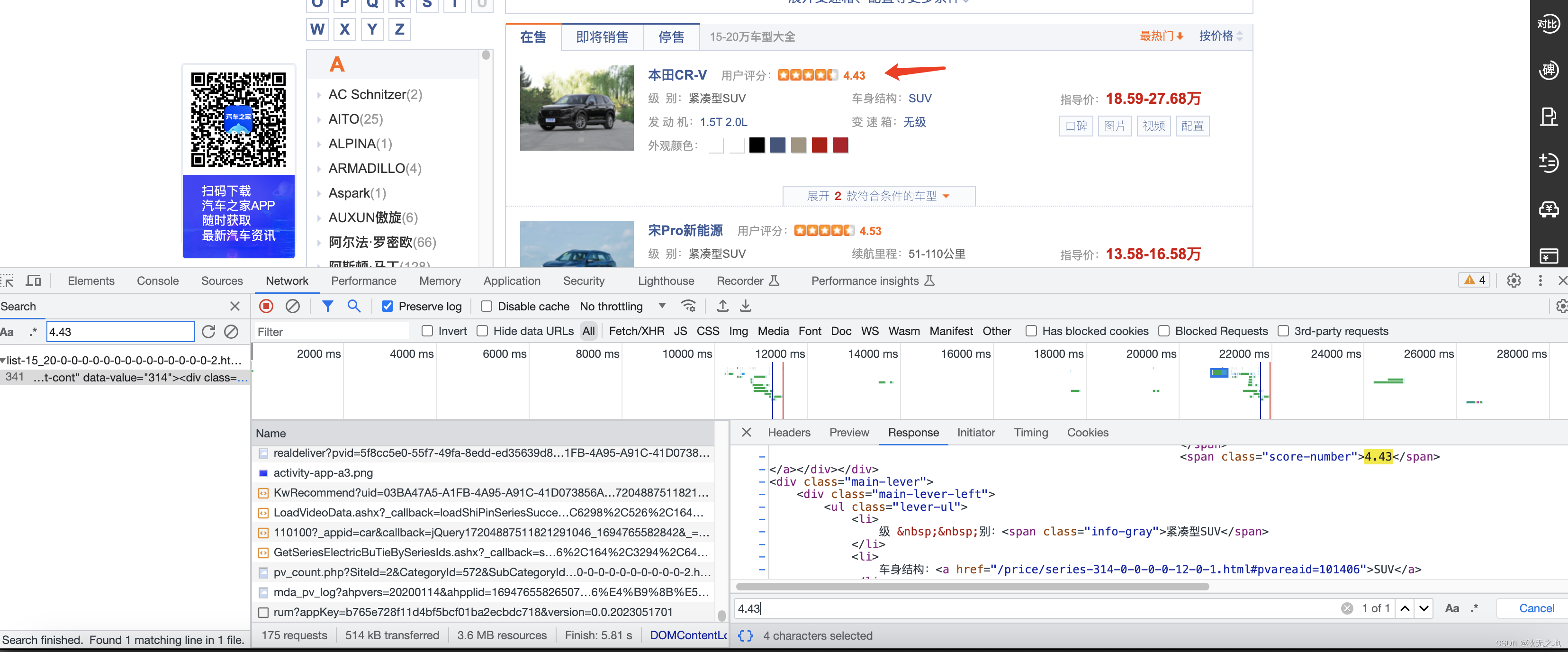

⭐️⭐️⭐️⭐️⭐️欢迎来到我的博客⭐️⭐️⭐️⭐️⭐️ 🐴作者:秋无之地 🐴简介:CSDN爬虫、后端、大数据领域创作者。目前从事python爬虫、后端和大数据等相关工作,主要擅长领域有:爬虫、后端、大数据开发、数据分析等。 🐴欢迎小伙伴们点赞👍🏻、收藏⭐️、留言💬、关注🤝,关注必回关 一、确定目标数据1、先打开目标网站,找到目标数据所在的页面

2、找到目标数据所在的api或页面 通过f12打开调试模式,通过搜索关键词,找到关键词所在的api或页面

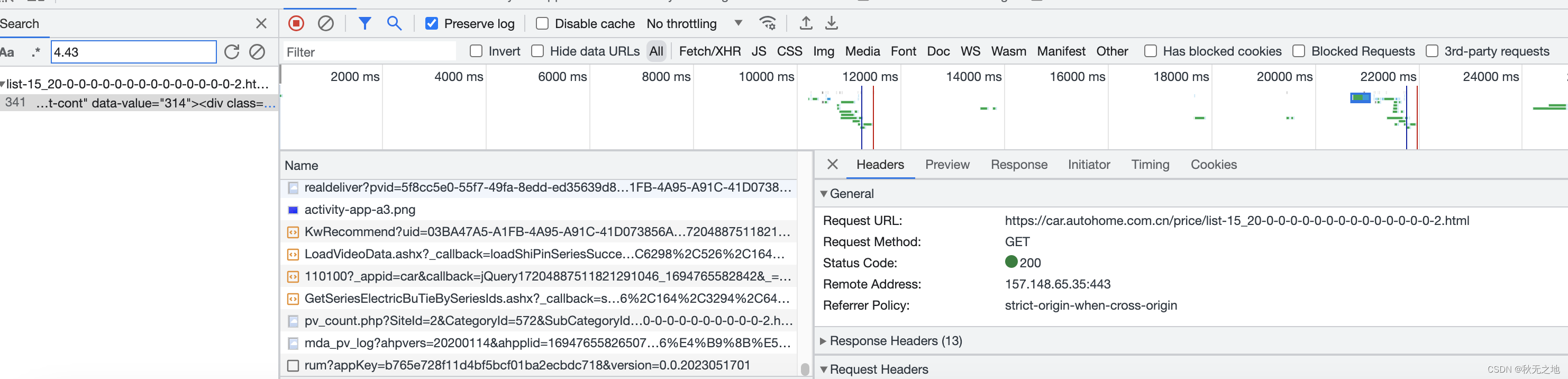

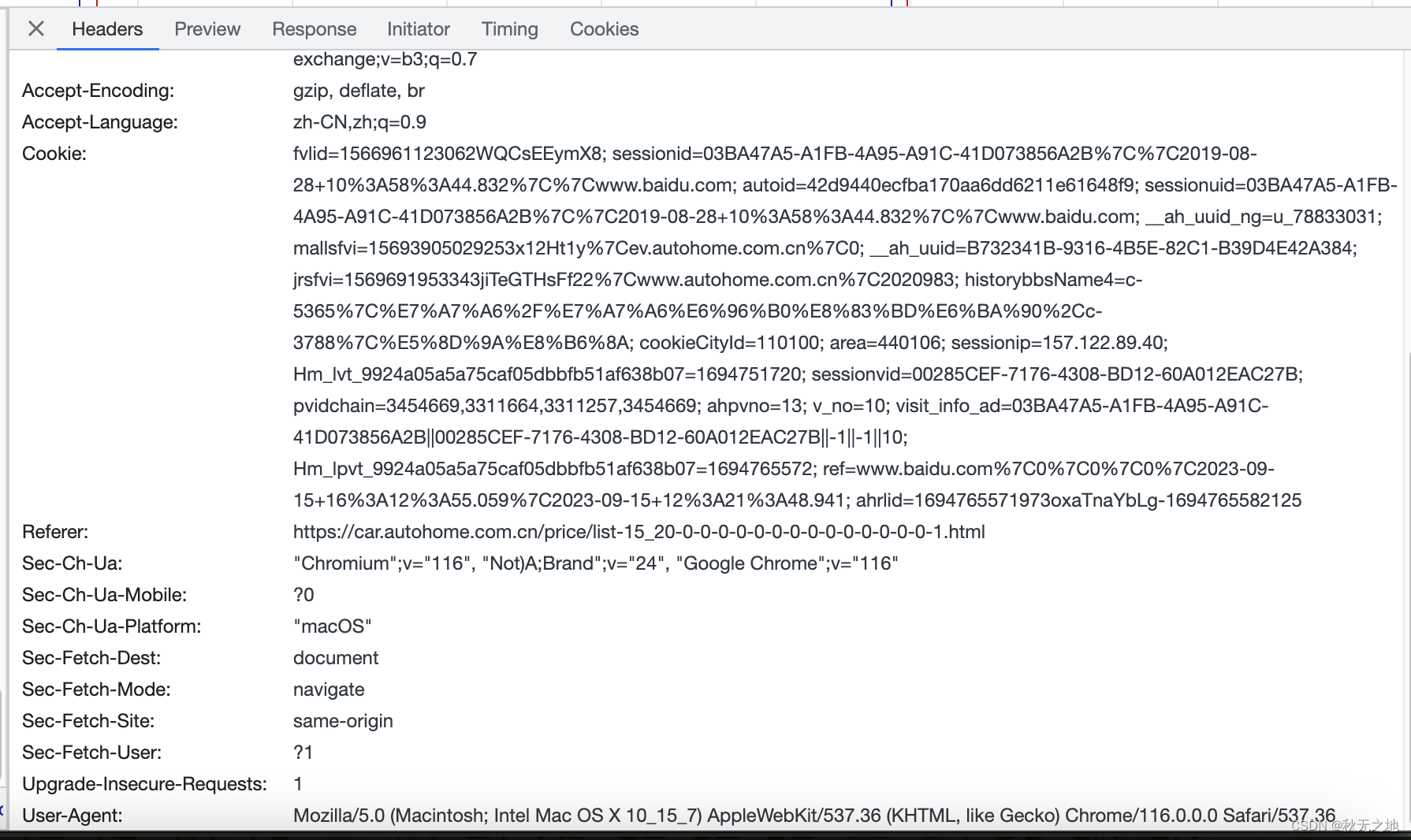

3、观察请求参数 1)header参数:没有加密数据,无需登录因此不用cookie

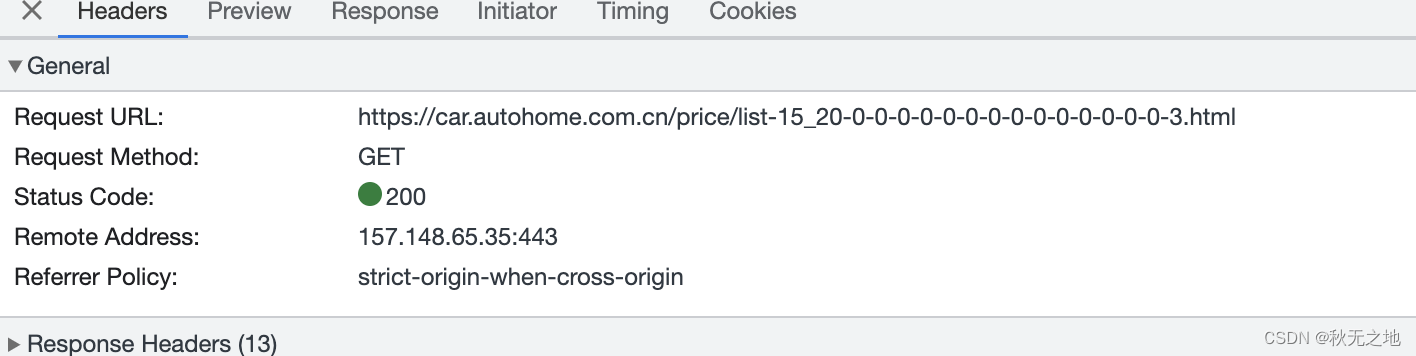

2)翻页:url参数变动了,0-1表示第一页,0-3表示第三页。

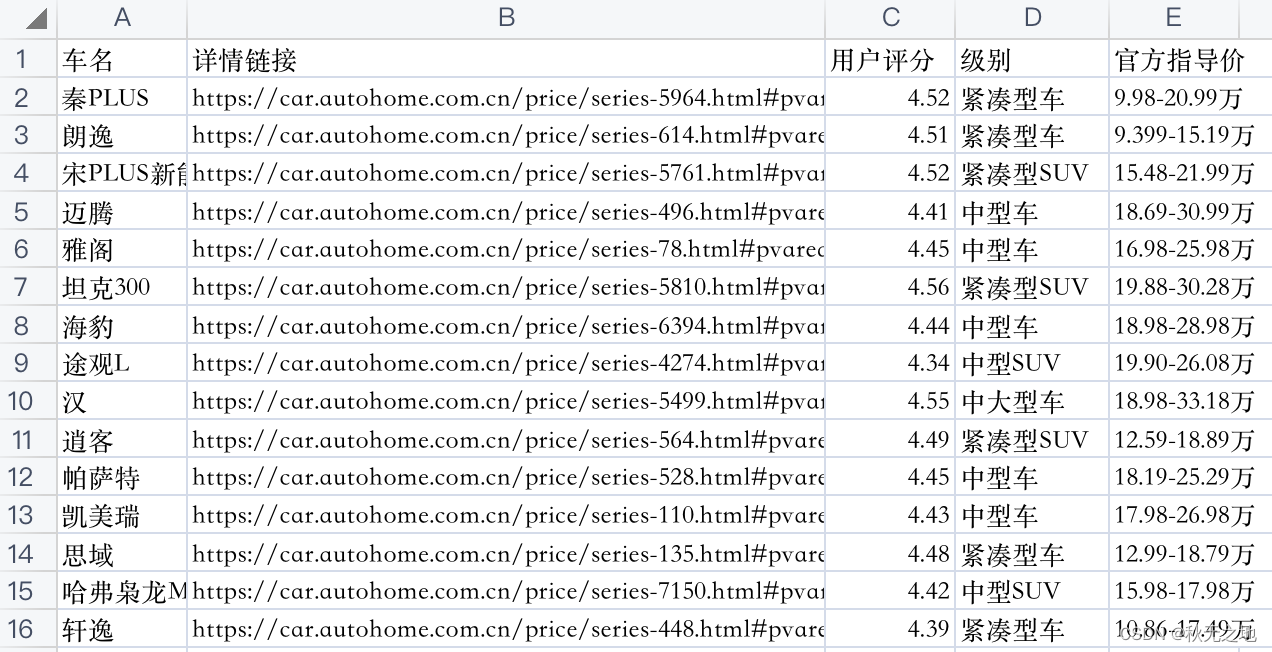

使用requests库请求接口,返回数据 def get_data(self,page=1): '''请求接口''' url = f"https://car.autohome.com.cn/price/list-15_20-0-0-0-0-0-0-0-0-0-0-0-0-0-0-{page}.html" res = requests.get(url=url, headers=self.header).text # print(res) #返回数据 if '用户评分' in res: return res else: return "" 三、数据解析将返回的数据进行正则匹配,然后通过遍历提取目标数据 def data_deal(self,data_text=None): '''数据解析''' new_list = [] #详情链接+车名 url_name_li = re.findall(r'(.*?)',data_text) #用户评分 score_number_li = re.findall(r'(.*?)',data_text) #级别 info_gray_li = re.findall(r'别:(.*?)',data_text) #官方指导价 price_li = re.findall(r'指导价:(.*?)',data_text) for i in range(len(url_name_li)): url_id1,url_id2,car_name = url_name_li[i] # 详情链接 info_url = f'https://car.autohome.com.cn/price/series-{url_id1}.html#pvareaid={url_id2}' # 用户评分 score_number = score_number_li[i] # 级别 info_gray = info_gray_li[i] # 官方指导价 price = price_li[i] new_list.append([car_name,info_url,score_number,info_gray,price]) return new_list 四、数据存储数据解析后,对数据进行拼接,然后持久化,存在csv文件 def data_to_csv(self,data_li=None): '''数据存储''' df = pd.DataFrame(data_li) df.to_csv("test2.csv", index=False)文件内容:

完整代码如下: # -*- coding: utf-8 -*- import math import re import requests import pandas as pd class Car_home_class(): '''汽车之家''' def __init__(self): self.header = { "User-Agent":"Mozilla/5.0 (Macintosh; Intel Mac OS X 10_15_7) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/116.0.0.0 Safari/537.36", "Referer":"https://car.autohome.com.cn/price/list-15_20-0-0-0-0-0-0-0-0-0-0-0-0-0-0-1.html", } def get_data(self,page=1): '''请求接口''' url = f"https://car.autohome.com.cn/price/list-15_20-0-0-0-0-0-0-0-0-0-0-0-0-0-0-{page}.html" res = requests.get(url=url, headers=self.header).text # print(res) #返回数据 if '用户评分' in res: return res else: return "" def data_deal(self,data_text=None): '''数据解析''' new_list = [] #详情链接+车名 url_name_li = re.findall(r'(.*?)',data_text) #用户评分 score_number_li = re.findall(r'(.*?)',data_text) #级别 info_gray_li = re.findall(r'别:(.*?)',data_text) #官方指导价 price_li = re.findall(r'指导价:(.*?)',data_text) for i in range(len(url_name_li)): url_id1,url_id2,car_name = url_name_li[i] # 详情链接 info_url = f'https://car.autohome.com.cn/price/series-{url_id1}.html#pvareaid={url_id2}' # 用户评分 score_number = score_number_li[i] # 级别 info_gray = info_gray_li[i] # 官方指导价 price = price_li[i] new_list.append([car_name,info_url,score_number,info_gray,price]) return new_list def data_to_csv(self,data_li=None): '''数据存储''' df = pd.DataFrame(data_li) df.to_csv("test2.csv", index=False) def run(self): # 翻页获取数据 all_list = [] all_list.append(["车名", "详情链接", "用户评分", "级别", "官方指导价"]) #爬取10页 for page in range(1,2): print("当前页数:",page) data_text = self.get_data(page=page) out_date = self.data_deal(data_text=data_text) print("*"*100) print(out_date) all_list += out_date self.data_to_csv(data_li=all_list) if __name__ == '__main__': ddc = Car_home_class() ddc.run() 六、总结Python爬虫主要分三步: 请求接口数据解析数据存储 版权声明本文章版权归作者所有,未经作者允许禁止任何转载、采集,作者保留一切追究的权利。 |

【本文地址】

公司简介

联系我们