| COVID | 您所在的位置:网站首页 › 新型冠状病毒对人们生活的影响英文作文高中 › COVID |

COVID

|

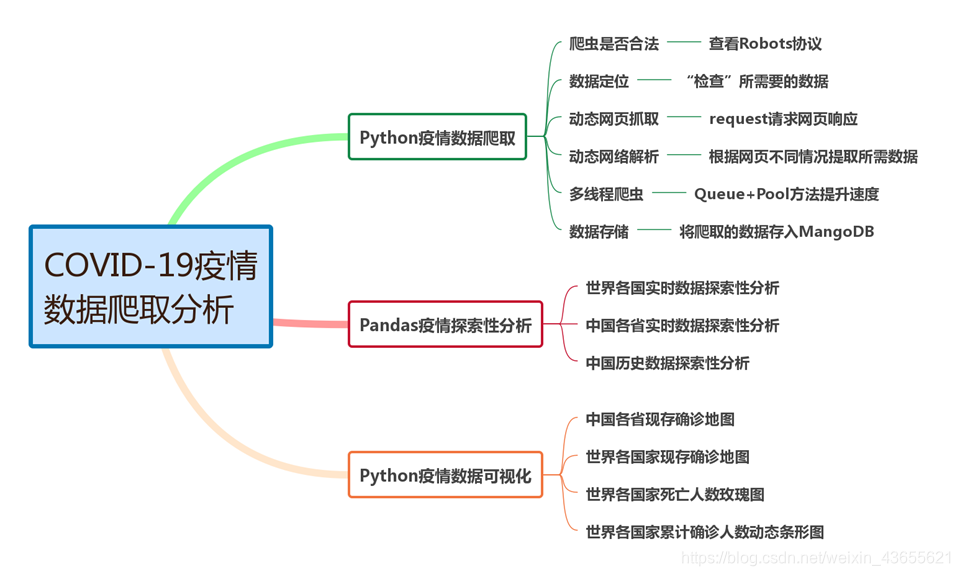

新型冠状病毒感染的肺炎疫情爆发后,对人们的生活产生很大的影响。 现特对COVID-19疫情实时数据和历史数据进行爬取、分析、可视化展示。 设计框架

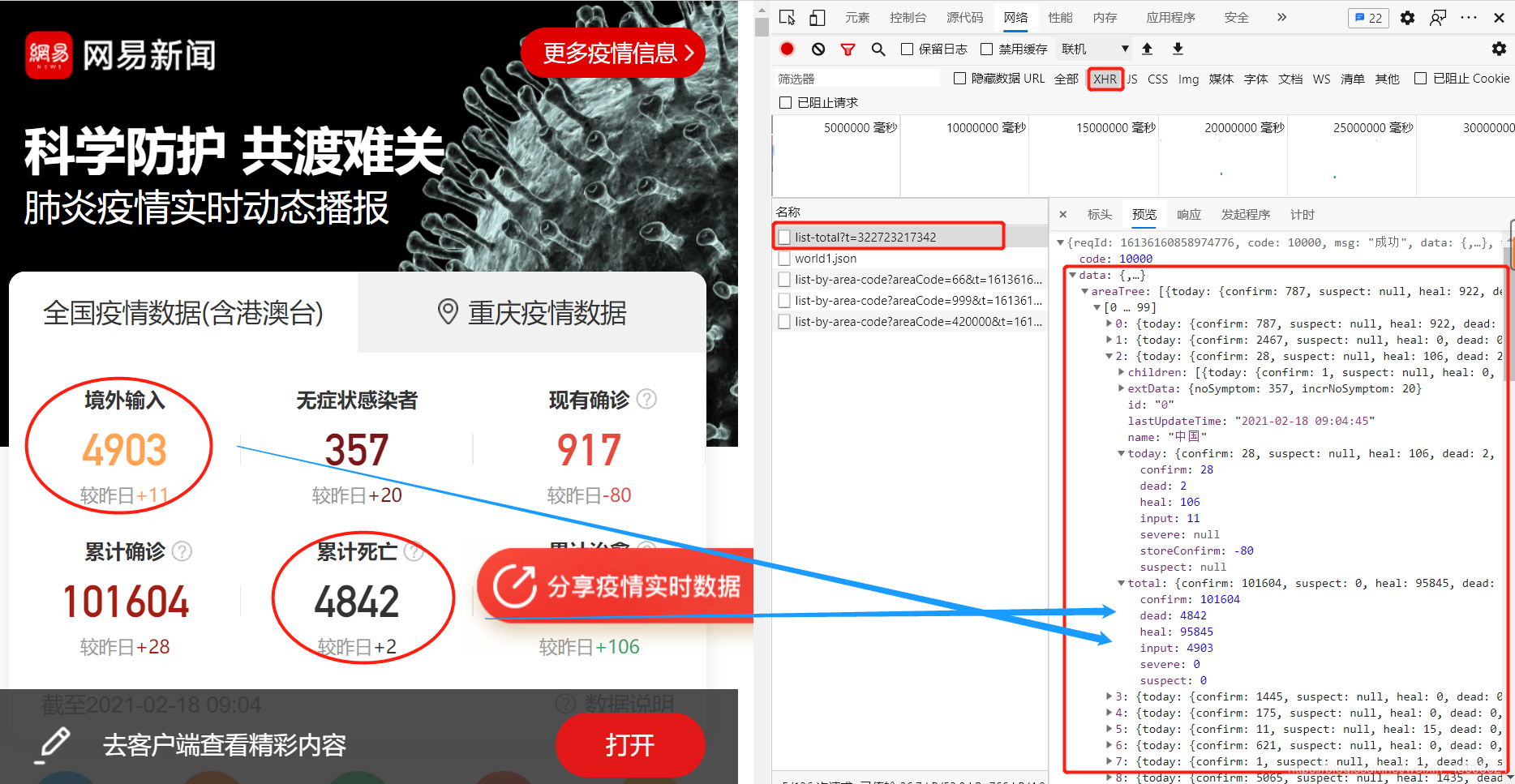

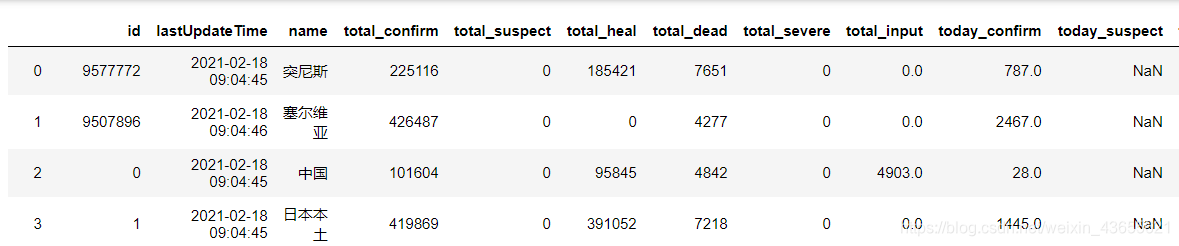

选择网易的疫情实时动态播报平台作为数据源,地址:https://wp.m.163.com/163/page/news/virus_report/index.html?nw=1&anw=1 导入相关库 import pandas as pd import requests import time pd.set_option('max_rows',500) # 显示500行数据 # 设置请求头,伪装为浏览器 headers = { 'user-agent':'Mozilla/5.0 (Windows NT 10.0; Win64; x64) AppleWebKit/537.36 (KHTML, like Gecko) Chrome/86.0.4240.198 Safari/537.36 Edg/86.0.622.69' } # 发送请求 url = 'https://c.m.163.com/ug/api/wuhan/app/data/list-total' # 定义要访问的地址 r = requests.get(url,headers = headers) # 使用requests发起请求 # 查看请求状态 r.status_code 200响应码为200,说明页面正常响应成功! print(type(r.text)) #查看类型。 r.text——文本获取 print(len(r.text)) # 查看文本长度返回后的内容是一个30万长度的字符串,因字符串格式不方便进行分析,并且在网页预览中发现数据为类似字典的json格式,所以这里将其转为json格式。 import json data_json = json.loads(r.text) # 按照json格式读取 data_jsondata中存放着我们所需要的网页数据 数据中有四个键,每个键值含义不同

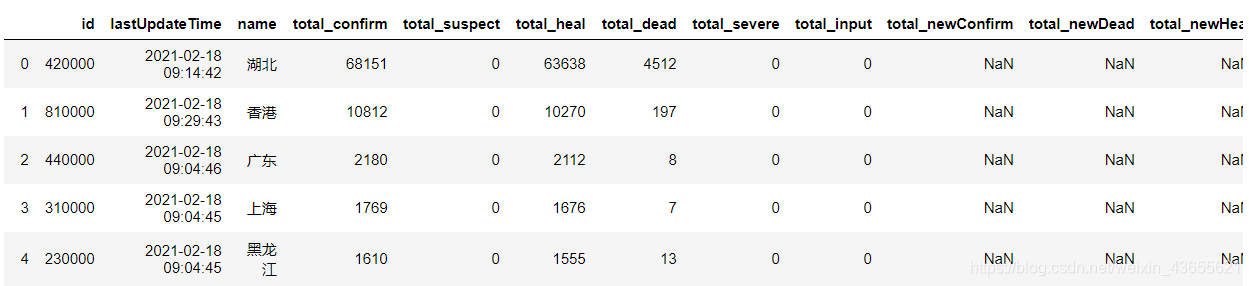

在爬取各省历史数据的过程中,发现参数aeraCode=420000,而这刚好和全国各省实时数据today_province中的id对应,即更改爬取的URL中的aeraCode参数就可爬取不同省市的历史数据。 # 将各省行政区号和各省名称按照字典形式对位 province_dict = { num:name for num,name in zip(today_province['id'],today_province['name'])} start = time.time() for province_id in province_dict: # 遍历各省编号 try: # 按照省编号访问每个省的数据地址,并获取json数据 url = 'https://c.m.163.com/ug/api/wuhan/app/data/list-by-area-code?areaCode='+province_id r = requests.get(url, headers=headers) data_json = json.loads(r.text) # 提取各省数据,然后写入各省名称 province_data = get_data(data_json['data']['list'],['date']) province_data['name'] = province_dict[province_id] # 合并数据 if province_id == '420000': alltime_province = province_data else: alltime_province = pd.concat([alltime_province,province_data]) print('-'*20,province_dict[province_id],'成功', province_data.shape,alltime_province.shape, ',累计耗时:',round(time.time()-start),'-'*20) # 设置延迟等待 time.sleep(20) except: print('-'*20,province_dict[province_id],'wrong','-'*20) -------------------- 湖北 成功 (396, 16) (396, 16) ,累计耗时: 1 -------------------- -------------------- 香港 成功 (396, 16) (792, 16) ,累计耗时: 21 -------------------- -------------------- 广东 成功 (394, 16) (1186, 16) ,累计耗时: 42 -------------------- -------------------- 上海 成功 (380, 16) (1566, 16) ,累计耗时: 63 -------------------- -------------------- 黑龙江 成功 (385, 16) (1951, 16) ,累计耗时: 83 -------------------- -------------------- 浙江 成功 (392, 16) (2343, 16) ,累计耗时: 103 -------------------- -------------------- 河北 成功 (387, 16) (2730, 16) ,累计耗时: 124 -------------------- -------- |

【本文地址】

公司简介

联系我们