| 知识推理算法总结 | 您所在的位置:网站首页 › 基于神经网络的知识推理 › 知识推理算法总结 |

知识推理算法总结

|

前言:

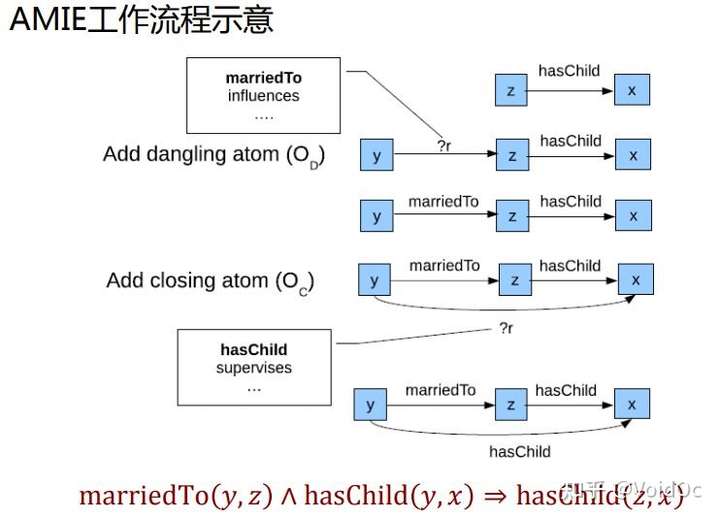

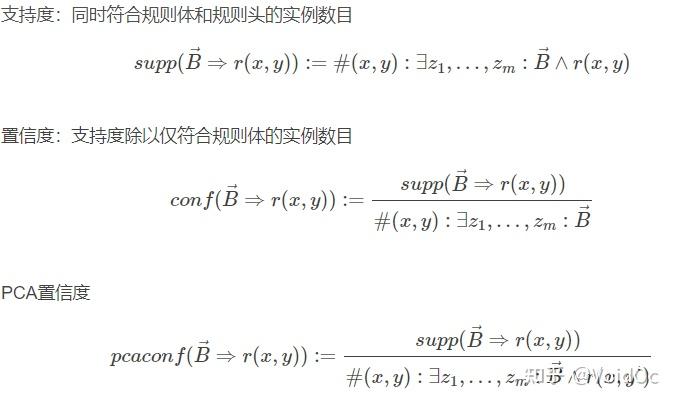

【知识图谱】知识图谱(一)—— 综述142 赞同 · 12 评论文章 一、知识推理概念介绍面向知识图谱的推理主要围绕关系的推理展开,即基于图谱中已有的事实或关系推断出未知的事实或关系,一般着重考察实体、关系和 图谱结构三个方面的特征信息。具体来说,知识图谱推理主要能够辅助推理出新的事实、新的关系、新的公理以及新的规则等。 推理任务主要有:通过规则挖掘对知识图谱进行补全(Knowledge Base Completion,KBC)与质量校验、链接预测、关联关系推理与冲突检测等。 主要的方法包含基于逻辑规则的推理、基于图结构的推理、基于分布式表示学习的推理、基于神经网络的推理以及混合推理。 目前主要发展趋势是提升规则挖掘的效率和准确度,用神经网络结构的设计代替在知识图谱上的离散搜索和随机游走是比较值得关注的方向。 二、知识推理方法 2.1 基于规则的推理基于规则的推理通过定义或学习知识中存在的规则进行挖掘与推理,从早期的ILP(Inductive Logic Programming)系统中衍生的AMIE、AMIE+算法, 强调通过自动化的规则学习方法,快速有效的从大规模知识图谱中学习出置信度较高的规则,并且应用于推理任务。 AMIEAMIE算法的全称是基于不完备知识库的关联规则挖掘算法(Association Rule Mining under Incomplete Evidence),通过依次学习预测每种关系的规则:对于每种关系,从规则体为空的规则开始,通过三种操作扩展规则体部分,保留支持度大于阈值的候选(闭式)规则。这三种操作分别为: 添加悬挂边:悬挂边是指边的一端是一个未出现过的变量,而另一端(变量或常量)是在规则中出现过的 添加实例边:实例边与悬挂边类似,边的一端也是在规则中出现过的变量或常量,但另一端是未出现过的常量,也就是知识库中的实体 添加闭合边 :闭合边则是连接两个已经存在于规则中的元素(变量或常量)的边。 评估准则

评估准则

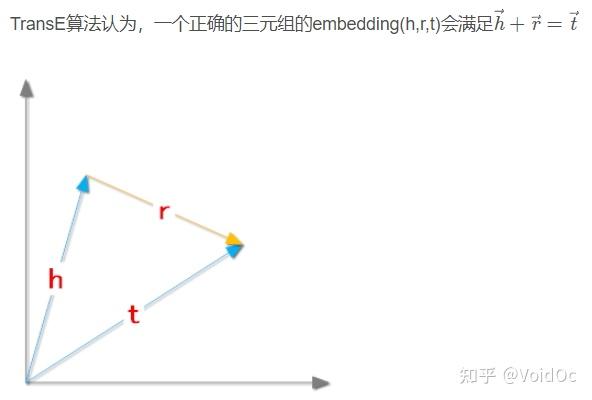

PRA是一种将关系路径作为特征的推理算法,通常用于知识图谱中的链接预测任务。因为其获取的关系路径实际上对应一种霍恩子句,PRA 计算的路径特征可以转换为逻辑规则,便于人们发现和理解知识图谱中隐藏的知识。 PRA 的基本思想是通过发现连接两个实体的一组关系路径来预测实体间可能存在的某种特定关系。 PRA算法概述 特征抽取(生成并选择路径特征集合)方法:随机游走,广度优先搜索,深度优先搜索 特征计算(计算每个训练样例的特征值)方法:随机游走概率,布尔值(出现/不出现),出现频次/概率 分类器训练(根据训练样例,为每个目标关系训练一个分类器)方法: 单任务学习(为每个关系单独训练二分类器); 多任务学习(不同关系联合学习) 优点: 一是可解释性强; 二是自动发现推理规则。 缺点: 一是处理低频关系效果不好; 二是处理低连通图(数据稀疏情况)的效果不好; 三是当图足够大时,路径抽取工作比较费时。 2.3 基于分布式表示学习的推理基于表示学习的方法的中心思想是找到一种映射函数,将符号表示映射到向量空间进行数值表示,从而减少维数灾难,同时捕捉实体和关系之间的隐式关联,重点是可以直接计算且计算速度快。 常见的方法有:TransE(Translating Embedding)系列算法、RESCAL、DistMul等,可用于下游任务如节点分类、链接预测等。 TransE转移距离模型(Translational Distance Model)的主要思想是将衡量向量化后的知识图谱中三元组的合理性问题,转化成衡量头实体和尾实体的距离问题。这一方法的重点是如何设计得分函数,得分函数常常被设计成利用关系把头实体转移到尾实体的合理性的函数。 受词向量的启发,由词与词在向量空间的语义层面关系,可以拓展到知识图谱中头实体和尾实体在向量空间的关系。也就是说,同样可以 考虑把知识图谱中的头实体和尾实体映射到向量空间中,且它们之间的 联系也可以考虑成三元组中的关系。 TransE便是受到了词向量中平移不变性的启发,在 TransE 中,把实体和关系都表示为向量,对于某一 个具体的关系(head, relation, tail),把关系的向量表示解释成头实体的向量到尾实体的向量的转移向量(Translation vector)。也就是说, 如果在一个知识图谱中,某一个三元组成立,则它的实体和关系需要满 足关系head+relation≈tail。

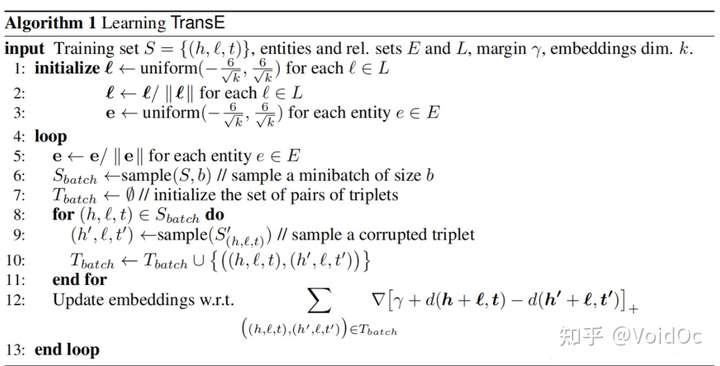

给定一个三元组集合 \(S\) ,每个三元组表示为 \((h, l, t)\) , \(h,t\) 属于实体集 \(E\) ,对应的 embedding 表示为 \((\boldsymbol{h}, \boldsymbol{l}, \boldsymbol{t})\) ,满足 \(\boldsymbol{h}+\boldsymbol{l}=\boldsymbol{t}\) 。 定义距离公式为: \[d(\boldsymbol{h}, \boldsymbol{l}, \boldsymbol{t})=||\boldsymbol{h}+\boldsymbol{l}-\boldsymbol{t}||_2^2 \]定义损失函数: \[\mathcal L=\sum_{(h,l,t)\in S}\sum_{(h',l',t')\in S'{(h,l,t)}}[\gamma+d(\boldsymbol{h}+\boldsymbol{l},\boldsymbol{t})-d(\boldsymbol{h}'+\boldsymbol{l},\boldsymbol{t}')]_+ \]其中, \([x]_+\) 表示大于 0 取原值,小于 0 取 0。 \[S'_{(h,l,t)}=\{(h',l,t)|h'\in E\}\cup \{(h,l,t')|t'\in E\} \]上式表示被破坏的三元组,其中 head 实体或者 tail 实体被随机实体替换作为对照组。 训练模型时,期望原三元组损失函数更小,被破坏的三元组损失函数更大。 伪代码

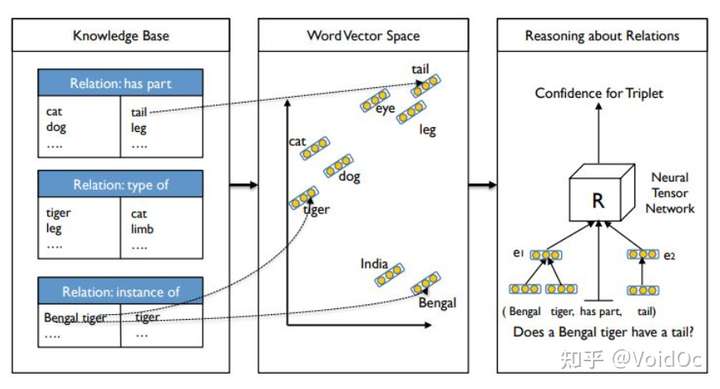

2013年提出的也比较老,NTN模型实现的,就是针对给定确定两个实体 \((e_1, e_2)\) ( \(e_1, e_2 \in R^d\) 是实体的向量表示),找出是否有一个确定的关系 \(R\) ,并给出可能性分数。 具体公式如下: \[g(e_1, R, e_2)=u^T_Rf(e_1^TW_R^{[1:k]}e_2+V_R [{e_1 e_2}]+b_R \]NTN使用一个bilinear tensor layer替换标准线性神经网络来直接关联两个实体向量。这个模型计算两个实体存在某个关系的可能性的分数。可以对接的下游任务有关系预测、知识库补全等。

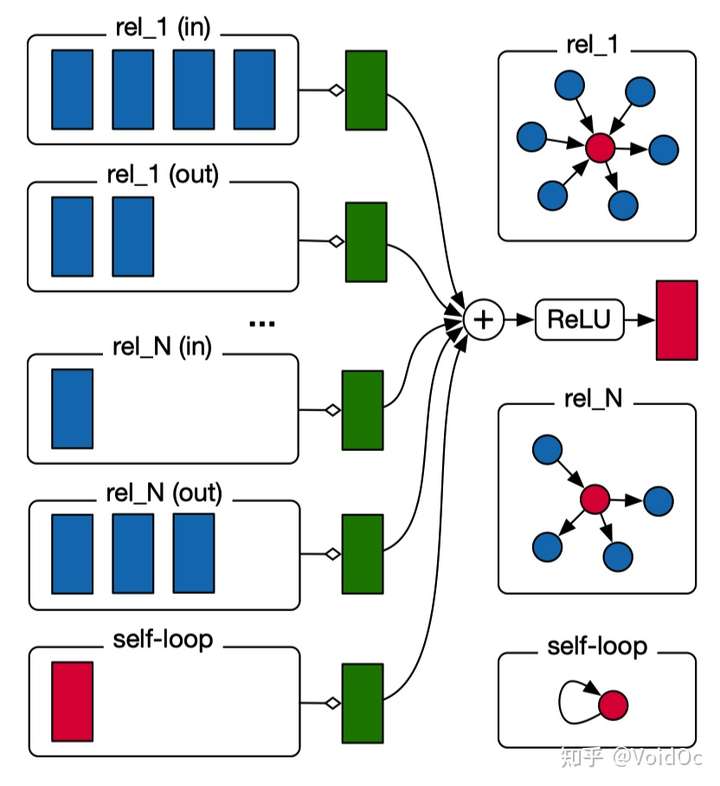

这个算法是来自阿姆斯特丹大学 Michael Schlichtkrull 大佬和 Thomas N. Kipf 大佬于 2017 年合作的一篇论文《Modeling Relational Data with Graph Convolutional Networks》。主要有两大突破: 证明了 GCN 可以应用于关系网络中,特别是关系预测和实体分类中; 引入权值共享和系数约束的方法使得 R-GCN 可以应用于关系众多的网络中。模型整体结构长这样,与常规GCN不同,它引入了由边的类型与方向决定的关系转换,+的后一项表示节点的自连接。红色部分为实体,与蓝色的邻居节点进行矩阵运算,再对每种关系的边类型进行转换,得到绿色部分的已做归一化处理的结果和,累加后经过激活函数传出,并更新模型的节点参数。

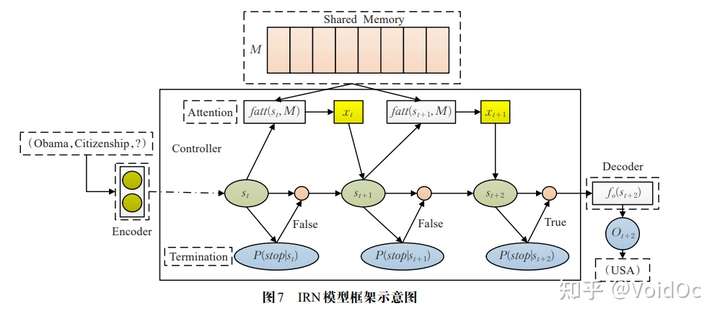

为了模仿人脑对知识的存储能力,Shen等人于2017提出隐性推理网 IRN(Implicit ReasoNets)模型。该模型设 计了一个共享记忆组件来隐式地存储知识库信息,以此模仿人脑对知识的存储。区别于常用推理方法中人工设计推理过程来显性地操纵观察到的三元组,该方法在没有人为干预的情况下能够通过对共享记忆组件的读取来隐式地学习多步推理过程,模拟了人脑在进行推理判断时读取记忆的过程。

该模型在预测过程中需要先后形成多个中间表示,针对每次生成的中间表示,使用 一个RNN控制器来判断该中间表示是否已经编码了足够多的信息用于产生输出预测。如果控制器允许,则输出当前预测作为最终结果。否则,控制器获取当前的中间表示并读取共享记忆组件,将两者的信息合并而成一组上下文向量以产生新的中间表示,然后重复执行上述判断过程,直到控制器允许停止该过程,此时即可输出预测结果。IRN模型框架示意图如图所示:

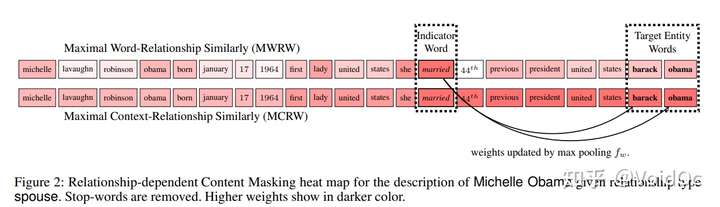

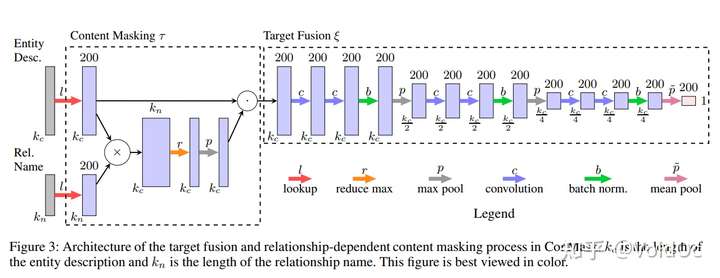

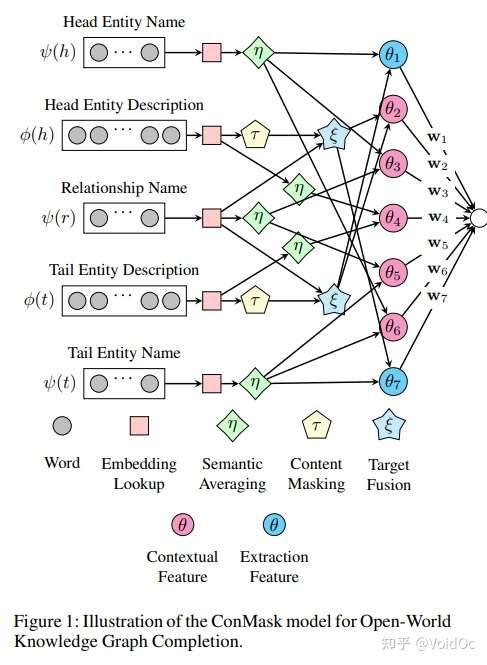

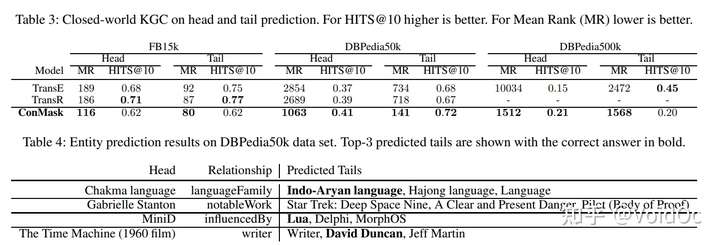

代码链接:https://github.com/bxshi/ConMask 通过利用知识库中已存在的实体和关系进行知识图谱补全, 我们定义为“Closed-World KGC”,即 “封闭世界知识图谱补全”:此类知识图谱补全方法严重依赖现有知识图谱连接,难以处理知识图谱外部加入的新实体。 为了能够应对知识图谱外部的未知新实体, Shi 等人于2018年《Open world Knowledge Graph Completion》论文中进一步定义了“开放世界知识图谱补全”,该类方法可以接收知识库外部实体并将其链接到知识图谱。基于上述思想提出 ConMask 模型,该模型主要分为三部分操作: 依赖于关系的内容遮蔽(Relationship-dependent content masking):筛选文本信息,删去无关信息,仅留下与任务有关的内容,其中模型采用attention机制基于相似度得到上下文的词和给定关系的词的权重矩阵,通过观察发现目标实体有时候在权重高的词(indicator words)附近,提出 MCRW 考虑了上下文的权重求解方法。 目标融合(Target fusion):使用全卷积神经网络从相关文本抽取目标实体的embedding(用FCN即全卷积神经网络的方法);这个部分输入是masked content matrix,每层先有两个 1-D 卷积操作,再是sigmoid激活函数,然后是 batch normalization,再是最大池化。FCN的最后一层接的是均值池化而不是最大池化,以确保目标融合层的输出始终返回单个k维嵌入。

目标融合(Target fusion):使用全卷积神经网络从相关文本抽取目标实体的embedding(用FCN即全卷积神经网络的方法);这个部分输入是masked content matrix,每层先有两个 1-D 卷积操作,再是sigmoid激活函数,然后是 batch normalization,再是最大池化。FCN的最后一层接的是均值池化而不是最大池化,以确保目标融合层的输出始终返回单个k维嵌入。 目标实体解析(Target entity resolution):生成候选实体和抽取实体嵌入之间的相似度排名,通过计算KG中候选实体和抽取实体embedding的相似度,结合其他文本特征得到一个ranked list,rank最高的认为是最佳结果。并设计了一个损失函数list-wise rankign,采样时按50%的比例替换head和tail生成负样本以增强模型鲁棒性。

目标实体解析(Target entity resolution):生成候选实体和抽取实体嵌入之间的相似度排名,通过计算KG中候选实体和抽取实体embedding的相似度,结合其他文本特征得到一个ranked list,rank最高的认为是最佳结果。并设计了一个损失函数list-wise rankign,采样时按50%的比例替换head和tail生成负样本以增强模型鲁棒性。

综上,整体ConMask的模型结构如下

我不展开写了,感兴趣可以参考OpenKG论坛这篇:论文浅尝 | 用增强学习进行推理:问答与知识库完善(KBC) DeepPath的动作是“事实判断”(fact prediction),即确定一个三元组是否成立。 作者将“事实判断”看作是这样一个问题:寻找一条能连接已知头实体h和尾实体t的路径,并将此问题建模为序列决策问题,并利用基于策略梯度的强化学习方法REINFORCE求解。 DeepPath代码(torch):https://github.com/xwhan/DeepPath 而MINERVA的动作是“查询问答”(QA),“查询问答”无法预知答案对应的尾实体,需要从知识图谱的全部实体中寻找可作为答案的正确尾实体。为了解决这样一个 POMDP 过程,作者将观测序列和历史决策序列用 LSTM 建模表示,使得其的表现远远超过了非增强学习的基于随机游走的模型。 MINERVA代码:https://github.com/shehzaadzd/MINERVA/blob/master/code/model/baseline.py 优点:强化学习方法相比基于表示学习的方法,有更好的可解释性和推理效果。 缺点:动作空间比较大,训练代价大 三、总结

|

【本文地址】

代码实现

关于Trans系列模型的演变与相关论文可以参考这篇文章

代码实现

关于Trans系列模型的演变与相关论文可以参考这篇文章 使用NTN预测新的关系代码实现

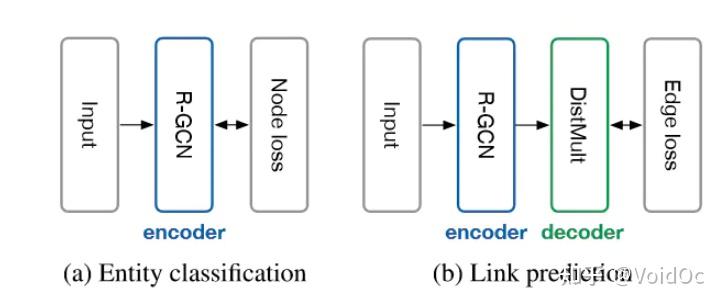

使用NTN预测新的关系代码实现 针对实体分类来说,只使用了堆叠的 R-GCN 并在最后一层叠加了一个 Softmax 层用于分类;针对关系预测(链接预测)作者考虑使用 DistMult 分解作为评分函数,并使用负采样的训练方式:对于观测样本,考虑ω 个负样本,并利用交叉熵损失进行优化。结构分别如下图:

针对实体分类来说,只使用了堆叠的 R-GCN 并在最后一层叠加了一个 Softmax 层用于分类;针对关系预测(链接预测)作者考虑使用 DistMult 分解作为评分函数,并使用负采样的训练方式:对于观测样本,考虑ω 个负样本,并利用交叉熵损失进行优化。结构分别如下图:

关系预测的准确性比较:

关系预测的准确性比较:

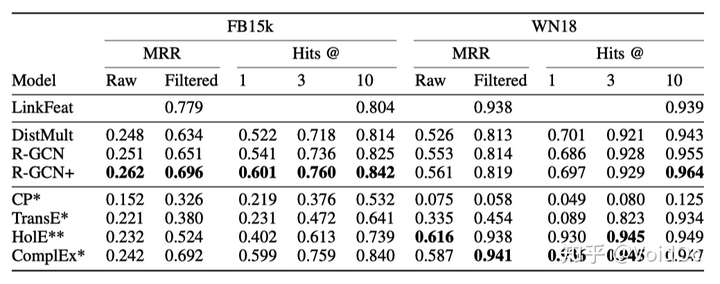

链接预测任务上的实验结果:

链接预测任务上的实验结果:

优点:能够应对知识图谱外部的未知新实体,适用于动态知识图谱的知识推理。

缺点:由于 ConMask 模型从文本中获取信息,因此,当未出现能够准确描述实体或关系的文本时,模型无法获取足够的推理依据,推理效果不佳。

优点:能够应对知识图谱外部的未知新实体,适用于动态知识图谱的知识推理。

缺点:由于 ConMask 模型从文本中获取信息,因此,当未出现能够准确描述实体或关系的文本时,模型无法获取足够的推理依据,推理效果不佳。