| 四种常见激活函数 | 您所在的位置:网站首页 › 写出四种常见的外部设备及其作用 › 四种常见激活函数 |

四种常见激活函数

|

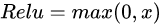

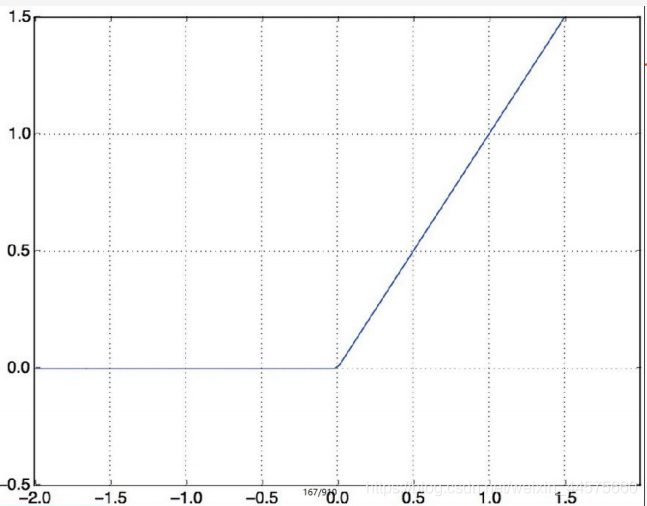

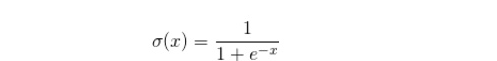

原文 1、relu函数Relu激活函数的解析式 Sigmoid激活函数的解析式

sigmoid函数也叫Logistic函数,用于隐藏层的输出,输出在(0,1)之间,它可以将一个实数映射到(0,1)的范围内,可以用来做二分类。常用于:在特征相差比较复杂或是相差不是特别大的时候效果比较好。该函数将大的负数转换成0,将大的正数转换为1。 sigmoid函数的缺点: (1)梯度消失:Sigmoid 函数趋近 0 和 1 的时候变化率会变得平坦,也就是说,Sigmoid 的梯度趋近于 0。神经网络使用 Sigmoid 激活函数进行反向传播时,输出接近 0 或 1 的神经元其梯度趋近于 0。这些神经元叫作饱和神经元。因此,这些神经元的权重不会更新。此外,与此类神经元相连的神经元的权重也更新得很慢。该问题叫作梯度消失。因此,想象一下,如果一个大型神经网络包含 Sigmoid 神经元,而其中很多个都处于饱和状态,那么该网络无法执行反向传播。 (2)不以零为中心:Sigmoid 输出不以零为中心的。 (3)计算成本高昂:exp() 函数与其他非线性激活函数相比,计算成本高昂。 3、tanh函数tanh激活函数的解析式

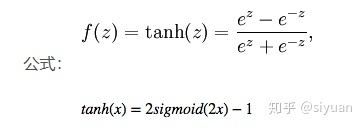

优点:它解决了Sigmoid函数的不是zero-centered输出问题。 缺点:梯度消失(gradient vanishing)的问题和幂运算的问题仍然存在。 为了解决梯度消失问题,我们来讨论另一个非线性激活函数——修正线性单元(rectified linear unit,ReLU),该函数明显优于前面两个函数,是现在使用最广泛的函数。 4、Leaky Relu函数Leaky Relu激活函数的解析式 优点:该函数一定程度上缓解了 dead ReLU 问题。 缺点: (1)使用该函数的结果并不连贯。尽管它具备 ReLU 激活函数的所有特征,如计算高效、快速收敛、在正区域内不会饱和。 (2)Leaky ReLU 可以得到更多扩展。不让 x 乘常数项,而是让 x 乘超参数,这看起来比 Leaky ReLU 效果要好。该扩展就是 Parametric ReLU。 |

【本文地址】

Relu函数及其导数的图像如下图所示:

Relu函数及其导数的图像如下图所示:  Relu激活函数优点: 当输入 x 0 时,输出为 x。该激活函数使网络更快速地收敛。它不会饱和,即它可以对抗梯度消失问题,至少在正区域(x> 0 时)可以这样,因此神经元至少在一半区域中不会把所有零进行反向传播。由于使用了简单的阈值化(thresholding),ReLU 计算效率很高。 Relu激活函数缺点: (1)不以零为中心:和 Sigmoid 激活函数类似,ReLU 函数的输出不以零为中心。 (2)前向传导(forward pass)过程中,如果 x < 0,则神经元保持非激活状态,且在后向传导(backward pass)中「杀死」梯度。这样权重无法得到更新,网络无法学习。当 x = 0 时,该点的梯度未定义,但是这个问题在实现中得到了解决,通过采用左侧或右侧的梯度的方式。

Relu激活函数优点: 当输入 x 0 时,输出为 x。该激活函数使网络更快速地收敛。它不会饱和,即它可以对抗梯度消失问题,至少在正区域(x> 0 时)可以这样,因此神经元至少在一半区域中不会把所有零进行反向传播。由于使用了简单的阈值化(thresholding),ReLU 计算效率很高。 Relu激活函数缺点: (1)不以零为中心:和 Sigmoid 激活函数类似,ReLU 函数的输出不以零为中心。 (2)前向传导(forward pass)过程中,如果 x < 0,则神经元保持非激活状态,且在后向传导(backward pass)中「杀死」梯度。这样权重无法得到更新,网络无法学习。当 x = 0 时,该点的梯度未定义,但是这个问题在实现中得到了解决,通过采用左侧或右侧的梯度的方式。 sigmoid函数及其导数的图像如下图所示:

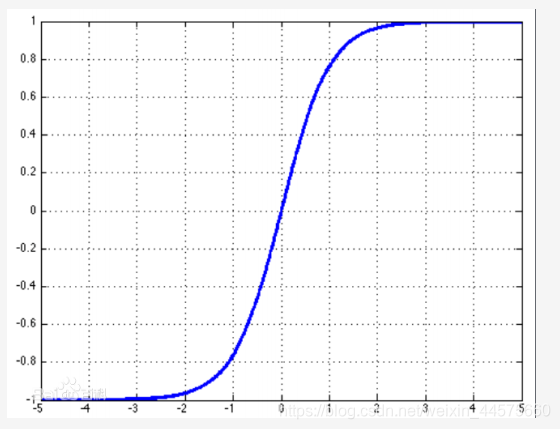

sigmoid函数及其导数的图像如下图所示:

tanh函数及其导数的图像如下图所示:

tanh函数及其导数的图像如下图所示: 与 Sigmoid 函数类似,Tanh 函数也使用真值,但 Tanh 函数将其压缩至-1 到 1 的区间内。与 Sigmoid 不同,Tanh 函数的输出以零为中心,因为区间在-1 到 1 之间。你可以将 Tanh 函数想象成两个 Sigmoid 函数放在一起。在实践中,Tanh 函数的使用优先性高于 Sigmoid 函数。负数输入被当作负值,零输入值的映射接近零,正数输入被当作正值。

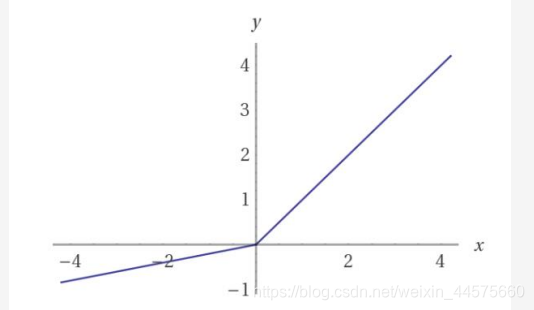

与 Sigmoid 函数类似,Tanh 函数也使用真值,但 Tanh 函数将其压缩至-1 到 1 的区间内。与 Sigmoid 不同,Tanh 函数的输出以零为中心,因为区间在-1 到 1 之间。你可以将 Tanh 函数想象成两个 Sigmoid 函数放在一起。在实践中,Tanh 函数的使用优先性高于 Sigmoid 函数。负数输入被当作负值,零输入值的映射接近零,正数输入被当作正值。 Leaky Relu函数及其导数的图像如下图所示:

Leaky Relu函数及其导数的图像如下图所示:  Leaky ReLU 的概念是:当 x < 0 时,它得到 0.01 的正梯度。

Leaky ReLU 的概念是:当 x < 0 时,它得到 0.01 的正梯度。