| StableDiffusion Optimization(显存优化 推理加速 xFormers、cuDNN) | 您所在的位置:网站首页 › vr需要多大显存 › StableDiffusion Optimization(显存优化 推理加速 xFormers、cuDNN) |

StableDiffusion Optimization(显存优化 推理加速 xFormers、cuDNN)

|

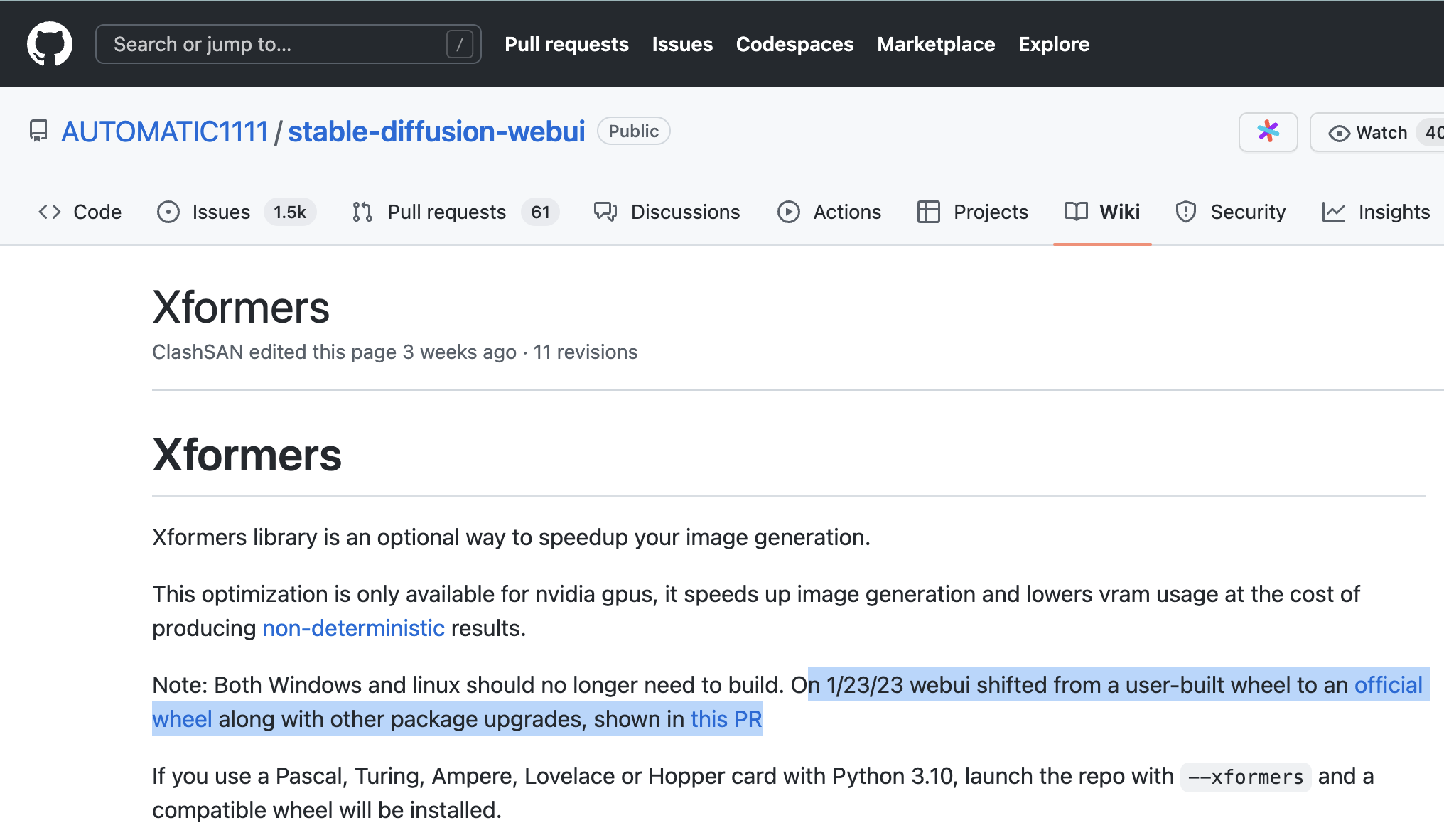

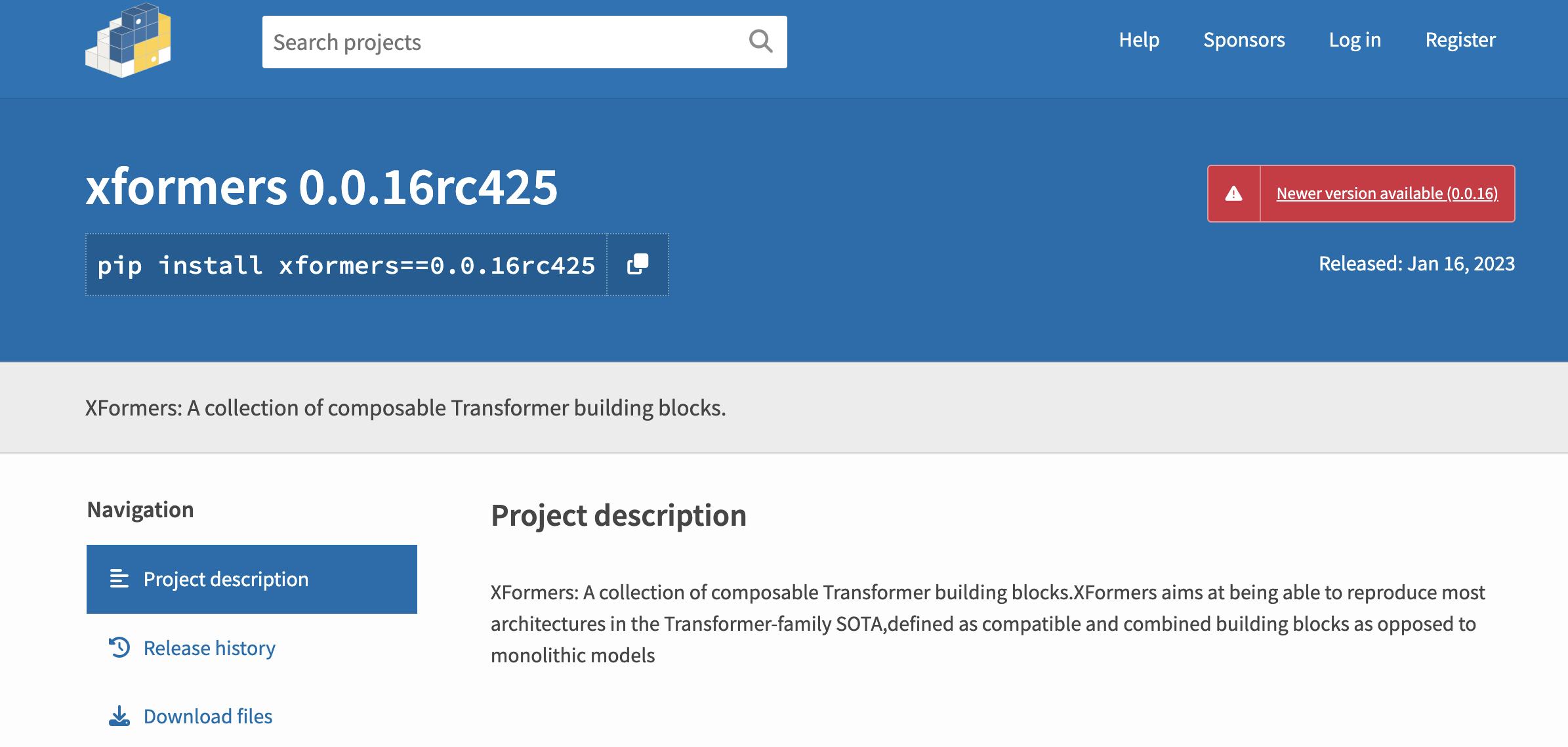

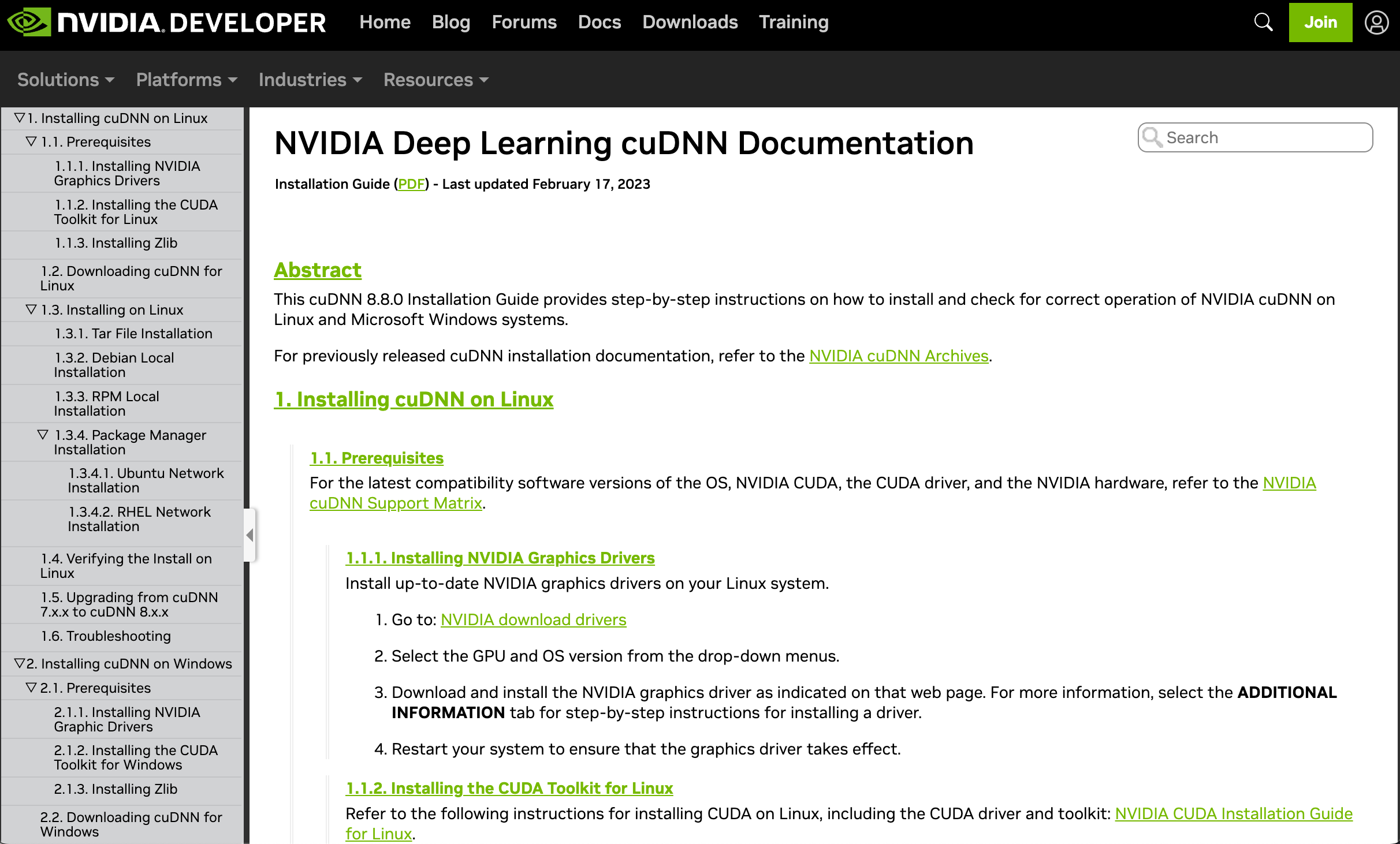

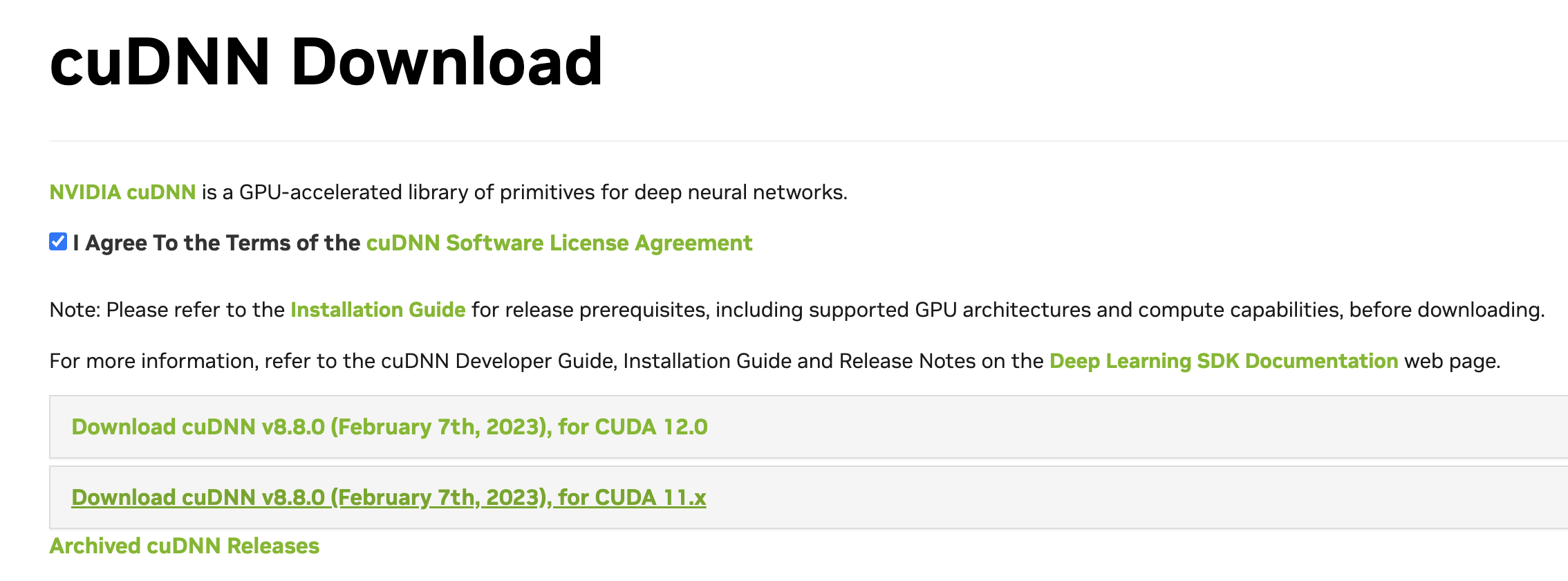

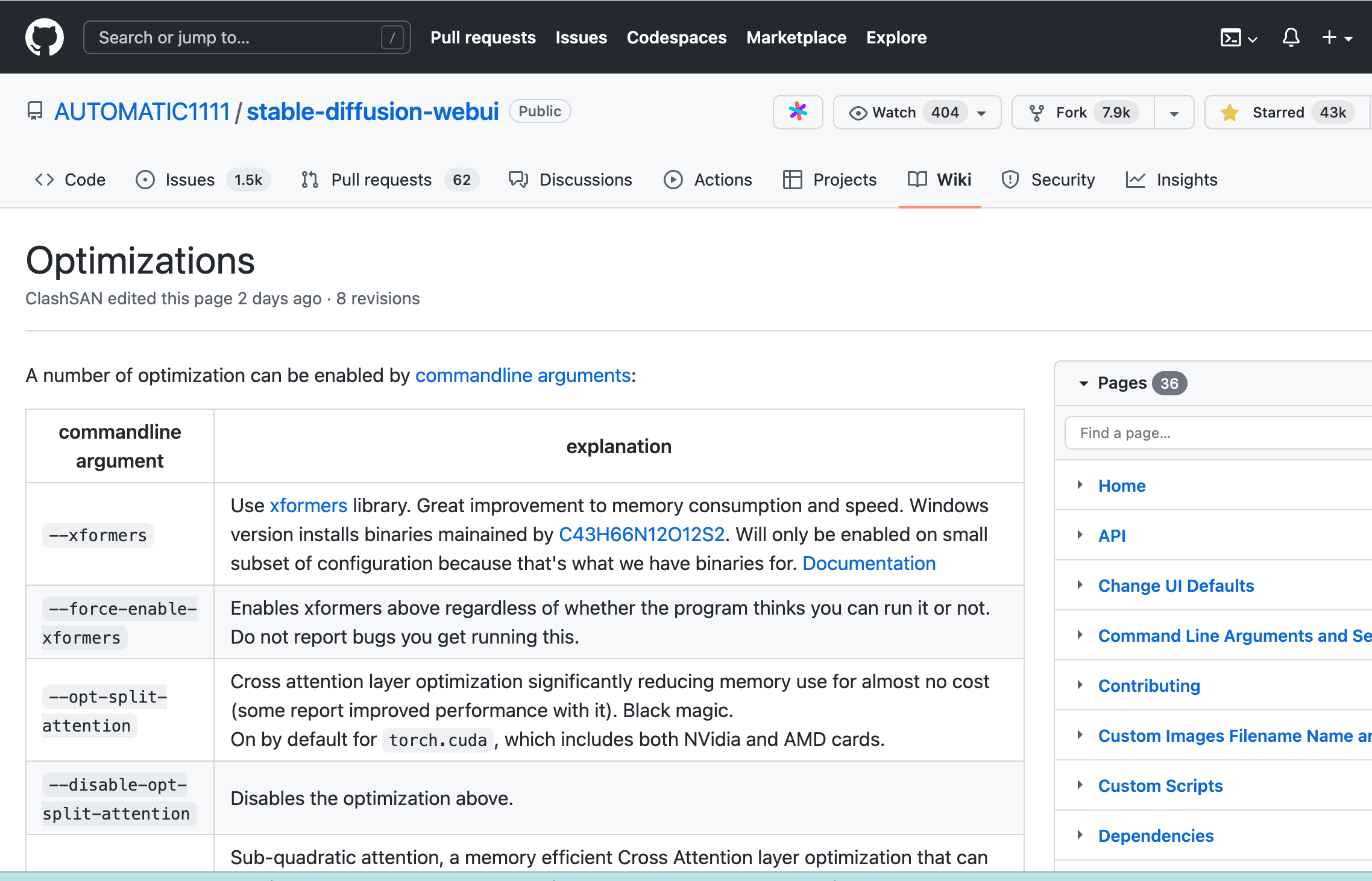

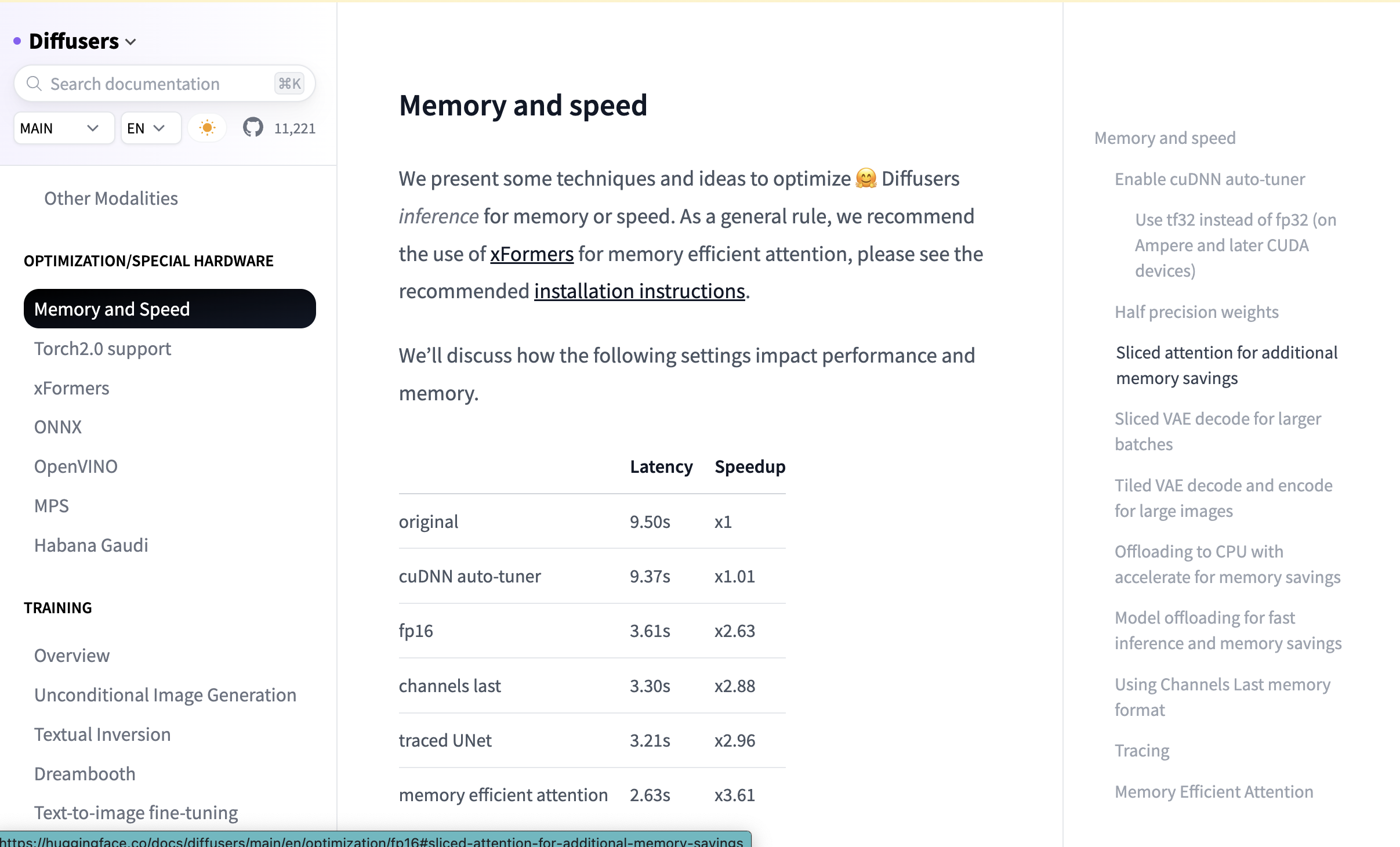

随着StableDiffusion的新技术越来越多,就算是3090、4090之类的24g大显存卡皇有时也遭不住各种模型在pytorch里横冲直撞.因此有必要进行适当的优化来减少显存占用并加速图片的推理生成. 本文将介绍目前主流的优化加速方案 其中会重点讲解下xFormer的下载使用 XformersXformers 应该是社区目前知名度最高的优化加速方案了,名字 Xformers 指的是该库将各种transformer架构的模型囊括其中. 该库仅适用于N卡,特点是加速图片生成并降低显存占用,代价是输出图像不稳定,有可能比不开Xformers略差 由于之前处于开发早期,需要手动编译,门槛较高,并不方便使用.但在今年1月23号, Stable Diffusion webUI 替换了所用的 Xformers 版本(PR链接) 、无论是Linux 还是 Windows ,现在仅需使用一行命令即可完成下载安装  下载安装 下载安装前置环境准备可以直接使用我之前制作好的镜像 在命令行输入 pip install xformers==0.0.16rc425 回车 (注意 :必须要带上0.0.16rc425 !!! 如果直接pip install xformers ,就算安装成功 到后面StableDiffusion WebUI时程序也不会认 ,算是一个坑 )  使用 使用在平常运行webUI的指令后加上 --xformers 即可让程序在运行时使用 xformers 来进行优化 示例运行指令: python webui.py --deepdanbooru --no-half --precision full --port 6006 --share --disable-safe-unpickle --xformers  cuDNN cuDNN适用于40系显卡(尤其是4090)针对性的加速方案 可以参考B站秋葉大佬的整合包教程 官方的下载安装文档地址(强烈建议阅读该文档,因为国内很多cuDNN教程都是先前版本的 照着来很容易出问题): https://docs.nvidia.com/deeplearning/cudnn/install-guide/index.html 英语不是很好的可以使用AI翻译和词典插件、具体教程见下方卡片链接:  下载cuDNN前会让你注册英伟达开发者账号、有一些表单要填、之后就会看到下面下载页、根据自己cuda版本和系统版本来选择  使用安装还请见官方文档: https://docs.nvidia.com/deeplearning/cudnn/install-guide/index.html 其他方案关于其他优化加速技巧、这里给出两个文档资料链接 供想要进一步探索的同学参考使用 stablediffusion webui的optimization wiki一个是stablediffusion webui的optimization wiki 这里会汇总一些预先设定好的加速选项, 通过启动命令中添加或改变参数来实现优化和调整 https://github.com/AUTOMATIC1111/stable-diffusion-webui/wiki/Optimizations  huggingface的Diffusers库文档的optimization huggingface的Diffusers库文档的optimization还有一个是huggingface的Diffusers库文档的optimization部分 这里会给出diffusers开发社区团队建议的一些加速思路 Memory and speed  渐进式更新中 更多相关文章见下方专栏 |

【本文地址】