| 4种常见的NLP实践思路分析 | 您所在的位置:网站首页 › nlp实战项目 › 4种常见的NLP实践思路分析 |

4种常见的NLP实践思路分析

|

越来越多的人选择参加算法赛事,为了提升项目实践能力,同时也希望能拿到好的成绩增加履历的丰富度。期望如此美好,现实却是:看完赛题,一点思路都木有。那么,当我们拿到一个算法赛题后,如何破题,如何找到可能的解题思路呢。 本文针对NLP项目给出了4种常见的解题思路,其中包含1种基于机器学习的思路和3种基于深度学习的思路。 一、数据及背景 https://tianchi.aliyun.com/competition/entrance/531810/information(阿里天池-零基础入门NLP赛事) 二、数据下载及分析2.1 获取数据 我们直接打开数据下载地址,看到的是这样一个页面:

接着就三步走:注册报名下载数据,查看数据前五行可以看到我们获得的数据如下:

其中左边的label是数据集文本对应的标签,而右边的text则是编码后的文本,文本对应的标签列举如下:

根据官方描述:赛题以匿名处理后的新闻数据为赛题数据,数据集报名后可见并可下载。赛题数据为新闻文本,并按照字符级别进行匿名处理。整合划分出14个候选分类类别:财经、彩票、房产、股票、家居、教育、科技、社会、时尚、时政、体育、星座、游戏、娱乐的文本数据。 赛题数据由以下几个部分构成:训练集20w条样本,测试集A包括5w条样本,测试集B包括5w条样本。为了预防选手人工标注测试集的情况,我们将比赛数据的文本按照字符级别进行了匿名处理。 同时我们还应该注意到官网有给出结果评价指标,我们也需要根据这个评价指标衡量我们的验证集数据误差:

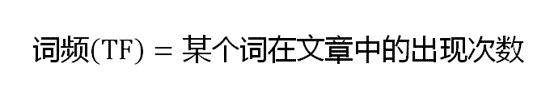

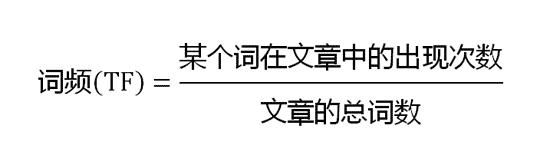

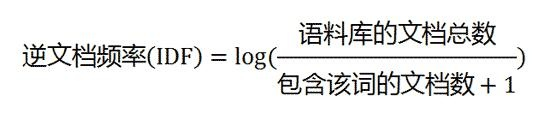

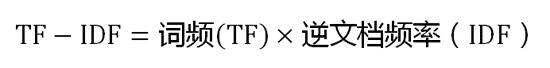

既然该拿到的我们都拿到了,我们接下来就开始构思我们都应该使用哪些思路来完成我们的预测。 2.2 常见思路 赛题本质是一个文本分类问题,需要根据每句的字符进行分类。但赛题给出的数据是匿名化的,不能直接使用中文分词等操作,这个是赛题的难点。 因此本次赛题的难点是需要对匿名字符进行建模,进而完成文本分类的过程。由于文本数据是一种典型的非结构化数据,因此可能涉及到特征提取和分类模型两个部分。为了减低参赛难度,我们提供了一些解题思路供大家参考: 思路1:TF-IDF + 机器学习分类器:直接使用TF-IDF对文本提取特征,并使用分类器进行分类。在分类器的选择上,可以使用SVM、LR、或者XGBoost。 思路2:FastText:FastText是入门款的词向量,利用Facebook提供的FastText工具,可以快速构建出分类器。 思路3:WordVec + 深度学习分类器:WordVec是进阶款的词向量,并通过构建深度学习分类完成分类。深度学习分类的网络结构可以选择TextCNN、TextRNN或者BiLSTM。 思路4:Bert词向量:Bert是高配款的词向量,具有强大的建模学习能力。 三、基于机器学习的文本分类 3.1 TF-IDF+机器学习分类器(思路1) 3.1.1. 什么是TF-IDF? TF-IDF(term frequency–inverse document frequency)是一种用于信息检索与数据挖掘的常用加权技术,常用于挖掘文章中的关键词,而且算法简单高效,常被工业用于最开始的文本数据清洗。 TF-IDF有两层意思,一层是"词频"(Term Frequency,缩写为TF),另一层是"逆文档频率"(Inverse Document Frequency,缩写为IDF)。 当有TF(词频)和IDF(逆文档频率)后,将这两个词相乘,就能得到一个词的TF-IDF的值。某个词在文章中的TF-IDF越大,那么一般而言这个词在这篇文章的重要性会越高,所以通过计算文章中各个词的TF-IDF,由大到小排序,排在最前面的几个词,就是该文章的关键词。 3.2.2. TF-IDF算法步骤 第一步,计算词频:

考虑到文章有长短之分,为了便于不同文章的比较,进行"词频"标准化:

第二步,计算逆文档频率: 这时,需要一个语料库(corpus),用来模拟语言的使用环境。

如果一个词越常见,那么分母就越大,逆文档频率就越小越接近0。分母之所以要加1,是为了避免分母为0(即所有文档都不包含该词)。log表示对得到的值取对数。 第三步,计算TF-IDF:

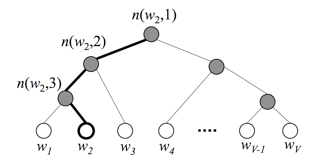

可以看到,TF-IDF与一个词在文档中的出现次数成正比,与该词在整个语言中的出现次数成反比。所以,自动提取关键词的算法就很清楚了,就是计算出文档的每个词的TF-IDF值,然后按降序排列,取排在最前面的几个词。 3.3.3. 优缺点 TF-IDF的优点是简单快速,而且容易理解。缺点是有时候用词频来衡量文章中的一个词的重要性不够全面,有时候重要的词出现的可能不够多,而且这种计算无法体现位置信息,无法体现词在上下文的重要性。如果要体现词的上下文结构,那么你可能需要使用word2vec算法来支持。 四、基于深度学习的文本分类 4.1 FastText(思路2) 4.1.1 FastText的核心思想 将整篇文档的词及n-gram向量叠加平均得到文档向量,然后使用文档向量做softmax多分类。这中间涉及到两个技巧:字符级N-gram特征的引入以及分层Softmax分类。 4.1.2字符级N-gram特征 N-gram是基于语言模型的算法,基本思想是将文本内容按照子节顺序进行大小为N的窗口滑动操作,最终形成窗口为N的字节片段序列。举个例子: 我来到达观数据参观 相应的bigram特征为:我来 来到 到达 达观 观数 数据 据参 参观 相应的trigram特征为:我来到 来到达 到达观 达观数 观数据 数据参 据参观 注意一点:n-gram中的gram根据粒度不同,有不同的含义。它可以是字粒度,也可以是词粒度的。上面所举的例子属于字粒度的n-gram,词粒度的n-gram看下面例子: 我 来到 达观数据 参观 相应的bigram特征为:我/来到 来到/达观数据 达观数据/参观 相应的trigram特征为:我/来到/达观数据 来到/达观数据/参观 n-gram产生的特征只是作为文本特征的候选集,你后面可能会采用信息熵、卡方统计、IDF等文本特征选择方式筛选出比较重要特征。 4.1.3 分层Softmax分类 softmax函数常在神经网络输出层充当激活函数,目的就是将输出层的值归一化到0-1区间,将神经元输出构造成概率分布,主要就是起到将神经元输出值进行归一化的作用。 下图是一个分层Softmax示例:

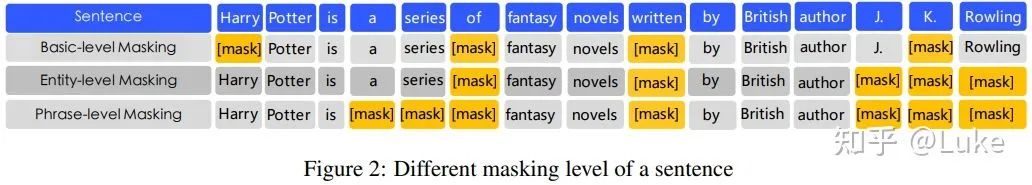

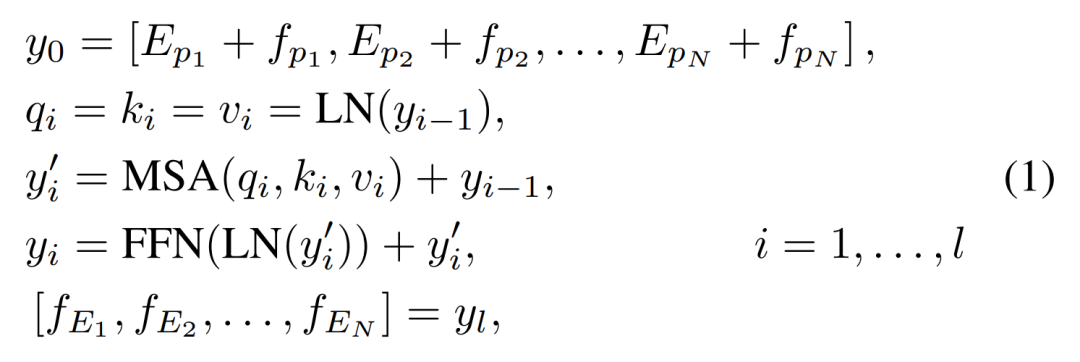

通过分层的Softmax,计算复杂度一下从|K|降低到log|K|。 4.2Word2Vec+深度学习分类器(思路3) 4.2.1 Word2Vec Word2vec,是一群用来产生词向量的相关模型。这些模型为浅而双层的神经网络,用来训练以重新建构语言学之词文本。网络以词表现,并且需猜测相邻位置的输入词,在word2vec中词袋模型假设下,词的顺序是不重要的。训练完成之后,word2vec模型可用来映射每个词到一个向量,可用来表示词对词之间的关系,该向量为神经网络之隐藏层。【百度百科】 Word2vec 是 Word Embedding 的方法之一。他是 2013 年由谷歌的 Mikolov 提出了一套新的词嵌入方法。 4.2.2 优化方法 为了提高速度,Word2vec 经常采用 2 种加速方式: 1、Negative Sample(负采样) 2、Hierarchical Softmax 4.2.3 优缺点 优点: 由于 Word2vec 会考虑上下文,跟之前的 Embedding 方法相比,效果要更好(但不如 18 年之后的方法) 比之前的 Embedding方 法维度更少,所以速度更快 通用性很强,可以用在各种 NLP 任务中 缺点: 由于词和向量是一对一的关系,所以多义词的问题无法解决。 Word2vec 是一种静态的方式,虽然通用性强,但是无法针对特定任务做动态优化 4.3Bert词向量(思路4) BERT(Bidirectional Encoder Representations from Transformers)词向量模型,2018年10月在《BERT: Pre-training of Deep Bidirectional Transformers for Language Understanding》这篇论文中被Google提出,在11种不同nlp测试中创出最佳成绩,包括将glue基准推至80.4%(绝对改进7.6%),multinli准确度达到86.7% (绝对改进率5.6%)等。 4.1.1 特征 1、通过联合调节所有层中的左右上下文来预训练深度双向表示 2、the first fine-tuning based representation model that achieves state-of-the-art performance on a large suite of sentence-level and token-level tasks, outperforming many systems with task-specific architectures 3、所需计算量非常大。Jacob 说:「OpenAI 的 Transformer 有 12 层、768 个隐藏单元,他们使用 8 块 P100 在 8 亿词量的数据集上训练 40 个 Epoch 需要一个月,而 BERT-Large 模型有 24 层、2014 个隐藏单元,它们在有 33 亿词量的数据集上需要训练 40 个 Epoch,因此在 8 块 P100 上可能需要 1 年?16 Cloud TPU 已经是非常大的计算力了。 4、预训练的BERT表示可以通过一个额外的输出层进行微调,适用于广泛任务的state-of-the-art模型的构建,比如问答任务和语言推理,无需针对具体任务做大幅架构修改。

原文标题:【特征提取+分类模型】4种常见的NLP实践思路 文章出处:【微信号:zenRRan,微信公众号:深度学习自然语言处理】欢迎添加关注!文章转载请注明出处。 收藏 人收藏扫一扫,分享给好友 复制链接分享 评论发布评论请先 登录 相关推荐 对比学习的关键技术和基本应用分析 对比学习的主要思想是相似的样本的表示相近,而不相似的远离。对比学习可以应用于监督和无监督的场景下,并.... 达观数据获5.8亿C轮融资,文本智能处理领域首家国家级专精特新小巨人

中国人工智能知名企业达观数据宣布近期已成功完成了C轮5.8亿元融资,并刷新了中国文本智能处理行业的单.... 达观数据获5.8亿C轮融资,文本智能处理领域首家国家级专精特新小巨人

中国人工智能知名企业达观数据宣布近期已成功完成了C轮5.8亿元融资,并刷新了中国文本智能处理行业的单....

AI生明月,万里共文心

今年元宵,伴随着如火如荼的冬奥会。冰雪盛宴不仅展示了体育的魅力与奥林匹克精神,更向全球展现了无所不在.... AI生明月,万里共文心

今年元宵,伴随着如火如荼的冬奥会。冰雪盛宴不仅展示了体育的魅力与奥林匹克精神,更向全球展现了无所不在....

从AI前沿到科技自立:百度大脑的风向标意义

即将过去的2021年,被全球众多科学机构与数据调查报告认为是AI的全面推进之年。 这一年中,AI在生.... 从AI前沿到科技自立:百度大脑的风向标意义

即将过去的2021年,被全球众多科学机构与数据调查报告认为是AI的全面推进之年。 这一年中,AI在生....

2021 OPPO开发者大会:小布技术的内核

10月27日,2021 OPPO开发者大会在上海正式开幕。 2021 OPPO开发者大会以“开放互融....

2021 OPPO开发者大会:小布技术的内核

10月27日,2021 OPPO开发者大会在上海正式开幕。 2021 OPPO开发者大会以“开放互融....

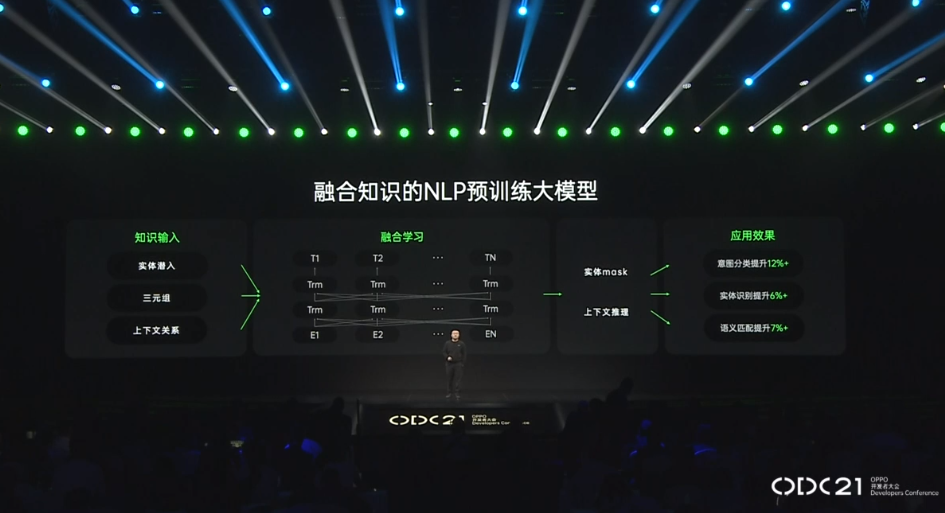

2021 OPPO开发者大会:NLP预训练大模型

2021 OPPO开发者大会:NLP预训练大模型 2021 OPPO开发者大会上介绍了融合知识的NL....

2021 OPPO开发者大会:NLP预训练大模型

2021 OPPO开发者大会:NLP预训练大模型 2021 OPPO开发者大会上介绍了融合知识的NL....

2021OPPO开发者大会 OPPO数智工程事业部总裁刘海峰分析AI服务新生态

2021OPPO开发者大会 OPPO数智工程事业部总裁刘海峰分析AI服务新生态 在小布助手开场之后,....

2021OPPO开发者大会 OPPO数智工程事业部总裁刘海峰分析AI服务新生态

2021OPPO开发者大会 OPPO数智工程事业部总裁刘海峰分析AI服务新生态 在小布助手开场之后,....

大模型的未来在哪?究竟什么是好的大模型?

自2018年谷歌发布BERT以来,预训练大模型经过三年的发展,以强大的算法效果,席卷了NLP为代表的.... 大模型的未来在哪?究竟什么是好的大模型?

自2018年谷歌发布BERT以来,预训练大模型经过三年的发展,以强大的算法效果,席卷了NLP为代表的....

关于PaddleNLP你了解多少

作者:刘健健 来自:ChallengeHub Twitter 的推文有许多特点,首先,与 Faceb....

关于PaddleNLP你了解多少

作者:刘健健 来自:ChallengeHub Twitter 的推文有许多特点,首先,与 Faceb....

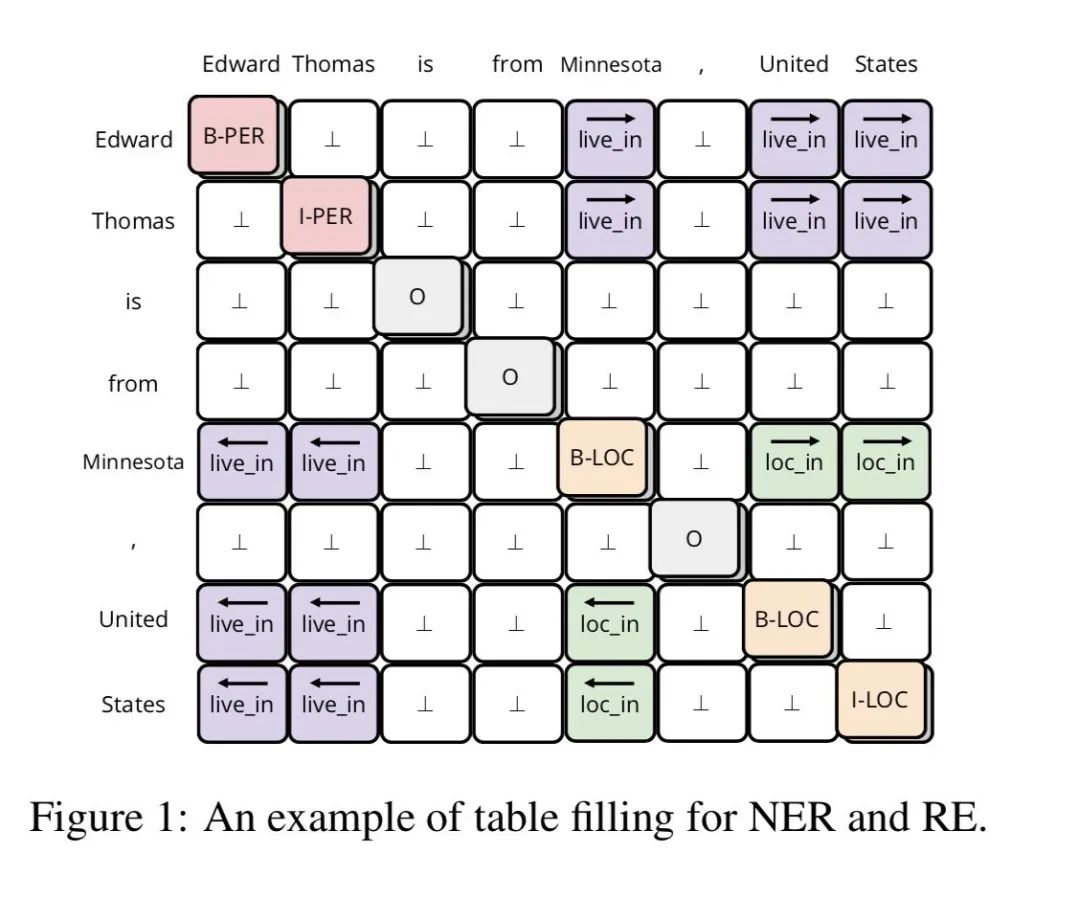

如何解决NER覆盖和不连续问题

论文:A Span-Based Model for Joint Overlapped and Dis....

如何解决NER覆盖和不连续问题

论文:A Span-Based Model for Joint Overlapped and Dis....

NLP中基于联合知识的任务导向型对话系统HyKnow

引言 对话系统(dialogue system)是 NLP 中的的重点研究方向之一。其可以分为任务型....

NLP中基于联合知识的任务导向型对话系统HyKnow

引言 对话系统(dialogue system)是 NLP 中的的重点研究方向之一。其可以分为任务型....

揭秘Prompt的前世今生

作者|闵映乾机构|中国人民大学信息学院硕士方向 | 自然语言处理 来自 | RUC AI Box 导....

揭秘Prompt的前世今生

作者|闵映乾机构|中国人民大学信息学院硕士方向 | 自然语言处理 来自 | RUC AI Box 导....

Transformer的复杂度和高效设计及Transformer的应用

来自:AI部落联盟 前言 这次我们总结一下ACL2021中的Transformers,看看2021年....

Transformer的复杂度和高效设计及Transformer的应用

来自:AI部落联盟 前言 这次我们总结一下ACL2021中的Transformers,看看2021年....

如何使需求质量流程自动化

在以前的博客中:“如何提高您的需求质量”,我回答了三个关键问题: 您如何判断组织内需求的质量? 您如....

如何使需求质量流程自动化

在以前的博客中:“如何提高您的需求质量”,我回答了三个关键问题: 您如何判断组织内需求的质量? 您如....

如何使用TensorFlow进行大规模和分布式的QML模拟

发布人:Google 团队 Cheng Xing 和 Michael Broughton 训练大型机....

如何使用TensorFlow进行大规模和分布式的QML模拟

发布人:Google 团队 Cheng Xing 和 Michael Broughton 训练大型机....

词汇知识融合可能是NLP任务的永恒话题

得益于BERT的加持,Encoder搭配CRF的结构在中文NER上通常都有不错的表现,而且BERT使....

词汇知识融合可能是NLP任务的永恒话题

得益于BERT的加持,Encoder搭配CRF的结构在中文NER上通常都有不错的表现,而且BERT使....

Transformer深度学习架构的应用指南介绍

近年来,自然语言处理(Natural Language Processing, NLP)模型在文本分....

Transformer深度学习架构的应用指南介绍

近年来,自然语言处理(Natural Language Processing, NLP)模型在文本分....

你们知道国内较强的NLP高校实验室有哪些吗?

说一下我了解的学校和实验室!排名不分先后,名单不全,欢迎补充~ 清华大学:孙茂松老师、刘知远 @刘知....

你们知道国内较强的NLP高校实验室有哪些吗?

说一下我了解的学校和实验室!排名不分先后,名单不全,欢迎补充~ 清华大学:孙茂松老师、刘知远 @刘知....

NLP技术对BI而言有那么重要吗?

数字经济时代,数据成为提高生产力、发展生产力的关键要素,蕴含着巨大的使用价值与潜能。因此,对当今企业....

NLP技术对BI而言有那么重要吗?

数字经济时代,数据成为提高生产力、发展生产力的关键要素,蕴含着巨大的使用价值与潜能。因此,对当今企业....

让长短期记忆人工神经网络重返巅峰

1.开篇 去年年底,各大榜单上风起云涌,各路英雄在榜单上为了分数能多个0.01而不停的躁动,迫不及待....

让长短期记忆人工神经网络重返巅峰

1.开篇 去年年底,各大榜单上风起云涌,各路英雄在榜单上为了分数能多个0.01而不停的躁动,迫不及待....

当云计算飞向深空 全面的太空及卫星互联还需等风来

我们多次说起过,当下的“上云”浪潮,源自无数来自于扎实产业土地的真实需求:工厂需要AI,机器人需要算....

当云计算飞向深空 全面的太空及卫星互联还需等风来

我们多次说起过,当下的“上云”浪潮,源自无数来自于扎实产业土地的真实需求:工厂需要AI,机器人需要算....

口语语言理解在任务型对话系统中的探讨

1.1 研究背景与任务定义 口语语言理解在任务型对话系统中扮演了一个非常重要的角色,其目的是识别出用....

口语语言理解在任务型对话系统中的探讨

1.1 研究背景与任务定义 口语语言理解在任务型对话系统中扮演了一个非常重要的角色,其目的是识别出用....

Eleuther AI:已经开源了复现版GPT-3的模型参数

GPT3终于开源!不过,不是官方开的(别打我 Eleuther AI推出的名为GPT-Neo的开源项....

Eleuther AI:已经开源了复现版GPT-3的模型参数

GPT3终于开源!不过,不是官方开的(别打我 Eleuther AI推出的名为GPT-Neo的开源项....

21个经典深度学习句间关系模型

鸽了很久的NLP入门系列终于在我的努力下又更新了。 上次聊了分类任务的模型与技巧,今天我们就来聊聊句....

21个经典深度学习句间关系模型

鸽了很久的NLP入门系列终于在我的努力下又更新了。 上次聊了分类任务的模型与技巧,今天我们就来聊聊句....

牢牢把握深度学习助力产业智能化升级的技术红利

作为中国AI的“头雁”,百度始终都在基于自身优势,在AI核心技术积累、前沿技术探索方面持续深耕。同时....

发表于 03-16 14:27 •

1152次

阅读

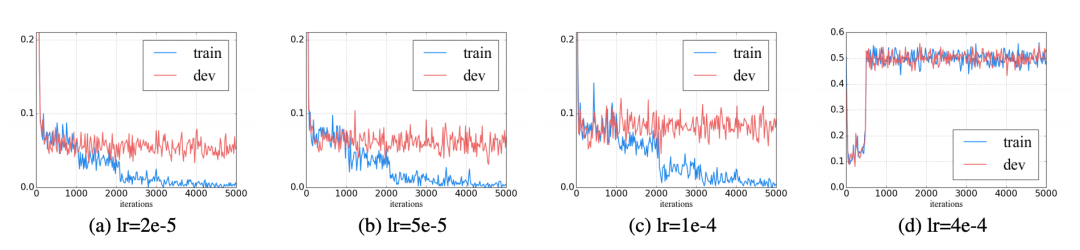

如何让Bert模型在下游任务中提高性能?

随着Transformer 在NLP中的表现,Bert已经成为主流模型,然而大家在下游任务中使用时,....

牢牢把握深度学习助力产业智能化升级的技术红利

作为中国AI的“头雁”,百度始终都在基于自身优势,在AI核心技术积累、前沿技术探索方面持续深耕。同时....

发表于 03-16 14:27 •

1152次

阅读

如何让Bert模型在下游任务中提高性能?

随着Transformer 在NLP中的表现,Bert已经成为主流模型,然而大家在下游任务中使用时,....

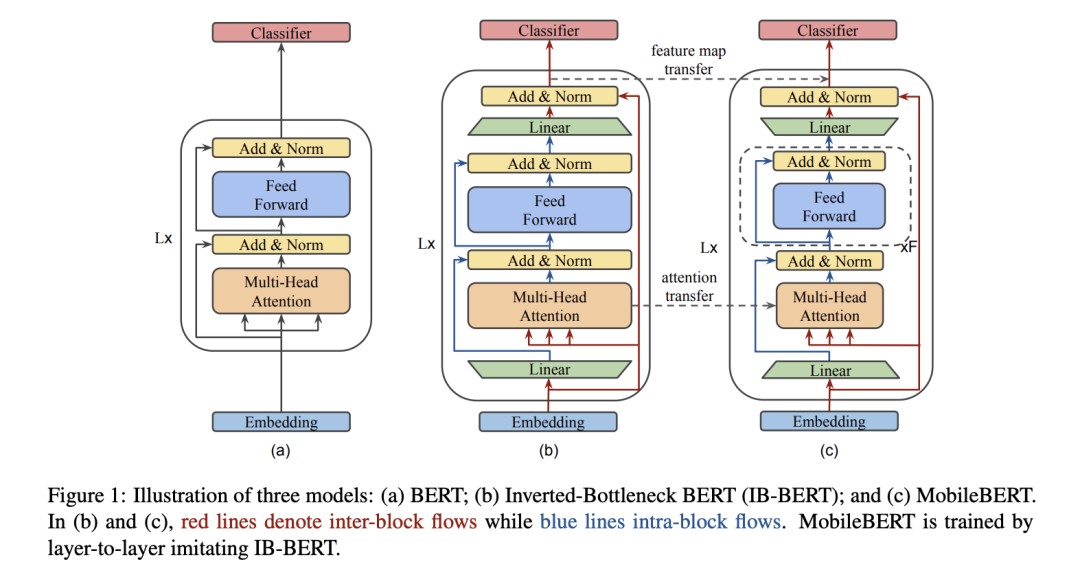

如何通过蒸馏来使小模型具有更好的性能

现在的任务是给定一个词(比如:苹果),然后判断词对应的类别(电视/手机/水果/汽车),假如现在我们有....

如何通过蒸馏来使小模型具有更好的性能

现在的任务是给定一个词(比如:苹果),然后判断词对应的类别(电视/手机/水果/汽车),假如现在我们有....

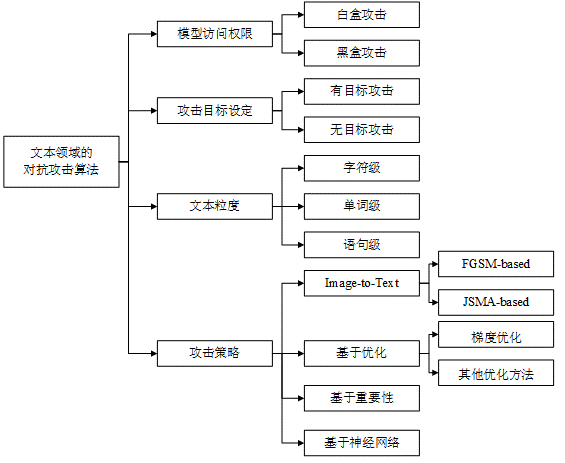

如何在NLP领域实施对抗攻击

当视觉领域中的对抗攻击研究很难再有重大突破的时候(坑已满,请换坑),研究人员便把目光转移到了NLP领....

如何在NLP领域实施对抗攻击

当视觉领域中的对抗攻击研究很难再有重大突破的时候(坑已满,请换坑),研究人员便把目光转移到了NLP领....

利用ImageNet训练了一个能降噪、超分和去雨的图像预训练模型

在上篇文章介绍过了,因为Transformer本身是用于NLP领域的,输入应该是一个序列,因此这篇的....

利用ImageNet训练了一个能降噪、超分和去雨的图像预训练模型

在上篇文章介绍过了,因为Transformer本身是用于NLP领域的,输入应该是一个序列,因此这篇的....

智能客服案例解析:以知识图谱、NLP、机器学习构建高精度对话机器人

乐言科技基于高精准的语义理解技术所打造的客服机器人,能在海量数据中挖掘优质话术,模拟优秀人工客服回复....

智能客服案例解析:以知识图谱、NLP、机器学习构建高精度对话机器人

乐言科技基于高精准的语义理解技术所打造的客服机器人,能在海量数据中挖掘优质话术,模拟优秀人工客服回复....

天池公益赛“新冠疫情相似句对判定大赛”NLP赛道top指南

2020年初,新冠疫情席卷全球。除了“待在家,不乱跑”,我想还能从哪为抗击疫情出点微薄之力呢? 碰巧....

天池公益赛“新冠疫情相似句对判定大赛”NLP赛道top指南

2020年初,新冠疫情席卷全球。除了“待在家,不乱跑”,我想还能从哪为抗击疫情出点微薄之力呢? 碰巧....

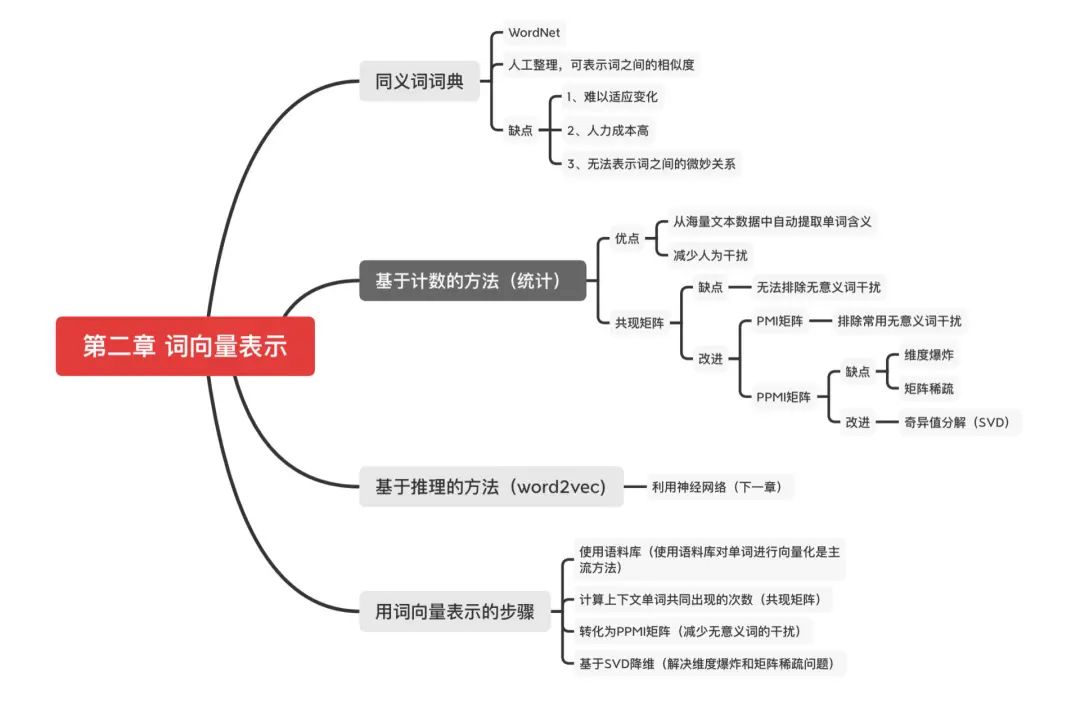

神经网络中词向量是怎么表示的?

上一篇我们讲到了在神经网络出现以前的词向量表示方法:基于同义词词典的方法和基于计数统计的方法。想要回....

神经网络中词向量是怎么表示的?

上一篇我们讲到了在神经网络出现以前的词向量表示方法:基于同义词词典的方法和基于计数统计的方法。想要回....

一种处理多标签文本分类的新颖推理机制

研究动机 多标签文本分类(multi-label text classification, 简称ML....

一种处理多标签文本分类的新颖推理机制

研究动机 多标签文本分类(multi-label text classification, 简称ML....

手把手教你搭建NLP经典模型

上一篇我们讲到了最简单的词向量表示方法——共现矩阵(没有看的朋友可以点击这里 小白跟学系列之手把手搭....

手把手教你搭建NLP经典模型

上一篇我们讲到了最简单的词向量表示方法——共现矩阵(没有看的朋友可以点击这里 小白跟学系列之手把手搭....

tf的优点有哪些

tf的优点介绍

发表于 06-03 09:47 •

961次

阅读

NLP的tfidf作词向量

NLP之tfidf作词向量

发表于 06-01 17:28 •

638次

阅读

全面拥抱Transformer:NLP三大特征抽取器(CNNRNNTF)比较

放弃幻想,全面拥抱Transformer:NLP三大特征抽取器(CNNRNNTF)比较...

发表于 05-29 10:43 •

1016次

阅读

NLP的面试题目

NLP面试题目6-10

发表于 05-21 15:02 •

1185次

阅读

MaxMatch文本匹配算法的实现

NLP 文本匹配算法

发表于 03-13 11:12 •

1185次

阅读

基于softmax模型的多分类逻辑回归

深度学习核心技术实战 NLP-word2vec

发表于 06-12 15:12 •

723次

阅读

浅析word2vec的安装和使用方法

NLP之word2vec:word2vec简介、安装、使用方法之详细攻略...

发表于 12-25 10:32 •

3675次

阅读

NLP学习:HanLP使用实验

在之前的实验中得到了不在词向量里的词与分词结果,结果有500多个词不在词向量里,解决方案就是重新分词,或再追加训练这些词到词...

发表于 11-14 11:07 •

2415次

阅读

tf的优点有哪些

tf的优点介绍

发表于 06-03 09:47 •

961次

阅读

NLP的tfidf作词向量

NLP之tfidf作词向量

发表于 06-01 17:28 •

638次

阅读

全面拥抱Transformer:NLP三大特征抽取器(CNNRNNTF)比较

放弃幻想,全面拥抱Transformer:NLP三大特征抽取器(CNNRNNTF)比较...

发表于 05-29 10:43 •

1016次

阅读

NLP的面试题目

NLP面试题目6-10

发表于 05-21 15:02 •

1185次

阅读

MaxMatch文本匹配算法的实现

NLP 文本匹配算法

发表于 03-13 11:12 •

1185次

阅读

基于softmax模型的多分类逻辑回归

深度学习核心技术实战 NLP-word2vec

发表于 06-12 15:12 •

723次

阅读

浅析word2vec的安装和使用方法

NLP之word2vec:word2vec简介、安装、使用方法之详细攻略...

发表于 12-25 10:32 •

3675次

阅读

NLP学习:HanLP使用实验

在之前的实验中得到了不在词向量里的词与分词结果,结果有500多个词不在词向量里,解决方案就是重新分词,或再追加训练这些词到词...

发表于 11-14 11:07 •

2415次

阅读

|

【本文地址】