| Hive数据仓库(分析存储在hdfs上面的数据) | 您所在的位置:网站首页 › hive本身不存储和处理数据 › Hive数据仓库(分析存储在hdfs上面的数据) |

Hive数据仓库(分析存储在hdfs上面的数据)

|

启动命令

[root@node1 conf]# nohup hive --service metastore & nohup是放入后台 Hive的产生非java编程者对hdfs的数据做mapreduce操作 Hive简介Hive : 数据仓库。 Hive:解释器,编译器,优化器等。 Hive 运行时,元数据存储在关系型数据库(mysql)里面  Metastore:Mysq Driver:Hive Compiler:解释器 Hadoop:Hadoop 数据来源

Hive搭建 Metastore:Mysq Driver:Hive Compiler:解释器 Hadoop:Hadoop 数据来源

Hive搭建

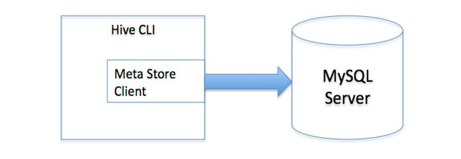

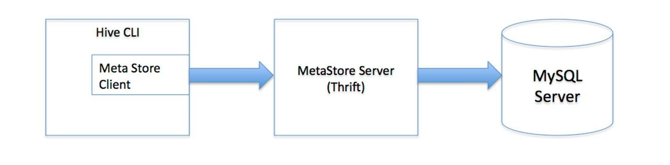

Hive的搭建模式 local模式。 此模式连接到一个In-memory 的数据库Derby,一般用于Unit Test。 Mysql模式: 单用户模式: 多用户模式: 通过网络连接到一个数据库中,是最经常使用到的模式: 远程服务器模式/多用户模式。 用于非Java客户端访问元数据库,在服务器端启动MetaStoreServer,客户端利用Thrift协议通过MetaStoreServer访问元数据库

只能本机进入mysql 我们想让node2 node3也能访问 mysql> GRANT ALL PRIVILEGES ON *.* TO 'root'@'%' IDENTIFIED BY '123' WITH GRANT OPTION;*.*让所有root用户所有ip地址都可以访问mysql密码是123 mysql> delete from user where host!="%"; [root@node1 conf]# pwd /root/apache-hive-1.2.1-bin/conf [root@node1 conf]# vi hive-site.xml hive.metastore.warehouse.dir /user/hive_01/warehouse javax.jdo.option.ConnectionURL jdbc:mysql://node1/hive_01?createDatabaseIfNotExist=true javax.jdo.option.ConnectionDriverName com.mysql.jdbc.Driver javax.jdo.option.ConnectionUserName root javax.jdo.option.ConnectionPassword 123上传驱动 [root@node1 ~]# mv mysql-connector-java-5.1.32-bin.jar apache-hive-1.2.1-bin/lib/ [root@node1 lib]# pwd /root/apache-hive-1.2.1-bin/lib [root@node1 lib]# cp jline-2.12.jar /root/hadoop-2.6.5/share/hadoop/yarn/lib/ [root@node1 lib]# pwd /root/hadoop-2.6.5/share/hadoop/yarn/lib [root@node1 lib]# rm -rf jline-0.9.94.jar [root@node1 ~]# vi .bash_profile #hive export HIVE_HOME=/root/apache-hive-1.2.1-bin export PATH=$PATH:$HIVE_HOME/bin[root@node1 ~]# source .bash_profile [root@node1 ~]# hive 可以进去 多用户配置[root@no |

【本文地址】

[root@node1 ~]# yum -y install mysql-server [root@node1 ~]# service mysqld start [root@node1 ~]# chkconfig mysqld on(开机自启动) 进入mysql [root@node1 ~]# mysql mysql> show databases;库 mysql> use mysql进入库 mysql> show tables;展示表 mysql> select host,password from user;

[root@node1 ~]# yum -y install mysql-server [root@node1 ~]# service mysqld start [root@node1 ~]# chkconfig mysqld on(开机自启动) 进入mysql [root@node1 ~]# mysql mysql> show databases;库 mysql> use mysql进入库 mysql> show tables;展示表 mysql> select host,password from user;